Com informações da Agência USP - 06/06/2011

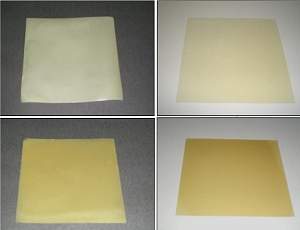

O extrato de própolis foi adicionado em diferentes concentrações em relação à gelatina, o que altera a eficiência e a aparência do filme plástico antimicrobiano. [Imagem: Renata Barbosa Bodini]

Pesquisadora da Universidade de São Paulo (USP) desenvolveu um novo filme plástico para uso em embalagens de alimentos com propriedades antimicrobianas.

O material ganhou sua propriedade bioativa com a adição de própolis.

Os polímeros, mais comumente conhecidos como plásticos, são materiais que têm utilização em larga escala pela indústria e podem servir para inúmeras funções.

Plástico com própolis

Sabendo disso, a engenheira de alimentos Renata Barbosa Bodini desenvolveu seu novo material polimérico bioativo à base de gelatina e própolis

A propriedade antimicrobiana do própolis foi transferida para o filme, tornando-o ideal para a embalagem e conservação de alimentos.

A gelatina já é usada experimentalmente na produção de filmes biodegradáveis, como uma alternativa para substituir os polímeros sintéticos, como o plástico.

O primeiro passo do estudo consistiu na adição de extrato etanólico de própolis (EEP) à gelatina, para formar os filmes plásticos, o que mostrou viabilidade da ideia.

"A própolis é uma substância que possui comprovadamente propriedade antimicrobiana, e seria necessário verificar se essa característica seria mantida nos filmes, caracterizando a bioatividade", conta Renata.

Plástico antimicrobiano

A atividade antimicrobiana foi avaliada tanto no EEP isolado como nos filmes biodegradáveis.

As análises foram feitas por 177 dias, com observações a cada 28 dias, e o resultado foi positivo: a propriedade foi conservada em ambos os casos.

A pesquisa de Renata produziu um material biodegradável, com capacidade antimicrobiana e fabricado a partir de um produto natural encontrado em abundância. Deste modo, a engenheira acredita que seu estudo pode ter uma utilidade imediata.

O filme plástico antimicrobiano é formado por vários componentes: gelatina (comum), material plastificante (foram utilizados o sorbitol e o citrato de acetil tributila), álcool etílico e o extrato de própolis.

O microorganismo utilizado para colocar à prova a propriedade antimicrobiana do filme foi a bactéria Staphylococcus aureus. O EEP ainda foi testado em diferentes concentrações em relação à gelatina: 5%, 40% e 200%. Tal diferenciação foi útil, já que os resultados foram diferentes.

Quando o extrato etanólico de própolis foi utilizado em concentração de 40% e 200%, os filmes apresentaram a atividade antimicrobiana. Já na concentração de 5%, a Staphylococcus aureus cresceu sobre o filme biodegradável, demonstrando que esta concentração não tem efeito inibitório.

Cheiro de própolis

A ideia inicial era a de que os filmes biodegradáveis com propriedades bioativas pudessem ser utilizados comercialmente como embalagens, mas Renata explica que há desafios pela frente:

"O método utilizado inicialmente na produção, chamado casting, é laboratorial e por enquanto não é viável para produção em larga escala. Além disso, o própolis tem um aroma muito forte e característico que foi passado para os filmes, o que dificulta a utilização deles para embalagem.

Mas isso não significa que não haja possibilidade de uso comercial: os filmes podem ser utilizados para embalar produtos de origem animal ou podem servir de suporte para o aditivo (própolis). Mas todas essas utilizações têm que ser testadas, e serão necessárias pesquisas complementares para se avaliar o potencial de aplicação do material," conclui Renata.

Fonte;http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=propolis-capacidade-antimicrobiana-plasticos&id=010160110606&ebol=sim

Translate

terça-feira, 7 de junho de 2011

Reciclar e remanufaturar sempre vale a pena?

Com informações do MIT - 06/06/2011

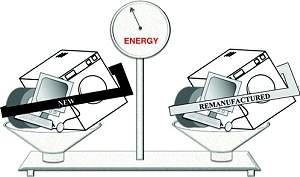

Há um número igual de situações nas quais a remanufatura de fato consome mais energia do que fazer um produto do zero. [Imagem: Gutowski et al.]

Senso comum

A reciclagem e a remanufatura de produtos - em vez de fazer produtos novos a partir do zero - deve permitir uma grande economia de energia, certo?

Não exatamente, garante um novo estudo realizado por pesquisadores do MIT, nos Estados Unidos.

Amplamente difundidas como ambientalmente corretas, as práticas de reciclagem e remanufatura são usadas desde as latinhas de alumínio e os pneus recauchutados, até os cartuchos de impressora jato de tinta e os motores remanufaturados.

Mas a equipe do Dr. Timothy Gutowski demonstrou que o senso comum não se confirma quando os dados são cuidadosamente verificados.

Custo energético

Em alguns casos, a sabedoria convencional está realmente correta. Mas, em 25 estudos de caso, cobrindo produtos em oito categorias, há um número igual de situações nas quais a remanufatura de fato consome mais energia.

E para a maioria dos casos, a economia de energia é insignificante ou o equilíbrio de energia esteve muito próximo entre o produto novo e o produto remanufaturado.

Mas por que os novos resultados são tão diferentes do que se tem assumido por tanto tempo?

A razão está em que a equipe do MIT usou em seus cálculos a energia total utilizada durante a vida útil de um produto - a chamada análise do ciclo de vida - e não apenas a energia utilizada no processo de fabricação em si.

Em praticamente todos os casos, custa menos dinheiro e menos energia produzir um produto a partir de um "núcleo" reciclado - a parte reutilizável do produto - do que começar do zero a partir da matéria-prima.

Mas o problema é que muitos desses produtos remanufaturados são menos eficientes em termos energéticos, ou versões mais recentes são mais eficientes em termos energéticos do que a geração à qual eles pertenceram, de modo que a energia extra utilizada ao longo da vida útil do produto remanufaturado anula a economia obtida na fase de fabricação.

O mundo é um lugar complicado

"O que parece à primeira vista ser um problema simples, mostra que o mundo é um lugar muito mais complicado do que as pessoas pensam," afirma Gutowski, que já havia coordenado um estudo que demonstra que as indústrias modernas são extravagantes no uso de energia.

Para ele, na maioria dos casos, "a nova tecnologia revela-se tão mais eficiente do ponto de vista energético, que você deve se livrar do velho aparelho" em vez de consertá-lo ou comprar uma versão remanufaturada.

Por exemplo, a eficiência de muitos aparelhos novos - como geladeiras e máquinas de lavar - é tão melhor em relação aos modelos mais antigos que, em termos de consumo de energia, um novo modelo é quase sempre a melhor escolha.

Infelizmente, não é assim que a maioria das pessoas e empresas faz suas escolhas. "A decisão é sempre em relação ao custo, não à energia", diz Gutowski.

Por exemplo, um motor elétrico remanufaturado, no qual o núcleo de metal é reutilizado, mas enrolado com novos fios, é tipicamente entre 0,5 e 1 por cento menos eficiente do que um motor novo. "Continua havendo uma vantagem de custo" para os motores remanufaturados, diz o pesquisador, "mas, do ponto de vista energético, é o oposto."

Visão mais ampla

Gutowski enfatiza que esta pesquisa não sugere, necessariamente, um curso específico de ação.

Para um determinado produto, pode haver outras razões para que se prefira a versão remanufaturada, mesmo que esta produza um gasto líquido de energia.

Por exemplo, a remanufatura pode reduzir o impacto sobre os aterros sanitários, reduzir o uso e o descarte de alguns materiais tóxicos, ou gerar empregos necessários em uma determinada área.

"Nós não estamos dizendo que você não deve fazer [a remanufatura]", diz ele, "[estamos] apenas sugerindo que vale a pena conhecer os efeitos da decisão, na sua totalidade."

Bibliografia:

Remanufacturing and Energy Savings

Timothy G. Gutowski, Sahil Sahni, Avid Boustani, Stephen C. Graves

Environmental Science & Technology

Vol.: 2011, 45 (10), pp 4540-4547

DOI: 10.1021/es102598b

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=reciclar-remanufaturar&id=010125110606&ebol=sim

Há um número igual de situações nas quais a remanufatura de fato consome mais energia do que fazer um produto do zero. [Imagem: Gutowski et al.]

Senso comum

A reciclagem e a remanufatura de produtos - em vez de fazer produtos novos a partir do zero - deve permitir uma grande economia de energia, certo?

Não exatamente, garante um novo estudo realizado por pesquisadores do MIT, nos Estados Unidos.

Amplamente difundidas como ambientalmente corretas, as práticas de reciclagem e remanufatura são usadas desde as latinhas de alumínio e os pneus recauchutados, até os cartuchos de impressora jato de tinta e os motores remanufaturados.

Mas a equipe do Dr. Timothy Gutowski demonstrou que o senso comum não se confirma quando os dados são cuidadosamente verificados.

Custo energético

Em alguns casos, a sabedoria convencional está realmente correta. Mas, em 25 estudos de caso, cobrindo produtos em oito categorias, há um número igual de situações nas quais a remanufatura de fato consome mais energia.

E para a maioria dos casos, a economia de energia é insignificante ou o equilíbrio de energia esteve muito próximo entre o produto novo e o produto remanufaturado.

Mas por que os novos resultados são tão diferentes do que se tem assumido por tanto tempo?

A razão está em que a equipe do MIT usou em seus cálculos a energia total utilizada durante a vida útil de um produto - a chamada análise do ciclo de vida - e não apenas a energia utilizada no processo de fabricação em si.

Em praticamente todos os casos, custa menos dinheiro e menos energia produzir um produto a partir de um "núcleo" reciclado - a parte reutilizável do produto - do que começar do zero a partir da matéria-prima.

Mas o problema é que muitos desses produtos remanufaturados são menos eficientes em termos energéticos, ou versões mais recentes são mais eficientes em termos energéticos do que a geração à qual eles pertenceram, de modo que a energia extra utilizada ao longo da vida útil do produto remanufaturado anula a economia obtida na fase de fabricação.

O mundo é um lugar complicado

"O que parece à primeira vista ser um problema simples, mostra que o mundo é um lugar muito mais complicado do que as pessoas pensam," afirma Gutowski, que já havia coordenado um estudo que demonstra que as indústrias modernas são extravagantes no uso de energia.

Para ele, na maioria dos casos, "a nova tecnologia revela-se tão mais eficiente do ponto de vista energético, que você deve se livrar do velho aparelho" em vez de consertá-lo ou comprar uma versão remanufaturada.

Por exemplo, a eficiência de muitos aparelhos novos - como geladeiras e máquinas de lavar - é tão melhor em relação aos modelos mais antigos que, em termos de consumo de energia, um novo modelo é quase sempre a melhor escolha.

Infelizmente, não é assim que a maioria das pessoas e empresas faz suas escolhas. "A decisão é sempre em relação ao custo, não à energia", diz Gutowski.

Por exemplo, um motor elétrico remanufaturado, no qual o núcleo de metal é reutilizado, mas enrolado com novos fios, é tipicamente entre 0,5 e 1 por cento menos eficiente do que um motor novo. "Continua havendo uma vantagem de custo" para os motores remanufaturados, diz o pesquisador, "mas, do ponto de vista energético, é o oposto."

Visão mais ampla

Gutowski enfatiza que esta pesquisa não sugere, necessariamente, um curso específico de ação.

Para um determinado produto, pode haver outras razões para que se prefira a versão remanufaturada, mesmo que esta produza um gasto líquido de energia.

Por exemplo, a remanufatura pode reduzir o impacto sobre os aterros sanitários, reduzir o uso e o descarte de alguns materiais tóxicos, ou gerar empregos necessários em uma determinada área.

"Nós não estamos dizendo que você não deve fazer [a remanufatura]", diz ele, "[estamos] apenas sugerindo que vale a pena conhecer os efeitos da decisão, na sua totalidade."

Bibliografia:

Remanufacturing and Energy Savings

Timothy G. Gutowski, Sahil Sahni, Avid Boustani, Stephen C. Graves

Environmental Science & Technology

Vol.: 2011, 45 (10), pp 4540-4547

DOI: 10.1021/es102598b

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=reciclar-remanufaturar&id=010125110606&ebol=sim

Haddad vai à Câmara amanhã (7) discutir educação profissional

Ele participa de audiência pública para discutir o Projeto de Lei 1209/11, do Executivo, que institui o Programa Nacional de Acesso ao Ensino Técnico e Emprego (Pronatec).

O evento é realizado pelas comissões de Educação e Cultura; de Trabalho, de Administração e Serviço Público; de Finanças e Tributação; e de Constituição e Justiça e de Cidadania.

A proposta prevê a oferta de bolsas para estudantes em cursos de formação profissional, a garantia de financiamento na rede privada de ensino e a expansão das vagas em escolas públicas. Para a execução das duas primeiras medidas, a previsão de gastos é de R$ 700 milhões e R$ 300 milhões, respectivamente.

De acordo com a presidente da Comissão de Educação e Cultura, deputada Fátima Bezerra (PT-RN), o debate permitirá que os colegiados elaborem um texto conjunto sobre o projeto, o que facilitará sua tramitação. Na opinião dela, o Pronatec vai alavancar os ensinos médio e profissionalizante em todo o País.

A audiência é às 14h30, no Plenário10.

(Agência Câmara)

fonte:http://www.jornaldaciencia.org.br/Detalhe.jsp?id=77861

O evento é realizado pelas comissões de Educação e Cultura; de Trabalho, de Administração e Serviço Público; de Finanças e Tributação; e de Constituição e Justiça e de Cidadania.

A proposta prevê a oferta de bolsas para estudantes em cursos de formação profissional, a garantia de financiamento na rede privada de ensino e a expansão das vagas em escolas públicas. Para a execução das duas primeiras medidas, a previsão de gastos é de R$ 700 milhões e R$ 300 milhões, respectivamente.

De acordo com a presidente da Comissão de Educação e Cultura, deputada Fátima Bezerra (PT-RN), o debate permitirá que os colegiados elaborem um texto conjunto sobre o projeto, o que facilitará sua tramitação. Na opinião dela, o Pronatec vai alavancar os ensinos médio e profissionalizante em todo o País.

A audiência é às 14h30, no Plenário10.

(Agência Câmara)

fonte:http://www.jornaldaciencia.org.br/Detalhe.jsp?id=77861

Tecnologia brasileira micrometros à frente

Foi na década de 1950 que sugiram os primeiros computadores que funcionavam por meio de circuitos eletrônicos, feitos com válvulas, e pesavam até 30 toneladas.

Alguns anos mais tarde, entre 1959 e 1965, surgiram os computadores de segunda geração, apesar de enormes, as válvulas usadas anteriormente foram substituídas pelos transistores, que além de 100 vezes menores, consumiam menos energia, eram mais rápidos e confiáveis.

A partir da terceira geração, os transistores foram substituídos pelos circuitos integrados (CI). Essa tecnologia consiste em um grande número de transistores microscópicos, acoplados a uma única pastilha de silício. Isso permitiu a construção de circuitos microeletrônicos responsáveis pela melhoraria significativa do desempenho e confiabilidade, além da redução dos custos de fabricação e de consumo de energia dos microchips. Atualmente, praticamente todos os componentes eletrônicos são miniaturizados e montados em um único chip.

O desenvolvimento dos CI e da chamada microeletrônica não parou. O mundo continua desenvolvendo grandes pesquisas nesse âmbito, no Brasil não é diferente. Fruto do Edital de Circuitos Integrados - Brasil Fase 2, lançado pelo CNPq em 2008, o Projeto de Uma Design House Especializada em Componentes Integrados para os setores Aeroespacial, de Defesa e de Comunicação e que originou a Santa Maria Design House (SMDH) vem se destacando sob a coordenação do professor e bolsista do CNPq, João Baptista dos Santos Martins. "O projeto é desenvolvido desde setembro de 2009 e já conseguiu avanços significativos até agora", afirma Baptista.

O principal objetivo é criar soluções inovadoras em microeletrônica, por meio do desenvolvimento de projetos de CI, que vão da especificação, codificação, verificação e teste, para clientes públicos e privados, passando por serviços de back-end, fase final de desenvolvimento de um chip, até a busca de parcerias com Institutos de Pesquisa e Desenvolvimento.

Tecnologia de ponta - Nos quase dois anos do projeto foram desenvolvidos quatro produtos tecnológicos. O principal deles é o microcontrolador (MCU) ZR16 , uma espécie de computador - num chip que contém processador, memória e vários periféricos analógicos. Esse microprocessador pode ser programado para funções específicas e ser "embarcado" em outro dispositivo, para controlar as funções ou ações do produto.

Desenvolvido em parceria com a Chipus Microelectronics , também financiada pelo CI Brasil, o ZR16 é o primeiro microcontrolador genuinamente brasileiro de propósito geral e para uso em escala comercial. "O ZR16 representa em primeiro lugar a capacidade dos brasileiros para entrar no seleto grupo da alta tecnologia. Em termos econômicos o mercado mundial de microcontroladores chega a produzir 12 bilhões de unidades-ano. O MCU poderá atender milhões de unidades, no mínimo.

Portanto, o valor agregado para a economia brasileira em médio prazo é extremamente promissor. Com ele, podemos começar a pensar em reduzir o déficit causado pela importação de componentes eletrônicos" ressalta Baptista. A empresa Exatron Indústria Eletrônica LTDA, sediada em Porto Alegre, vai começar a utilizar o ZR16 tão logo ele seja colocado em escala industrial, o que está previsto para o segundo semestre de 2012.

Outra invenção desenvolvida pela SMDH e pela Chipus é o conversor analógico digital de 12 bits, esse circuito faz a conversão de valores reais ou analógicos, para valores digitais. A SMDH também trabalha com circuitos tolerantes a radiação. Para projetar este tipo de circuito é necessário que exista uma biblioteca de células tolerantes a radiação.

Hoje, esta biblioteca de células está sendo projetada e desenvolvida de forma pioneira no Brasil na SMDH, pois nem a Agencia Espacial Norte Americana (Nasa) e nem a Agencia Espacial Européia (ESA) disponibilizam as suas biliotecas, consideradas estratégicas para os países que a detém. Este tipo de circuito é usado para a fabricação de chips embarcados em satélites, mísseis teleguiados e naves espaciais, por exemplo.

Finalizando, uma chave liga-desliga tolerante a radiação está sendo projetada e será usada pelo Instituto Nacional de Pesquisas Espaciais (Inpe) de São José dos Campos (SP). O grande desafio é fazer este dispositivo funcionar adequadamente quando submetido a efeitos de radiação eletromagnética e cósmica, o que acontece quando um circuito está no espaço, embarcado em um satélite. Este circuito está retornando da fabricação e entra em teste no primeiro trimestre de 2012.

O professor João Baptista afirma que essa transferência de tecnologia para o setor produtivo irá contribuir significativamente para o desenvolvimento do país. "Hoje o Brasil tem um déficit de semicondutores que chega a US$ 10 bilhões ano. Isto apenas se considerarmos componentes integrados. À medida que nossos Centros de Design, em especial as que fazem parte do Programa CI-Brasil, começarem a produzir, este déficit começará a cair, sendo o setor produtivo brasileiro beneficiado diretamente por esta mudança de paradigma", completa Baptista.

Em busca do tempo perdido - Para Baptista, o Brasil ficou muito tempo afastado dessa área de pesquisa e desenvolvimento. Contudo, a situação está mudando graças à atual situação econômica e ao ritmo de crescimento do País. "Cada vez mais empresas estrangeiras vêm ao Brasil em busca de parcerias e projetos estratégicos. A comunidade brasileira pode esperar grandes avanços na área de microeletrônica, o que significará melhora da situação econômica brasileira e principalmente domínio tecnológico de produtos na área de eletrônica", finaliza.

A SMDH é composta por uma equipe de projetistas de circuitos digitais de codificação e verificação, projetistas de circuitos analógicos, engenheiro de aplicação e teste e equipe de suporte de Tecnologia da Informação (TI) e de suporte a ferramentas de EDA ( Eletronic Design Automation ). EDA são softwares de computador que auxiliam diretamente o projetista no desenvolvimento de circuitos integrados. Por serem programas muito complexos, sua licença anual poderá custar até US$ 1 milhão.

(Ascom CNPq)

Fonte:http://www.jornaldaciencia.org.br/Detalhe.jsp?id=77853

Alguns anos mais tarde, entre 1959 e 1965, surgiram os computadores de segunda geração, apesar de enormes, as válvulas usadas anteriormente foram substituídas pelos transistores, que além de 100 vezes menores, consumiam menos energia, eram mais rápidos e confiáveis.

A partir da terceira geração, os transistores foram substituídos pelos circuitos integrados (CI). Essa tecnologia consiste em um grande número de transistores microscópicos, acoplados a uma única pastilha de silício. Isso permitiu a construção de circuitos microeletrônicos responsáveis pela melhoraria significativa do desempenho e confiabilidade, além da redução dos custos de fabricação e de consumo de energia dos microchips. Atualmente, praticamente todos os componentes eletrônicos são miniaturizados e montados em um único chip.

O desenvolvimento dos CI e da chamada microeletrônica não parou. O mundo continua desenvolvendo grandes pesquisas nesse âmbito, no Brasil não é diferente. Fruto do Edital de Circuitos Integrados - Brasil Fase 2, lançado pelo CNPq em 2008, o Projeto de Uma Design House Especializada em Componentes Integrados para os setores Aeroespacial, de Defesa e de Comunicação e que originou a Santa Maria Design House (SMDH) vem se destacando sob a coordenação do professor e bolsista do CNPq, João Baptista dos Santos Martins. "O projeto é desenvolvido desde setembro de 2009 e já conseguiu avanços significativos até agora", afirma Baptista.

O principal objetivo é criar soluções inovadoras em microeletrônica, por meio do desenvolvimento de projetos de CI, que vão da especificação, codificação, verificação e teste, para clientes públicos e privados, passando por serviços de back-end, fase final de desenvolvimento de um chip, até a busca de parcerias com Institutos de Pesquisa e Desenvolvimento.

Tecnologia de ponta - Nos quase dois anos do projeto foram desenvolvidos quatro produtos tecnológicos. O principal deles é o microcontrolador (MCU) ZR16 , uma espécie de computador - num chip que contém processador, memória e vários periféricos analógicos. Esse microprocessador pode ser programado para funções específicas e ser "embarcado" em outro dispositivo, para controlar as funções ou ações do produto.

Desenvolvido em parceria com a Chipus Microelectronics , também financiada pelo CI Brasil, o ZR16 é o primeiro microcontrolador genuinamente brasileiro de propósito geral e para uso em escala comercial. "O ZR16 representa em primeiro lugar a capacidade dos brasileiros para entrar no seleto grupo da alta tecnologia. Em termos econômicos o mercado mundial de microcontroladores chega a produzir 12 bilhões de unidades-ano. O MCU poderá atender milhões de unidades, no mínimo.

Portanto, o valor agregado para a economia brasileira em médio prazo é extremamente promissor. Com ele, podemos começar a pensar em reduzir o déficit causado pela importação de componentes eletrônicos" ressalta Baptista. A empresa Exatron Indústria Eletrônica LTDA, sediada em Porto Alegre, vai começar a utilizar o ZR16 tão logo ele seja colocado em escala industrial, o que está previsto para o segundo semestre de 2012.

Outra invenção desenvolvida pela SMDH e pela Chipus é o conversor analógico digital de 12 bits, esse circuito faz a conversão de valores reais ou analógicos, para valores digitais. A SMDH também trabalha com circuitos tolerantes a radiação. Para projetar este tipo de circuito é necessário que exista uma biblioteca de células tolerantes a radiação.

Hoje, esta biblioteca de células está sendo projetada e desenvolvida de forma pioneira no Brasil na SMDH, pois nem a Agencia Espacial Norte Americana (Nasa) e nem a Agencia Espacial Européia (ESA) disponibilizam as suas biliotecas, consideradas estratégicas para os países que a detém. Este tipo de circuito é usado para a fabricação de chips embarcados em satélites, mísseis teleguiados e naves espaciais, por exemplo.

Finalizando, uma chave liga-desliga tolerante a radiação está sendo projetada e será usada pelo Instituto Nacional de Pesquisas Espaciais (Inpe) de São José dos Campos (SP). O grande desafio é fazer este dispositivo funcionar adequadamente quando submetido a efeitos de radiação eletromagnética e cósmica, o que acontece quando um circuito está no espaço, embarcado em um satélite. Este circuito está retornando da fabricação e entra em teste no primeiro trimestre de 2012.

O professor João Baptista afirma que essa transferência de tecnologia para o setor produtivo irá contribuir significativamente para o desenvolvimento do país. "Hoje o Brasil tem um déficit de semicondutores que chega a US$ 10 bilhões ano. Isto apenas se considerarmos componentes integrados. À medida que nossos Centros de Design, em especial as que fazem parte do Programa CI-Brasil, começarem a produzir, este déficit começará a cair, sendo o setor produtivo brasileiro beneficiado diretamente por esta mudança de paradigma", completa Baptista.

Em busca do tempo perdido - Para Baptista, o Brasil ficou muito tempo afastado dessa área de pesquisa e desenvolvimento. Contudo, a situação está mudando graças à atual situação econômica e ao ritmo de crescimento do País. "Cada vez mais empresas estrangeiras vêm ao Brasil em busca de parcerias e projetos estratégicos. A comunidade brasileira pode esperar grandes avanços na área de microeletrônica, o que significará melhora da situação econômica brasileira e principalmente domínio tecnológico de produtos na área de eletrônica", finaliza.

A SMDH é composta por uma equipe de projetistas de circuitos digitais de codificação e verificação, projetistas de circuitos analógicos, engenheiro de aplicação e teste e equipe de suporte de Tecnologia da Informação (TI) e de suporte a ferramentas de EDA ( Eletronic Design Automation ). EDA são softwares de computador que auxiliam diretamente o projetista no desenvolvimento de circuitos integrados. Por serem programas muito complexos, sua licença anual poderá custar até US$ 1 milhão.

(Ascom CNPq)

Fonte:http://www.jornaldaciencia.org.br/Detalhe.jsp?id=77853

Por que somos tão ruins em matemática?

Para brasileiro gostar da disciplina, mudança tem de começar na sala de aula das faculdades que formam os futuros docentes.

A aversão é tanta que o senso comum aponta: o brasileiro já nasce sem vocação para aprender matemática. O estudo na área começa com professores sem formação específica, que em geral não gostam da disciplina, e acaba com docentes que têm conteúdo para transmitir, mas não didática. No fim do ensino médio, exames confirmam o despreparo.

O resultado do Sistema de Avaliação de Rendimento Escolar do Estado de São Paulo (Saresp), divulgado no mês passado, mostrou que 57% dos alunos terminam o ensino médio com rendimento insatisfatório em matemática. Os números do Programa Internacional de Avaliação de Alunos (Pisa), que avaliou o desempenho em matemática de jovens na faixa de 15 anos, colocaram o Brasil na 57.ª posição em um ranking de 65 países. No topo da lista estão China, Cingapura e Hong Kong.

Se a meta é fazer com que a produção de ciência e tecnologia acompanhe o crescimento econômico do Brasil, essa intolerância à matemática precisa ser combatida com urgência, dizem os especialistas. E a mudança precisa começar na sala aula. Mas não naquela que as crianças frequentam. A reforma deve ocorrer, primeiramente, nas classes das universidades que formam os futuros professores do País.

O desafio começa na formação dos docentes que dão aulas para o ensino fundamental. No Brasil, os professores do 1.º ao 5.º ano são polivalentes, isto é, responsáveis pelo conteúdo de todas as disciplinas e, por isso, não têm uma formação específica. Entre eles, poucos estudaram exatas. "Além de ter de dar conta de todas as matérias, muitos trazem a tradição brasileira de não gostar de matemática", diz Priscila Monteiro, consultora pedagógica para a área de matemática da Fundação Victor Civita.

Para esses, segundo a especialista, falta conhecimento. "Ele sabe ensinar, mas, como não domina o conteúdo, acaba preso às regras. Logo, a criança aprende de forma arbitrária, sem lógica." Priscila conta que, numa análise de cadernos de estudantes, constatou que, nas questões de matemática, sempre havia a resposta, nunca o processo de resolução. "Desse jeito, o aluno não constrói uma postura investigativa."

Problema oposto ocorre com os docentes do ciclo 2 do ensino fundamental, que dão aula para estudantes do 6.º ao 9.º ano. "Nesse caso, o professor de matemática é formado na área, tem conteúdo, mas lhe falta didática. Daí, ele se foca naqueles alunos que acompanham a aula e os outros continuam parados, aumenta o vale entre eles," diz Priscila.

Mudanças - Para tratar de propostas e materiais para o ensino de matemática, o Instituto Alfae Beto (IAB) promove, em agosto, um seminário internacional sobre o tema, voltado a professores e coordenadores pedagógicos. "Vamos discutir a forma de ensino: o material pedagógico que usamos é adequado? Qual o tempo de aula ideal? A fração tem que ser ensinada em forma de pizza? Decora ou não tabuada?", elenca João Batista Araujo e Oliveira, presidente do IAB.

Um dos palestrantes é Daniel Willingham, professor de Psicologia Cognitiva da Universidade de Virgínia. "Estou certo de que todos são aptos a aprender matemática. Mas também estou certo de que é uma disciplina mais abstrata e, por isso, mais difícil de ensinar do que as outras." Para outro convidado do evento, Hung-HsiWu, da Universidade da Califórnia, a dificuldade existe porque o aprendizado não é "natural". "Acriança aprende a falar sem esforço especial, mas matemática é uma arte difícil. Se não for ensinada por quem sabe, se torna assustadora. Mas, se for uma descoberta bem guiada, pode ser surpreendente."

Efeito cascata - Formar alunos com gosto pela matemática pode ajudar a resolver até mesmo a carência de professores da disciplina. Nos vestibulares da USP e da Unesp, por exemplo, a concorrência para licenciatura na área é de cerca de dois candidatos por vaga. No País há 59 mil professores formados em Matemática para 211 mil com formação em Letras. Somado a isso, muitos dos formados passam longe da escola. A baixa remuneração paga aos professores não atrai esses profissionais e muitos optam, por exemplo, pelo trabalho na rede bancária.

(O Estado de São Paulo)

Fonte:http://www.jornaldaciencia.org.br/Detalhe.jsp?id=77849

A aversão é tanta que o senso comum aponta: o brasileiro já nasce sem vocação para aprender matemática. O estudo na área começa com professores sem formação específica, que em geral não gostam da disciplina, e acaba com docentes que têm conteúdo para transmitir, mas não didática. No fim do ensino médio, exames confirmam o despreparo.

O resultado do Sistema de Avaliação de Rendimento Escolar do Estado de São Paulo (Saresp), divulgado no mês passado, mostrou que 57% dos alunos terminam o ensino médio com rendimento insatisfatório em matemática. Os números do Programa Internacional de Avaliação de Alunos (Pisa), que avaliou o desempenho em matemática de jovens na faixa de 15 anos, colocaram o Brasil na 57.ª posição em um ranking de 65 países. No topo da lista estão China, Cingapura e Hong Kong.

Se a meta é fazer com que a produção de ciência e tecnologia acompanhe o crescimento econômico do Brasil, essa intolerância à matemática precisa ser combatida com urgência, dizem os especialistas. E a mudança precisa começar na sala aula. Mas não naquela que as crianças frequentam. A reforma deve ocorrer, primeiramente, nas classes das universidades que formam os futuros professores do País.

O desafio começa na formação dos docentes que dão aulas para o ensino fundamental. No Brasil, os professores do 1.º ao 5.º ano são polivalentes, isto é, responsáveis pelo conteúdo de todas as disciplinas e, por isso, não têm uma formação específica. Entre eles, poucos estudaram exatas. "Além de ter de dar conta de todas as matérias, muitos trazem a tradição brasileira de não gostar de matemática", diz Priscila Monteiro, consultora pedagógica para a área de matemática da Fundação Victor Civita.

Para esses, segundo a especialista, falta conhecimento. "Ele sabe ensinar, mas, como não domina o conteúdo, acaba preso às regras. Logo, a criança aprende de forma arbitrária, sem lógica." Priscila conta que, numa análise de cadernos de estudantes, constatou que, nas questões de matemática, sempre havia a resposta, nunca o processo de resolução. "Desse jeito, o aluno não constrói uma postura investigativa."

Problema oposto ocorre com os docentes do ciclo 2 do ensino fundamental, que dão aula para estudantes do 6.º ao 9.º ano. "Nesse caso, o professor de matemática é formado na área, tem conteúdo, mas lhe falta didática. Daí, ele se foca naqueles alunos que acompanham a aula e os outros continuam parados, aumenta o vale entre eles," diz Priscila.

Mudanças - Para tratar de propostas e materiais para o ensino de matemática, o Instituto Alfae Beto (IAB) promove, em agosto, um seminário internacional sobre o tema, voltado a professores e coordenadores pedagógicos. "Vamos discutir a forma de ensino: o material pedagógico que usamos é adequado? Qual o tempo de aula ideal? A fração tem que ser ensinada em forma de pizza? Decora ou não tabuada?", elenca João Batista Araujo e Oliveira, presidente do IAB.

Um dos palestrantes é Daniel Willingham, professor de Psicologia Cognitiva da Universidade de Virgínia. "Estou certo de que todos são aptos a aprender matemática. Mas também estou certo de que é uma disciplina mais abstrata e, por isso, mais difícil de ensinar do que as outras." Para outro convidado do evento, Hung-HsiWu, da Universidade da Califórnia, a dificuldade existe porque o aprendizado não é "natural". "Acriança aprende a falar sem esforço especial, mas matemática é uma arte difícil. Se não for ensinada por quem sabe, se torna assustadora. Mas, se for uma descoberta bem guiada, pode ser surpreendente."

Efeito cascata - Formar alunos com gosto pela matemática pode ajudar a resolver até mesmo a carência de professores da disciplina. Nos vestibulares da USP e da Unesp, por exemplo, a concorrência para licenciatura na área é de cerca de dois candidatos por vaga. No País há 59 mil professores formados em Matemática para 211 mil com formação em Letras. Somado a isso, muitos dos formados passam longe da escola. A baixa remuneração paga aos professores não atrai esses profissionais e muitos optam, por exemplo, pelo trabalho na rede bancária.

(O Estado de São Paulo)

Fonte:http://www.jornaldaciencia.org.br/Detalhe.jsp?id=77849

Como investir para melhorar o aprendizado

Artigo de Viviane Senna no jornal Folha de S. Paulo desta segunda-feira (6).

É óbvio que o bom professor ensina mais e melhor, mas agora sabemos a magnitude dessa desigualdade, que prejudica os menos favorecidos.

A educação brasileira fez progressos importantes em termos de resultados alcançados e políticas implementadas. Segundo o Banco Mundial, somos o País que mais rapidamente aumentou a escolaridade média da população entre 1990 e 2010 (de 5,6 para 7,2 anos), tomando o recorde que era da China.

Somos também um dos países com o maior avanço no aprendizado dos alunos, medido pelo Pisa, no período de 2000 a 2009. Implementamos e institucionalizamos instrumentos e processos de avaliação de resultados. Mas, como todos sabemos, ainda há um longo percurso pela frente, com desafios fundamentais a nos exigir ações mais objetivas e precisas.

Acabamos de dar um passo importante: o movimento Todos pela Educação e o Instituto Ayrton Senna lançaram um mapeamento da produção científica mundial sobre os fatores que impactam a aprendizagem dos alunos.

O trabalho organiza de forma inédita os resultados de 165 estudos acadêmicos brasileiros e estrangeiros, selecionados por critérios técnicos rigorosos entre cerca de 600 inicialmente consultados.

Conduzido por Ricardo Paes de Barros e mais de 20 pesquisadores de renomadas universidades brasileiras, "Caminhos para Melhorar o Aprendizado" analisa políticas que possam contribuir para o alcance da Meta 3 do movimento, a de ter todo aluno com aprendizado adequado à sua série.

Indo além do senso comum e dos achismos, quebrando alguns mitos, o trabalho aponta, por exemplo, que os alunos dos melhores professores aprendem até 70% mais em cada ano.

É óbvio que o bom professor ensina mais e melhor, mas agora podemos saber a magnitude dessa desigualdade, que prejudica exatamente as crianças e os adolescentes menos favorecidos.

O trabalho quantifica o alto impacto e ressalta a importância de políticas que aumentam a exposição do estudante ao conhecimento: cumprimento do calendário escolar, aumento da jornada, reforço escolar, redução do absenteísmo de professores e alunos e redução do número de alunos por turma.

"Caminhos" tem o refinamento de indicar, por exemplo, que o impacto da redução do tamanho das turmas é maior nas séries iniciais do que nas finais, dando ao gestor a opção de focalizar melhor os investimentos. Se o gestor tem o desafio de recuperar alunos muito defasados, aumentando a proficiência para reduzir rapidamente as desigualdades educacionais, saberá que uma estratégia de baixo custo e alto impacto é a formação de turmas mais homogêneas.

Do ponto de vista cognitivo, essa política pode elevar em até 35% o aprendizado do aluno ao longo do ano, mas o gestor deve também levar em conta equilíbrio entre o aumento da proficiência e os objetivos sociais mais amplos da educação.

O trabalho aumenta a gama de informações à disposição do decisor e dá subsídios para nova geração de políticas públicas, baseadas em evidências, mais focalizadas e comprometidas com resultados. Também oferece base para a produção de novos e necessários estudos acadêmicos, que possam contribuir com a constante melhoria dessas políticas, conforme apontou James Heckman, Nobel de Economia, ao conhecer o trabalho.

Os aprendizados e as ressalvas necessárias para seu bom uso estão disponíveis no site www.paramelhoraroaprendizado.org.br, apresentados de modo prático para quem está envolvido na construção de uma educação pública em que os alunos possam efetivamente aprender.

Viviane Senna, 52, é presidente do Instituto Ayrton Senna e coordenadora da equipe técnica do movimento Todos pela Educação.

Fonte:http://www.jornaldaciencia.org.br/Detalhe.jsp?id=77847

É óbvio que o bom professor ensina mais e melhor, mas agora sabemos a magnitude dessa desigualdade, que prejudica os menos favorecidos.

A educação brasileira fez progressos importantes em termos de resultados alcançados e políticas implementadas. Segundo o Banco Mundial, somos o País que mais rapidamente aumentou a escolaridade média da população entre 1990 e 2010 (de 5,6 para 7,2 anos), tomando o recorde que era da China.

Somos também um dos países com o maior avanço no aprendizado dos alunos, medido pelo Pisa, no período de 2000 a 2009. Implementamos e institucionalizamos instrumentos e processos de avaliação de resultados. Mas, como todos sabemos, ainda há um longo percurso pela frente, com desafios fundamentais a nos exigir ações mais objetivas e precisas.

Acabamos de dar um passo importante: o movimento Todos pela Educação e o Instituto Ayrton Senna lançaram um mapeamento da produção científica mundial sobre os fatores que impactam a aprendizagem dos alunos.

O trabalho organiza de forma inédita os resultados de 165 estudos acadêmicos brasileiros e estrangeiros, selecionados por critérios técnicos rigorosos entre cerca de 600 inicialmente consultados.

Conduzido por Ricardo Paes de Barros e mais de 20 pesquisadores de renomadas universidades brasileiras, "Caminhos para Melhorar o Aprendizado" analisa políticas que possam contribuir para o alcance da Meta 3 do movimento, a de ter todo aluno com aprendizado adequado à sua série.

Indo além do senso comum e dos achismos, quebrando alguns mitos, o trabalho aponta, por exemplo, que os alunos dos melhores professores aprendem até 70% mais em cada ano.

É óbvio que o bom professor ensina mais e melhor, mas agora podemos saber a magnitude dessa desigualdade, que prejudica exatamente as crianças e os adolescentes menos favorecidos.

O trabalho quantifica o alto impacto e ressalta a importância de políticas que aumentam a exposição do estudante ao conhecimento: cumprimento do calendário escolar, aumento da jornada, reforço escolar, redução do absenteísmo de professores e alunos e redução do número de alunos por turma.

"Caminhos" tem o refinamento de indicar, por exemplo, que o impacto da redução do tamanho das turmas é maior nas séries iniciais do que nas finais, dando ao gestor a opção de focalizar melhor os investimentos. Se o gestor tem o desafio de recuperar alunos muito defasados, aumentando a proficiência para reduzir rapidamente as desigualdades educacionais, saberá que uma estratégia de baixo custo e alto impacto é a formação de turmas mais homogêneas.

Do ponto de vista cognitivo, essa política pode elevar em até 35% o aprendizado do aluno ao longo do ano, mas o gestor deve também levar em conta equilíbrio entre o aumento da proficiência e os objetivos sociais mais amplos da educação.

O trabalho aumenta a gama de informações à disposição do decisor e dá subsídios para nova geração de políticas públicas, baseadas em evidências, mais focalizadas e comprometidas com resultados. Também oferece base para a produção de novos e necessários estudos acadêmicos, que possam contribuir com a constante melhoria dessas políticas, conforme apontou James Heckman, Nobel de Economia, ao conhecer o trabalho.

Os aprendizados e as ressalvas necessárias para seu bom uso estão disponíveis no site www.paramelhoraroaprendizado.org.br, apresentados de modo prático para quem está envolvido na construção de uma educação pública em que os alunos possam efetivamente aprender.

Viviane Senna, 52, é presidente do Instituto Ayrton Senna e coordenadora da equipe técnica do movimento Todos pela Educação.

Fonte:http://www.jornaldaciencia.org.br/Detalhe.jsp?id=77847

Humanos vão ser animais de estimação dos robôs

Steve Wozniak, cofundador da Apple, acredita que a evolução da inteligência artificial vai acabar por transformar os humanos nos "cães da casa".

Considerando por muitos o inventor do computador pessoal, Steve Wozniak foi também um dos fundadores da Apple. Num discurso destinado a empresários australianos, Wozniak referiu que "já estamos a criar seres superiores, penso que já perdemos a batalha contra as máquinas há muito tempo".

De acordo com a notícia do News.com.au , Woz é da opinião que os humanos vão ser cada vez menos necessários no futuro e que vão acabar por ter uma vida muito facilitada, onde tudo é feito por máquinas, chegando a dizer "vamos ser os animais de estimação, os cães da casa".

Fonte:http://aeiou.exameinformatica.pt/humanos-vao-ser-animais-de-estimacao-dos-robos=f1009719

Steve Wozniak, cofundador da Apple, acredita que a evolução da inteligência artificial vai acabar por transformar os humanos nos "cães da casa".

Considerando por muitos o inventor do computador pessoal, Steve Wozniak foi também um dos fundadores da Apple. Num discurso destinado a empresários australianos, Wozniak referiu que "já estamos a criar seres superiores, penso que já perdemos a batalha contra as máquinas há muito tempo".

De acordo com a notícia do News.com.au , Woz é da opinião que os humanos vão ser cada vez menos necessários no futuro e que vão acabar por ter uma vida muito facilitada, onde tudo é feito por máquinas, chegando a dizer "vamos ser os animais de estimação, os cães da casa".

Fonte:http://aeiou.exameinformatica.pt/humanos-vao-ser-animais-de-estimacao-dos-robos=f1009719

segunda-feira, 6 de junho de 2011

''A Internet vai salvar os livros''

Robert Darnton, professor de Harvard, explica o seu projeto, alternativo ao do Google: uma biblioteca universal, aberta a todos, a ser implementada na Internet. "Nos EUA, os textos autoproduzidos são três vezes mais numerosos do que os publicados por editoras comerciais". "Alguns estão convencidos de que democratizar o conhecimento significa vulgarizá-lo. No século XIX, temia-se a mesma coisa".

A reportagem é de Benedetta Craveri, publicada no jornal La Repubblica, 27-05-2011. A tradução é de Moisés Sbardelotto.

Duas vocações se cruzam e se iluminam reciprocamente no 11 ensaios que Robert Darnton reuniu agora em Il futuro del libro [O futuro do livro] (Ed. Adelphi, 273 páginas). A primeira é a do historiador que, através de um trabalho extraordinário de escavação nos arquivos do passado, trouxe novamente à luz um século XVIII underground destinado a contribuir de modo incisivo para o final do Antigo Regime.

A segunda é a do intelectual comprometido que olha para o futuro interrogando-se sobre os problemas relativos à transmissão do saber de amanhã. De outro lado, a sua própria posição de diretor da biblioteca de Harvard confronta Darnton cotidianamente com a necessidade de conservar e ao mesmo tempo de inovar. Por fim, há um terceiro fator que contribui para tornar Il futuro del libro uma leitura apaixonando, que é a arte de narrar do seu autor.

Eis a entrevista.

Professor Darnton, o senhor escreve que digitalizar é democratizar. Mas que uso poderá fazer dessa imensa oferta de "leitura democrática" uma sociedade de massa que lê cada vez menos, que antepõe a imagem ao texto e é, em grande parte, desprovida de instrumentos interpretativos necessários?

O termo "democratização" pode parecer alarmante se aplicado à cultura, sobretudo na cultura americana tal como é vista pela Europa. Em seu livro, escrito em polêmica com o Google – Quand Google défie l'Europe – Jean-Noël Jeanneney usa o argumento dos algoritmos e do sistema de avaliação baseado na frequência dos acessos para denunciar um "populismo cultural", como se a digitalização em massa dos livros ameaçasse afogar a Europa em uma cultura de massa alienante. Os europeus podem permanecer aficionados – como eu sou – ao venerável código impresso, mas os norte-americanos leem livros eletrônicos com uma avidez igual, senão maior – como demonstram os últimos dados da Amazon –, à que leem os livros impressos.

Qual é o panorama que surge disso?

Em 2011, pelo menos 20% do total das vendas será de livro adaptados para dispositivos de leitura que estão em suas mãos. Parece que a própria prática da leitura está aumentando, especialmente no setor dos gêneros populares, tais como as histórias de romance ou os livros policiais. Isso quer dizer que democratizar significa vulgarizar? Talvez. Isso era o que muitos europeus da segunda metade do século XIX já lamentavam diante do sucesso de romances baratos e dos jornais. Eu compartilho a opinião de Richard Hoggart, de Marcel Certeau, de Carlo Ginzburg e de Roger Chartier, que defendem que os leitores plebeus tinham a capacidade de captar toda a riqueza dos significados dos textos "populares" adaptando-os à sua própria cultura.

O senhor também fala da "democratização da escrita". A que se refere?

Trata-se de um fenômeno muito interessante. Nos Estados Unidos, em 2009, foram publicados 288.355 livros por editoras comerciais. A estes, devem ser acrescentados os 764.448 novos títulos de autores que se autopublicam. Uma vez, os livros eram escritos para o leitor comum. Hoje, é o leitor comum que os escreve.

Até que ponto é possível comparar, como o senhor faz, a rede de informação sem fronteiras oferecida hoje pela Internet com a circulação das ideias na Paris do século XVIII? Os intelectuais do Iluminismo – Voltaire na frente – buscavam o objetivo de difundir o saber em benefício das elites e certamente não do povo.

Voltaire, sem dúvida, ficaria horrorizado diante da situação atual. Ele não se cansava de defender que era arriscado ensinar os camponeses a ler, porque era preciso que alguém cultivasse os campos. Os iluministas foram muito longe na sua exigência de refinamento. Mas, quando consideramos de modo global a idade do Iluminismo, vemos que muitas ideias circulavam de forma fragmentada, exatamente como na Internet. Basta pensar nas conversas trocadas em torno da chamada "árvore da Cracóvia" no Palais-Royal, nos bon-mots rabiscados em pedaços de papel, nos versos improvisados nas árias populares. Estou convencido de que temos que proceder a uma reconstrução completa "do ecossistema de informações" do passado. Ao fazer isso, poderemos ter uma visão mais clara do futuro. Longe de mim querer assumir o ditado de que "quanto mais as coisas mudam, mais continuam as mesmas", mas, em Il futuro del libro, procurei mostrar como as longas linhas de continuidade interconectam fases diferentes da história.

O senhor não se cansa de lembrar como a garantia da democracia, para a Internet, é incompatível com a política de monopólio do Google.

O problema da democratização foi posto pelo Google Book Search de um novo modo. À primeira vista, essa iniciativa tinha a vantagem de colocar milhões de livros à disposição de milhões de leitores. Mas havia um preço a pagar, o da assinatura do acesso ao gigantesco banco de dados do Google. Ao invés de democratização, encontramo-nos, portanto, diante de uma perspectiva de comercialização. O perigo se tornou evidente quando o Google assinou um acordo econômico com os escritores e os editores que o haviam processado por ter violado os direitos autorais. O público não estava autorizado a dizer a sua opinião, mas um tribunal de Nova York se recusou a aprovar o acordo.

Qual é a alternativa possível?

Um grupo de pessoas do qual eu faço parte está tentando criar uma Biblioteca Pública Digital dos Estados Unidos (Digital Public Library of America), que se propõe a competir e a vencer o Google em seu próprio campo, tornando acessível gratuitamente o patrimônio cultural norte-americano não só a todos os norte-americanos, mas ao mundo inteiro. Ao invés de depender do Estado no plano financeiro, visamos a uma coalizão de fundações privadas. Um consórcio de bibliotecas disponibilizará os livros e os outros materiais. São muitos ainda os problemas técnicos, jurídicos e administrativos, mas esperamos apresentar um primeiro modelo até o fim deste ano.

E as suas previsões sobre o futuro?

Vivemos um momento extraordinário da história das comunicações. Tudo é fluido e em contínua mudança. Se soubermos aproveitar o momento, podemos determinar o nosso futuro, para o bem público. Devemos digitalizar – digitalizar e democratizar.

FONTE:http://www.ihu.unisinos.br/index.php?option=com_noticias&Itemid=18&task=detalhe&id=43745

Proposta para a educação

Fernando Reinach - O Estado de S.Paulo

Você lembra o número do telefone de seu dentista? Onde estão suas músicas preferidas? E a história de seu país? Essas informações estão fora de seu corpo, talvez no seu telefone celular, nos CDs e nos livros que enchem as estantes.

Estamos tão acostumados a guardar, buscar e utilizar informações armazenadas em instrumentos de memória extracorpórea que é quase impossível imaginar como seria nossa existência sem essas tecnologias. Mas a realidade é que, durante a maior parte da existência do Homo sapiens, o único instrumento de que dispúnhamos para armazenar informação era nossa memória e a memória de nossos conhecidos.

O processo de acúmulo de informações surgiu quando nossos ancestrais começaram a se comunicar, talvez 1 milhão de anos atrás. Antes, a informação acumulada por uma pessoa desaparecia com sua morte.

O que para nós é difícil de compreender é que durante 995 mil desses últimos 1 milhão de anos toda a informação acumulada por nossa espécie estava armazenada exclusivamente em nossa própria memória. Não havia instrumentos de memória extracorpórea, a escrita não tinha sido inventada. Os desenhos e outras formas de arte, apesar de úteis, são incapazes de estocar muita informação. Faz menos de 5 mil anos que aprendemos a escrever e aos poucos pudemos retirar de nossa memória parte da responsabilidade de estocar a informação coletada pela humanidade. Surgiram os livros, depois os discos e os computadores.

É quase impossível imaginar como foi nossa relação com a memória cerebral durante centenas de milhares de anos. Imagine um mundo onde qualquer informação esquecida não pudesse ser recuperada. Foi neste ambiente que nosso cérebro evoluiu e foi moldado pelo processo de seleção natural. A educação de um indivíduo obrigatoriamente passava pela tarefa de memorizar as informações acumuladas por seus antepassados. As histórias, as músicas, os alimentos, como caçar e como tratar doenças. Cada indivíduo, antes de se considerar educado, deveria memorizar todas estas informações. Educar era antes de tudo lembrar.

Com o desenvolvimento da escrita, as tradições orais foram colocadas no papel e cuidadosamente replicadas. Mas só muito recentemente a prensa de Gutenberg se espalhou pela Europa e os livros puderam chegar a grande parte da população. Foi nesta época de transição, entre o uso exclusivo da memória e a introdução dos instrumentos de memória extracorpóreos, que surgiram as escolas. A disponibilidade da informação nesses instrumentos ainda era limitada e a educação tinha como objetivo "copiar" no cérebro de cada indivíduo grande parte da informação acumulada pela humanidade. Mas, enquanto esse sistema de ensino se espalhava e as crianças estavam memorizando acidentes geográficos, por exemplo, o aprimoramento dos mecanismos de memória extracorpórea permitiu que a quantidade de informação acumulada crescesse exponencialmente.

Nosso sistema de educação estava condenado ao fracasso antes de poder se espalhar. Hoje é impossível ensinar ou aprender tudo o que a humanidade sabe. Os anos de estudo se prolongam e a quantidade de informação a ser ensinada se multiplica. A especialização, grande esperança do século 20, inibe a criatividade, condena as pessoas a viverem em um microcosmo e acirra conflitos entre habitantes de cada microcosmo. São agricultores que não entendem o ecossistema, ecologistas que não entendem a evolução. E, pior, pessoas que não sabem aprender fora da escola.

Talvez seja a hora de pensar numa mudança radical no processo de educação. Ele não deve ter como objetivo copiar a informação para nosso cérebro. Da mesma maneira que deixamos de decorar o número do telefone do dentista, o objetivo da educação deveria ser capacitar as pessoas a explorar, capturar, selecionar, julgar e utilizar as informações acumuladas nos mecanismos de memória extracorpórea. Deveríamos também ensinar as pessoas a organizar, sistematizar e depositar informações nesses mecanismos extracorpóreos, tanto individualmente quanto coletivamente. As informações utilizadas durante o ensino seriam somente exemplos que permitiriam aos alunos aprender a navegar pelo mar de informações. Aos 21 anos deixaríamos para sempre o ambiente escolar, cada jovem diferente de todos os outros, mas todos capazes de estudar e aprender durante o resto da vida.

BIÓLOGO

MAIS INFORMAÇÕES: LIVRO "MOON WALKING WITH EINSTEIN. THE ART AND SCIENCE OF REMEMBERING EVERYTHING", DE JOSHUA FOER. THE PENGUIN PRESS, 2011 (FERNANDO@REINACH.COM)

FONTE:http://www.estadao.com.br/estadaodehoje/20110602/not_imp726921,0.php

Você lembra o número do telefone de seu dentista? Onde estão suas músicas preferidas? E a história de seu país? Essas informações estão fora de seu corpo, talvez no seu telefone celular, nos CDs e nos livros que enchem as estantes.

Estamos tão acostumados a guardar, buscar e utilizar informações armazenadas em instrumentos de memória extracorpórea que é quase impossível imaginar como seria nossa existência sem essas tecnologias. Mas a realidade é que, durante a maior parte da existência do Homo sapiens, o único instrumento de que dispúnhamos para armazenar informação era nossa memória e a memória de nossos conhecidos.

O processo de acúmulo de informações surgiu quando nossos ancestrais começaram a se comunicar, talvez 1 milhão de anos atrás. Antes, a informação acumulada por uma pessoa desaparecia com sua morte.

O que para nós é difícil de compreender é que durante 995 mil desses últimos 1 milhão de anos toda a informação acumulada por nossa espécie estava armazenada exclusivamente em nossa própria memória. Não havia instrumentos de memória extracorpórea, a escrita não tinha sido inventada. Os desenhos e outras formas de arte, apesar de úteis, são incapazes de estocar muita informação. Faz menos de 5 mil anos que aprendemos a escrever e aos poucos pudemos retirar de nossa memória parte da responsabilidade de estocar a informação coletada pela humanidade. Surgiram os livros, depois os discos e os computadores.

É quase impossível imaginar como foi nossa relação com a memória cerebral durante centenas de milhares de anos. Imagine um mundo onde qualquer informação esquecida não pudesse ser recuperada. Foi neste ambiente que nosso cérebro evoluiu e foi moldado pelo processo de seleção natural. A educação de um indivíduo obrigatoriamente passava pela tarefa de memorizar as informações acumuladas por seus antepassados. As histórias, as músicas, os alimentos, como caçar e como tratar doenças. Cada indivíduo, antes de se considerar educado, deveria memorizar todas estas informações. Educar era antes de tudo lembrar.

Com o desenvolvimento da escrita, as tradições orais foram colocadas no papel e cuidadosamente replicadas. Mas só muito recentemente a prensa de Gutenberg se espalhou pela Europa e os livros puderam chegar a grande parte da população. Foi nesta época de transição, entre o uso exclusivo da memória e a introdução dos instrumentos de memória extracorpóreos, que surgiram as escolas. A disponibilidade da informação nesses instrumentos ainda era limitada e a educação tinha como objetivo "copiar" no cérebro de cada indivíduo grande parte da informação acumulada pela humanidade. Mas, enquanto esse sistema de ensino se espalhava e as crianças estavam memorizando acidentes geográficos, por exemplo, o aprimoramento dos mecanismos de memória extracorpórea permitiu que a quantidade de informação acumulada crescesse exponencialmente.

Nosso sistema de educação estava condenado ao fracasso antes de poder se espalhar. Hoje é impossível ensinar ou aprender tudo o que a humanidade sabe. Os anos de estudo se prolongam e a quantidade de informação a ser ensinada se multiplica. A especialização, grande esperança do século 20, inibe a criatividade, condena as pessoas a viverem em um microcosmo e acirra conflitos entre habitantes de cada microcosmo. São agricultores que não entendem o ecossistema, ecologistas que não entendem a evolução. E, pior, pessoas que não sabem aprender fora da escola.

Talvez seja a hora de pensar numa mudança radical no processo de educação. Ele não deve ter como objetivo copiar a informação para nosso cérebro. Da mesma maneira que deixamos de decorar o número do telefone do dentista, o objetivo da educação deveria ser capacitar as pessoas a explorar, capturar, selecionar, julgar e utilizar as informações acumuladas nos mecanismos de memória extracorpórea. Deveríamos também ensinar as pessoas a organizar, sistematizar e depositar informações nesses mecanismos extracorpóreos, tanto individualmente quanto coletivamente. As informações utilizadas durante o ensino seriam somente exemplos que permitiriam aos alunos aprender a navegar pelo mar de informações. Aos 21 anos deixaríamos para sempre o ambiente escolar, cada jovem diferente de todos os outros, mas todos capazes de estudar e aprender durante o resto da vida.

BIÓLOGO

MAIS INFORMAÇÕES: LIVRO "MOON WALKING WITH EINSTEIN. THE ART AND SCIENCE OF REMEMBERING EVERYTHING", DE JOSHUA FOER. THE PENGUIN PRESS, 2011 (FERNANDO@REINACH.COM)

FONTE:http://www.estadao.com.br/estadaodehoje/20110602/not_imp726921,0.php

Mais de 4 mil livros de ciência de graça

National Academies Press, editora das academias nacionais de ciência dos EUA, publica todo o catálogo em pdf para ser baixado livremente

06/06/2011

Agência FAPESP – A National Academies Press (NAP), editora das academias nacionais de ciência dos Estados Unidos, anunciou no dia 2 de junho que passou a oferecer seu catálogo completo para ser baixado e lido de graça pela internet.

São mais de 4 mil títulos, que podem ser baixados inteiros ou por capítulos, em arquivos pdf. A NAP publica mais de 200 livros por ano nas mais diversas áreas do conhecimento, com destaque para publicações importantes em política científica e tecnológica.

Os livros podem ser copiados livremente a partir de qualquer computador conectado na internet e mostram o esforço da NAP em democratizar o acesso ao conteúdo produzido pelas academias norte-americanas. As academias, que atuam há mais de 100 anos, são: National Academy of Sciences, National Academy of Engineering, Institute of Medicine e National Research Council.

Os títulos em capa dura continuarão à venda no site da NAP. A opção de ler de graça parte de livros ou títulos inteiros começou a ser oferecida pelo site em 1994. A oferta de todo o catálogo de graça para ser baixado em pdf foi feita primeiro para os países em desenvolvimento.

Entre os títulos que podem ser baixados estão: On Being a Scientist: A Guide to Responsible Conduct in Research, Guide for the Care and Use of Laboratory Animals e Prudent Practices in the Laboratory: Handling and Management of Chemical Hazards.

Mais informações: www.nap.edu

Fonte:http://agencia.fapesp.br/13987

Assinar:

Postagens (Atom)