Informação, conhecimento e poder

mudança tecnológica e inovação social

Maria Lucia Maciel e Sarita Albagli (org)

Editora Garamond

As transformações vividas pela sociedade contemporânea, em seus múltiplos aspectos, são o tema do livro. Como é de se esperar, a informação adquire um papel central nessas revoluções abordadas. Quais as novas relações entre informação, conhecimento e poder? Quais as novas institucionalidades, novas práticas e dinâmicas sociais e que inovações trazem nesse cenário? Que arcabouços teórico-conceituais estão sendo gestados para melhor compreender esse novo quadro? Essas são algumas questões que norteiam a elaboração dessa publicação que compila 12 artigos de diversos autores nacionais e estrangeiros.

Atores em rede olhares luso-brasileiros

Brasilina Passarelli e José Azevedo (organizadores)

Editora Senac São Paulo

“São artigos que buscam mapear, de forma teórica e prática, o conceito de comunicação na sociedade contemporânea. Eles discutem metodologias para a análise de comunidades virtuais, o conceito de arte perante o cibernético, a digitalização do fluxo digital e a reestruturação hierárquica dos produtos do saber”. Assim os autores definem sua obra que estabelece elementos comparativos de países que possuem semelhanças históricas e diferenças consideráveis refletidas nos textos de especialistas portugueses e brasileiros.

A Força sem Força do Melhor Argumento: ensaio sobre “novas epistemologias virtuais"

Pedro Demo

Instituto Brasileiro de Informaçao em Ciência e Tecnologia

O autor pretende, a partir da análise do fenômeno Wikipedia – inclusive elucidando seus problemas e carências – sedimentar o desafio de usar a internet como referência de pesquisa e elaboração própria, reduzindo a atração pelo plágio. Na apresentação da obra, o diretor do IBICT, Emir Suaiden, ressalta: “Um texto só consegue se manter, caso permaneça sempre editável, ou seja, submetido à discussão aberta entre pares, que promovem como critério mais decisivo a autoridade do argumento”. Nesse contexto, o uso dos textos da ferramenta Wikipedia compõem um universo rico para a análise das novas epistemologias digitais.

Fonte:http://www.ibict.br/noticia.php?id=767

Translate

quinta-feira, 12 de maio de 2011

terça-feira, 10 de maio de 2011

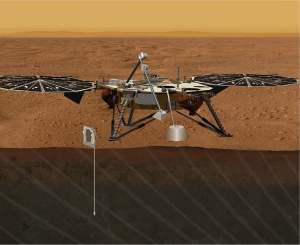

NASA oferece US$ 200 milhões por soluções viáveis de abastecimento no espaço

Sistema poderia proporcionar a criação de naves mais leves e menores, barateando o custo dos lançamentos

A NASA está oferecendo US$ 200 milhões para um projeto que mostre uma maneira eficiente de enviar e armazenar tanques de combustível no espaço para o abastecimento de espaçonaves durante as missões. A estação ficaria na zona de "baixa órbita" da Terra, onde as naves poderiam estacionar e reabastecer seu combustível para missões mais compridas.

A tecnologia possibilitaria a exploração mais profunda do espaço, com destinos como a Lua, Marte ou outros asteróides do sistema solar. Com o abastecimento no espaço, as naves poderiam ficar menores e mais leves, o que baratearia o custo total de lançamento de novas missões.

"Ao invés de enviar os foguetes completamente abastecidos, faríamos lançamentos com apenas uma parte do combustível para ganharmos mais carga em órbita", afirmou Chris Moore, Diretor de Capacidades Avançadas da NASA.

A NASA deve focar seus estudos no uso de oxigênio líquido e hidrogênio líquido, ambos combustíveis utilizados em naves espaciais e foguetes comerciais. O maior desafio é o armazenamento dos combustíveis, que exige temperaturas extremamente baixas. Erupções solares, por exemplo, poderiam fazer o conteúdo evaporar ou até explodir as cápsulas de armazenamento.

Outra vantagem do sistema é criar um ambiente mais dinâmico para a indústria espacial. Através do abastecimento em órbita, companhias poderiam expandir a oferta de lançamentos comerciais e criar até plataformas permanentes no espaço.

fonte:http://olhardigital.uol.com.br/produtos/digital_news/noticias/nasa_oferece_us_200_milhao_por_uma_estacao_de_abastecimento_no_espaco

Soluções para Educação: sistemas de vigilância e anti-vandalismo

Veja como inibir o vandalismo, proteger o perímetro escolar e reduzir custos com segurança

10 de Maio de 2011 | 17:15h

Você sabe como manter-se atualizado em tecnologia?

Participe do Quint@s Quinze, o primeiro webcast semanal de tecnologia pela internet. Saiba das principais novidades e tendências do mercado com os especialistas da Cisco & convidados.

A cada semana, um novo tema relevante sobre soluções e aplicações em negócios.

Nesta semana, abordaremos o tema "Soluções Cisco para Educação - Sistemas de vigilância, acesso, anti-vandalismo e perímetro escolar" com Ricardo Santos.

A solução Cisco para a Escola Segura é composta pela integração de tecnologias Cisco de videomonitoração, comunicações unificadas, colaboração e infraestrutura de rede IP. Seu principal benefício para as instituições de ensino, é o de inibir o vandalismo, proteger o perímetro escolar e reduzir custos com segurança. Isto é possível graças à integração dos dispositivos e procedimentos de segurança sobre a rede IP da escola, de forma a maximizar a capacidade de identificação, monitoramento e dar respostas rápidas a incidentes.

Eis algumas das questões que serão tratadas no evento do dia 12:

- Como implantar um sistema local e remoto de vigilância e controle de incidentes no campus e no perímetro escolar sem uma equipe de guardas 24x7?

- Como inibir vandalismo? Drogas? Roubo de ativos da escola? Como reduzir a sensação de um ambiente inseguro para aprendizado?

- Como resolver a falta de vídeo nos controles de acesso de portas e entradas?

- Como atender mais rapidamente incidentes com pequenas equipes de segurança disponíveis?

- Como integrar o sistema de segurança com a rede de computadores da escola, sem causar impacto de performance nas aplicações?

- Como evitar redução do número de matrículas em função da percepção de insegurança?

Ricardo Santos é Mestre em Administração de Empresas pela Universidade de DUKE (EUA) e Pós Graduado em Gestão Avançada pelo INSEAD (França). Professor Universitário de Cursos de Pós Graduação de Escolas de Negócios há 15 anos e Executivo de Marketing, Canais e Vendas na Indústria de TI e Telecom há 23 anos, tanto no Brasil como América Latina. Atua na Cisco desde de 2000 e atualmente é responsável pelo desenvolvimento da Vertical de Educação no Brasil e mercados emergentes. Por 1 hora você assistirá uma apresentação colaborativa via WebEx.

Áudio, vídeo e imagens compartilhadas em um espaço Web 2.0, além de chat para perguntas e respostas.

Participe: toda Quinta às Quinze horas!

FONTE:http://olhardigital.uol.com.br/negocios/digital_news/noticias/solucoes_para_educacao_sistemas_de_vigilancia_e_anti-vandalismo

10 de Maio de 2011 | 17:15h

Você sabe como manter-se atualizado em tecnologia?

Participe do Quint@s Quinze, o primeiro webcast semanal de tecnologia pela internet. Saiba das principais novidades e tendências do mercado com os especialistas da Cisco & convidados.

A cada semana, um novo tema relevante sobre soluções e aplicações em negócios.

Nesta semana, abordaremos o tema "Soluções Cisco para Educação - Sistemas de vigilância, acesso, anti-vandalismo e perímetro escolar" com Ricardo Santos.

A solução Cisco para a Escola Segura é composta pela integração de tecnologias Cisco de videomonitoração, comunicações unificadas, colaboração e infraestrutura de rede IP. Seu principal benefício para as instituições de ensino, é o de inibir o vandalismo, proteger o perímetro escolar e reduzir custos com segurança. Isto é possível graças à integração dos dispositivos e procedimentos de segurança sobre a rede IP da escola, de forma a maximizar a capacidade de identificação, monitoramento e dar respostas rápidas a incidentes.

Eis algumas das questões que serão tratadas no evento do dia 12:

- Como implantar um sistema local e remoto de vigilância e controle de incidentes no campus e no perímetro escolar sem uma equipe de guardas 24x7?

- Como inibir vandalismo? Drogas? Roubo de ativos da escola? Como reduzir a sensação de um ambiente inseguro para aprendizado?

- Como resolver a falta de vídeo nos controles de acesso de portas e entradas?

- Como atender mais rapidamente incidentes com pequenas equipes de segurança disponíveis?

- Como integrar o sistema de segurança com a rede de computadores da escola, sem causar impacto de performance nas aplicações?

- Como evitar redução do número de matrículas em função da percepção de insegurança?

Ricardo Santos é Mestre em Administração de Empresas pela Universidade de DUKE (EUA) e Pós Graduado em Gestão Avançada pelo INSEAD (França). Professor Universitário de Cursos de Pós Graduação de Escolas de Negócios há 15 anos e Executivo de Marketing, Canais e Vendas na Indústria de TI e Telecom há 23 anos, tanto no Brasil como América Latina. Atua na Cisco desde de 2000 e atualmente é responsável pelo desenvolvimento da Vertical de Educação no Brasil e mercados emergentes. Por 1 hora você assistirá uma apresentação colaborativa via WebEx.

Áudio, vídeo e imagens compartilhadas em um espaço Web 2.0, além de chat para perguntas e respostas.

Participe: toda Quinta às Quinze horas!

FONTE:http://olhardigital.uol.com.br/negocios/digital_news/noticias/solucoes_para_educacao_sistemas_de_vigilancia_e_anti-vandalismo

Mais de 80% das vagas de emprego não são divulgadas. Veja como encontrá-las

Especialista dá três dicas para quem quer acessar essas oportunidades de trabalho, por meio de pesquisas, rede de contatos e autopromoção

1

Hoje, existem diversas maneiras de um profissional consultar as vagas de trabalho abertas em sua área. As mais comuns delas são consultar os sites específicos que divulgam esse tipo de informação ou fazer uma busca na própria página das empresas na internet.

No entanto, na visão de Steven Rothberg, fundador do site de empregos norte-americano CollegeRecruiter.com, esse nem sempre representa o caminho mais adequado para procurar um emprego. Isso porque, em artigo no jornal norte-americano The Wall Street Journal, ele afirma que mais de 80% das vagas de trabalho abertas atualmente não são divulgadas de forma oficial.

Mas qual é o caminho, então, para encontrar uma vaga de trabalho? Investir em pesquisas, usar melhor a rede de contatos e divulgar competências.

A seguir, veja as dicas de Rothberg para atrair potenciais empregos que não são formalmente divulgados:

Enxergue os sinais: Esteja atualizado com o que acontece em seu setor, aconselha o especialista. Para isso, é importante ler jornais especializados, consultar os comentários de analistas e monitorar a performance das empresas – para entender se elas estão crescendo, passando por uma reestruturação ou terceirizando mão de obra. Qualquer notícia pode representar um sinal de que a companhia está aberta, ou não, a contratações.

“Crie uma lista de empresas nas quais você gostaria de trabalhar e faça pesquisas do perfil dos principais cargos dessa organização. Você pode descobrir a descrição da carreira [dos executivos dessa companhia] nos sites e blogs”, aconselha Rothberg. Ele acrescenta que as pessoas só devem se candidatar a uma vaga se preencherem os conhecimentos e a experiência necessários para ocupá-la.

Aproveite melhor os contatos: “Acione sua rede de contatos de colegas, amigos e familiares para descobrir possíveis conexões que possam fazer com que seu currículo chegue até quem toma a decisão [de contratação na companhia em que quer trabalhar]”, pontua o especialista. Ele aponta que, caso não exista um contato direto, busque algum tipo de indicação, por meio dos “amigos de amigos”.

Outra alternativa é tentar participar de atividades – como eventos e feiras – que envolvam profissionais do setor e que possam ajudá-lo a acessar possíveis empregadores.

Seja facilmente ‘encontrável’: Melhore sua visibilidade para possíveis empresas que possam contratá-lo, ao divulgar seu currículo em sites como o LinkedIn. Não esqueça de enfatizar suas habilidades, permitindo assim que as empresas que buscam conhecimentos específicos o encontrem.

Fonte:http://olhardigital.uol.com.br/negocios/digital_news/noticias/mais_de_80_das_vagas_de_emprego_nao_sao_divulgadas_veja_como_encontra-las

Brasil pode chegar a 2050 com 80% de energia renovável

Brasil tem grande capacidade de produção eólica

Potencial brasileiro ultrapassa previsão mais otimista do Painel de Mudanças Climáticas, de que 77% de toda a energia do mundo pode vir de fontes renováveis, até 2050. Para chegar lá, país tem que acertar política.

Ainda sob o choque da crise nuclear de Fukushima, o mundo precisa de um empurrão para continuar a virada energética rumo às fontes renováveis. O novo estudo publicado pelo Painel Intergovernamental de Mudanças Climáticas (IPCC) visa servir de estímulo para os tomadores de decisão.

O Relatório Especial sobre Fontes de Energias Renováveis e Mitigação das Mudanças Climáticas (SRREN, na sigla em inglês) é categórico: até 2050, 77% de toda a energia produzida no mundo poderia vir de fontes renováveis "se houver apoio correto de políticas públicas".

Segundo os pesquisadores, esse panorama reduziria em 33% as emissões de gases de efeito estufa e ajudaria a manter a elevação da temperatura global abaixo de 2ºC. Dessa maneira, seriam aliviados os efeitos catastróficos do aquecimento global previstos pelos cientistas.

Decisões certas

Para o relatório, consideraram-se 160 cenários possíveis para a participação das fontes renováveis até 2050, e quatro deles foram analisados com maior profundidade. No mais otimista, a geração de energia limpa saltaria dos atuais 12,9% para 77%, até metade do século.

"O Brasil pode chegar em 2050 com 80% de sua energia a partir de fontes renováveis. Hoje temos aproximadamente 45% ou 46%", afirmou Carlos Nobre, secretário de Políticas e Programas de Pesquisa e Desenvolvimento do Ministério de Ciência e Tecnologia, em conversa com a Deutsche Welle.

Para chegar lá, no entanto, é preciso pavimentar bem o caminho. "Sim, estamos num momento de importantes definições de políticas públicas. Finalmente criou-se uma base, quase que um consenso, de que o Brasil tem que acompanhar o desenvolvimento mundial na incorporação de novas tecnologias de energias renováveis, principalmente eólica, solar e de biomassa", acrescentou Nobre.

No mix nacional de geração de energia, as hidrelétricas aparecem em primeiro lugar, com 66,28%. Mas a fonte eólica é promissora: "O potencial brasileiro é, talvez, o segundo maior do mundo, depois dos Estados Unidos", comentou o secretário. Essa fonte de energia cresceu 30% em todo o mundo, em 2009, diz o relatório do IPCC, perdendo apenas para a expansão da energia fotovoltaica, que foi de 50%. Os autores acreditam que em 2050 a energia solar será uma das principais fontes de geração limpa.

Fábio Scarano, autor do IPCC e diretor executivo da ONG Conservação Internacional no Brasil, lembra que há armadilhas no caminho. "O investimento que o Brasil está fazendo na polêmica usina de Belo Monte, por exemplo, poderia ir para a pesquisa de energia renovável. É preciso muito mais pesquisa nessa área, e nós estamos bem atrasados."

Euforia do petróleo brasileiro

Com o aumento da exploração petrolífera no Brasil e toda a expectativa de ganhos que se criou com a descoberta do Pré-Sal, o Brasil foi desafiado a demonstrar quão comprometido está com a sustentabilidade, e se existe risco de o país deixar de lado o investimento em energia limpa.

"O risco existe. O Brasil não pode cair no erro histórico em que a Venezuela caiu. Ela poderia ter utilizado com sabedoria sua enorme riqueza petrolífera, poderia ter sido, talvez, o primeiro país desenvolvido da América do Sul", pontua Carlos Nobre.

A maneira como o governo brasileiro irá empregar essa fonte de bonança temporária mostrará se o Brasil tem condições de fazer parte do time definitivo de economias desenvolvidas e sustentáveis. "O país tem que usar essa riqueza – que hoje vale até muito mais do que no tempo em que a Venezuela começou a extrair – para dar um salto na educação, na capacidade de inovar, principalmente no setor de energia", ponderou Nobre, que também assina o relatório do IPCC.

Jogo de interesses

Mais de 120 pesquisadores do mundo todo, dentre eles 24 brasileiros, assinam o estudo. Antes de ser publicado, nesta segunda-feira (09/05), o conteúdo precisou da aprovação dos 194 países-membros das Nações Unidas.

"O Brasil se mostrou bastante engajado no tema e, como outros países, defendeu assuntos de seu interesse", disse à Deutsche Welle o porta-voz do IPCC, Nick Nuttal, depois de o Brasil ter sido acusado de atrasar a votação do relatório.

Segundo Nuttal, a representação brasileira quis esclarecer alguns pontos referentes ao uso de biocombustível. Isso porque, como atestado num relatório das Nações Unidas de 2010, nem toda produção de combustível a partir de fonte renovável é uma arma contra as mudanças climáticas. No caso brasileiro, o modelo adotado com base na cana-de-açúcar é considerado, de fato, uma fonte limpa.

Autora: Nádia Pontes

Revisão: Augusto Valente

Fonte:http://www.dw-world.de/dw/article/0,,15065365,00.html?maca=bra-newsletter_br_Destaques-2362-html-nl

G8 e outros 14 países discutem plano de combate ao tráfico de cocaína

Nicolas Sarkozy propôs criação de fundo com dinheiro dos traficantes

Ministros e autoridades do G8 e de 14 outros países da América Latina, Caribe e África – inclusive o Brasil – se encontram em Paris para discutir formas de combater o tráfico internacional de drogas.

Um encontro de dois dias reúne em Paris integrantes do G8 (grupo de sete países industrializados e Rússia) e nações envolvidas na produção, comercialização e consumo da cocaína. Em seu discurso na noite de segunda-feira (09/05), no Palácio do Eliseu, o presidente francês, Nicolas Sarkozy propôs que se crie um fundo dedicado a combater o tráfico de cocaína com o dinheiro apreendido dos próprios criminosos.

"Combater os traficantes não é somente apreender ou confiscar a droga, é abordar a causa primeira do tráfico: o dinheiro", disse Sarkozy.

O fundo seria controlado pelo Escritório das Nações Unidas sobre Drogas e Crime (UNODC). O diretor-executivo do órgão, Yuri Fedotov, declarou que "se pudéssemos dispor de uma porcentagem dessas quantias gigantescas [geradas pelo tráfico de cocaína], isso ajudaria enormemente na luta internacional contra as drogas".

Reunião do G8

Reunião ministerial é preparatória para cúpula do G8

A França preside o G8 neste semestre. Em sua página de internet, a presidência francesa do grupo informara antes do encontro ministerial em Paris que "a luta contra a desestabilização de Estados afetados pelo tráfico transatlântico de cocaína será uma das prioridades da presidência francesa do G8, no tocante à segurança".

A reunião em Paris é preparatória para a cúpula dos chefes de Estado e governo do G8, que acontecerá nos dias 26 e 27 de maio próximos na cidade francesa de Deauville. O Brasil e o México contam entre os participantes.

Além dos países-membros do G8 – Estados Unidos, Canadá, Japão, Reino Unido, Alemanha, Itália, França e Rússia – foram convidadas para a reunião ministerial em Paris nações produtoras de cocaína como Colômbia, Peru e Bolívia, e países de trânsito da droga, como Brasil, Senegal e Marrocos.

Participaram ainda do encontro em Paris representantes da Holanda, Espanha, África do Sul, Argélia, Gana, Nigéria, República Dominicana e México, assim como da Comissão Europeia, Interpol, Europol, Banco Mundial e Banco Interamericano de Desenvolvimento (BID).

Europa pode ultrapassar EUA

Yuri Fedotov, diretor-executivo da UNODC

O encontro promovido pela França teve como meta convocar para uma guerra contra a droga os países produtores de cocaína na América Latina, como também os Estados de trânsito e consumo.

Nesta terça-feira, os ministros dos 22 países deram prosseguimento às discussões sobre o ambicioso plano de combate ao tráfico internacional de cocaína. O plano, que será apresentado no encontro do G8 em Deauville, deverá abranger a produção, tráfico e demanda da cocaína.

Nos últimos anos, o consumo da droga caiu bastante nos Estados Unidos, enquanto, na Europa, ele disparou. O UNODC advertiu que, em breve, o velho continente poderá ultrapassar os EUA. Segundo Fedotov, o número de consumidores europeus dobrou de 2 milhões em 1998 para 4,1 milhões em 2008. O faturamento anual com a droga no continente europeu se elevou para 33 bilhões de dólares, apenas 4 bilhões de dólares a menos que os EUA.

Pacto político

O diretor-executivo da UNODC sublinhou em Paris que dois terços dos usuários de cocaína na Europa vivem somente em três países – Reino Unido, Espanha e Itália. Contudo também cresce o consumo na África Ocidental e na América do Sul, advertiu. Isto levou à criação de "novas rotas" da cocaína, que agora se pretende cortar.

Grande parte do tráfico é operada a partir da América do Sul, em navios porta-contêineres. Os traficantes utilizam tecnologias cada vez mais sofisticadas, como submarinos e aviões a jato.

Yuri Fedotov estima que o tráfico global da cocaína movimente 320 bilhões de dólares por ano. Na reunião em Paris, ele ressaltou uma "violência sem precedentes" causada pelo narcotráfico na América Central, em particular em El Salvador, Honduras e Guatemala.

"A resposta a essa situação crítica passa antes de tudo por um pacto político renovado entre os Estados dos dois lados do Oceano Atlântico", concluiu o diretor.

CA/dpa/rtr/afp

Revisão: Augusto Valente

Fonte:http://www.dw-world.de/dw/article/0,,15064760,00.html?maca=bra-newsletter_br_Destaques-2362-html-nl

O tempo é real ou é uma ilusão?

Kate Becker - FQXi - 09/05/2011

Einstein descartou o relógio-mestre de Newton quando demonstrou que não há dois eventos verdadeiramente simultâneos a menos que entre eles haja uma relação de causalidade. [Imagem: FQXi]

A realidade do tempo

Muitos físicos argumentam que o tempo é uma ilusão. Lee Smolin prefere discordar.

E se o tempo for mesmo algo real?

Se você não é um físico teórico, a pergunta colocada por Smolin pode soar como uma grande bobagem, como se alguém lhe perguntasse: "E se os seus sapatos e meias fossem reais?"

Afinal, você os usa todos os dias, assim, como não poderiam ser reais?

Dentro do mundo da física fundamental, porém, a noção de que o tempo possa ser real é praticamente radical.

A sensação do tempo

Sim, como seres humanos, vivenciamos o tempo como uma coisa que flui; nós marcamos uma linha divisória entre o passado imutável e o futuro ainda a ser escrito; e nós acreditamos que vivemos em um momento especial que chamamos de presente, que está sendo constantemente atualizado.

Ainda de acordo com a sabedoria convencional - ou, pelo menos, de acordo com aquele tipo peculiar de sabedoria pouco convencional que governa a física quântica e a cosmologia - o tempo é uma ilusão que emerge de uma física mais profunda.

Nesse ponto de vista, o tempo é uma representação ficcional para o comportamento em larga escala de algo mais fundamental.

"É comum na filosofia e na ciência presumir que as coisas que são mais profundas e mais verdadeiras sobre o mundo estão fora do tempo," resume Smolin, físico teórico do Instituto Perimeter em, Ontário, no Canadá. "A questão fundamental é, o tempo é real ou é uma ilusão? Nós experimentamos a vida como uma sequência de momentos, mas é assim que o mundo realmente é?"

"Não há dúvida de que o tempo existe, nós o usamos todos os dias," acrescenta Sean Carroll, físico do Instituto de Tecnologia da Califórnia. "Mas não temos certeza se o tempo é realmente fundamental, se é uma parte necessária de uma compreensão profunda da física, ou se é apenas uma aproximação útil."

A realidade do tempo

Smolin prefere continuar defendendo a realidade do tempo.

Mas, para isso, ele deve superar um grande obstáculo: as teorias da relatividade especial e geral parecem implicar o oposto.

Na visão clássica de Newton, a física funciona obedecendo ao tique-taque de um relógio universal invisível.

Mas Einstein descartou esse relógio-mestre quando, em sua teoria da relatividade especial, ele argumentou que não há dois eventos verdadeiramente simultâneos a menos que entre eles haja uma relação de causalidade.

Se a simultaneidade - a noção do "agora" - é relativa, o relógio universal deve ser uma ficção, e o próprio tempo é uma aproximação para o movimento e a mudança dos objetos no universo. O tempo está literalmente descartado da equação.

Embora tenha passado grande parte de sua carreira explorando as facetas de um Universo atemporal, Smolin se convenceu de que isto está "profundamente errado", diz ele. Ele agora acredita que o tempo é mais do que apenas uma aproximação útil, que ele é tão real quanto a fome que sentimos nos diz que é, mais real, na verdade, do que o próprio espaço.

Física quântica e relatividade geral

A noção de um "tempo real e global" é a hipótese de partida para os novos trabalhos de Smolin, que ele vai realizar este ano com a ajuda de dois estudantes de pós-graduação, financiado pelo Instituto FQXi, uma entidade sem fins lucrativos cuja proposta é discutir as questões fundamentais da física e do Universo.

Smolin espera que este estudo possa permitir-lhe superar um dos maiores problemas não resolvidos da física e da cosmologia - unir as leis da física quântica com as leis da relatividade geral.

A física quântica funciona maravilhosamente bem quando aplicada aos átomos e suas partes constituintes; a relatividade geral é uma descrição testada e comprovada do espaço-tempo na escala macro dos planetas, estrelas e galáxias.

Quando estes dois conjuntos de leis se encontram, porém, como devem fazer para descrever o que acontece dentro de um buraco negro ou como o universo era na época do Big Bang, surge o conflito e o desentendimento.

Poderia o tempo ser a linha que irá costurá-las em uma peça única?

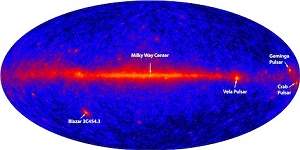

O Telescópio de Raios Gama Fermi revela emissões brilhantes no céu: poderiam essas emissões revelar a verdade sobre o tempo? [Imagem: NASA/DOE/Intl. LAT Team]

Relógio cósmico

Smolin espera que o levar o tempo a sério vai ajudar a desvendar o que aconteceu no cosmo primordial.

Até agora, é difícil distinguir as leis da natureza atuais das condições iniciais do universo - Em comparação, é fácil distinguir entre dois experimentos no laboratório porque estes testes podem ser repetidos com diferentes condições de partida. Os cosmólogos, entretanto, não podem reinicializar o universo.

Se ele puder lidar com as leis da física com a ajuda de um relógio cósmico fundamental, Smolin pode examinar a possibilidade de que essas leis possam ter sido diferentes no passado. A ideia de que as leis da física podem evoluir com o tempo só faz sentido num quadro em que o tempo é fundamental, afirma ele.

Para entender o porquê, imagine um jogo de futebol no qual as regras são programadas para mudar a cada minuto. Se o próprio relógio não for fundamental, mas também for governado por essas regras flutuantes, os pobres jogadores e árbitros estariam presos em um loop lógico infinito.

As idéias de Smolin podem ser pouco convencionais, mas outros cientistas admiram suas tentativas para salvar o tempo.

"Não fazer isso é negar os dados mais fundamentais que coletamos na vida diária - que estão na base da nossa capacidade de realizar experimentos e analisar teorias," diz George Ellis, um matemático da Universidade da Cidade do Cabo, na África do Sul.

Entretanto, Carlo Rovelli, um físico da Universidade de Marselha, na França, é de opinião contrária: "Nós não devemos forçar as teorias à nossa intuição: nós mudamos a intuição para entender as teorias."

Além da filosofia

Smolin tem consciência de que suas teorias devem ser mais do que filosoficamente agradáveis para que possam ser consideradas científicas.

Ele observa que os astrônomos já estão usando telescópios de raios gama e observatórios de raios cósmicos para investigar se as leis da relatividade especial ainda se mantêm sob energias extremas. Esses experimentos produziram resultados que restringem algumas teorias quânticas da gravidade.

"Embora eles não resolvam a questão de saber se o tempo é real," diz Smolin, "esses experimentos limitam as opções para teorizações sobre a natureza do tempo."

Leis da Física podem variar ao longo do Universo

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=tempo-realidade-ou-ilusao&id=010130110509&ebol=sim

Einstein descartou o relógio-mestre de Newton quando demonstrou que não há dois eventos verdadeiramente simultâneos a menos que entre eles haja uma relação de causalidade. [Imagem: FQXi]

A realidade do tempo

Muitos físicos argumentam que o tempo é uma ilusão. Lee Smolin prefere discordar.

E se o tempo for mesmo algo real?

Se você não é um físico teórico, a pergunta colocada por Smolin pode soar como uma grande bobagem, como se alguém lhe perguntasse: "E se os seus sapatos e meias fossem reais?"

Afinal, você os usa todos os dias, assim, como não poderiam ser reais?

Dentro do mundo da física fundamental, porém, a noção de que o tempo possa ser real é praticamente radical.

A sensação do tempo

Sim, como seres humanos, vivenciamos o tempo como uma coisa que flui; nós marcamos uma linha divisória entre o passado imutável e o futuro ainda a ser escrito; e nós acreditamos que vivemos em um momento especial que chamamos de presente, que está sendo constantemente atualizado.

Ainda de acordo com a sabedoria convencional - ou, pelo menos, de acordo com aquele tipo peculiar de sabedoria pouco convencional que governa a física quântica e a cosmologia - o tempo é uma ilusão que emerge de uma física mais profunda.

Nesse ponto de vista, o tempo é uma representação ficcional para o comportamento em larga escala de algo mais fundamental.

"É comum na filosofia e na ciência presumir que as coisas que são mais profundas e mais verdadeiras sobre o mundo estão fora do tempo," resume Smolin, físico teórico do Instituto Perimeter em, Ontário, no Canadá. "A questão fundamental é, o tempo é real ou é uma ilusão? Nós experimentamos a vida como uma sequência de momentos, mas é assim que o mundo realmente é?"

"Não há dúvida de que o tempo existe, nós o usamos todos os dias," acrescenta Sean Carroll, físico do Instituto de Tecnologia da Califórnia. "Mas não temos certeza se o tempo é realmente fundamental, se é uma parte necessária de uma compreensão profunda da física, ou se é apenas uma aproximação útil."

A realidade do tempo

Smolin prefere continuar defendendo a realidade do tempo.

Mas, para isso, ele deve superar um grande obstáculo: as teorias da relatividade especial e geral parecem implicar o oposto.

Na visão clássica de Newton, a física funciona obedecendo ao tique-taque de um relógio universal invisível.

Mas Einstein descartou esse relógio-mestre quando, em sua teoria da relatividade especial, ele argumentou que não há dois eventos verdadeiramente simultâneos a menos que entre eles haja uma relação de causalidade.

Se a simultaneidade - a noção do "agora" - é relativa, o relógio universal deve ser uma ficção, e o próprio tempo é uma aproximação para o movimento e a mudança dos objetos no universo. O tempo está literalmente descartado da equação.

Embora tenha passado grande parte de sua carreira explorando as facetas de um Universo atemporal, Smolin se convenceu de que isto está "profundamente errado", diz ele. Ele agora acredita que o tempo é mais do que apenas uma aproximação útil, que ele é tão real quanto a fome que sentimos nos diz que é, mais real, na verdade, do que o próprio espaço.

Física quântica e relatividade geral

A noção de um "tempo real e global" é a hipótese de partida para os novos trabalhos de Smolin, que ele vai realizar este ano com a ajuda de dois estudantes de pós-graduação, financiado pelo Instituto FQXi, uma entidade sem fins lucrativos cuja proposta é discutir as questões fundamentais da física e do Universo.

Smolin espera que este estudo possa permitir-lhe superar um dos maiores problemas não resolvidos da física e da cosmologia - unir as leis da física quântica com as leis da relatividade geral.

A física quântica funciona maravilhosamente bem quando aplicada aos átomos e suas partes constituintes; a relatividade geral é uma descrição testada e comprovada do espaço-tempo na escala macro dos planetas, estrelas e galáxias.

Quando estes dois conjuntos de leis se encontram, porém, como devem fazer para descrever o que acontece dentro de um buraco negro ou como o universo era na época do Big Bang, surge o conflito e o desentendimento.

Poderia o tempo ser a linha que irá costurá-las em uma peça única?

O Telescópio de Raios Gama Fermi revela emissões brilhantes no céu: poderiam essas emissões revelar a verdade sobre o tempo? [Imagem: NASA/DOE/Intl. LAT Team]

Relógio cósmico

Smolin espera que o levar o tempo a sério vai ajudar a desvendar o que aconteceu no cosmo primordial.

Até agora, é difícil distinguir as leis da natureza atuais das condições iniciais do universo - Em comparação, é fácil distinguir entre dois experimentos no laboratório porque estes testes podem ser repetidos com diferentes condições de partida. Os cosmólogos, entretanto, não podem reinicializar o universo.

Se ele puder lidar com as leis da física com a ajuda de um relógio cósmico fundamental, Smolin pode examinar a possibilidade de que essas leis possam ter sido diferentes no passado. A ideia de que as leis da física podem evoluir com o tempo só faz sentido num quadro em que o tempo é fundamental, afirma ele.

Para entender o porquê, imagine um jogo de futebol no qual as regras são programadas para mudar a cada minuto. Se o próprio relógio não for fundamental, mas também for governado por essas regras flutuantes, os pobres jogadores e árbitros estariam presos em um loop lógico infinito.

As idéias de Smolin podem ser pouco convencionais, mas outros cientistas admiram suas tentativas para salvar o tempo.

"Não fazer isso é negar os dados mais fundamentais que coletamos na vida diária - que estão na base da nossa capacidade de realizar experimentos e analisar teorias," diz George Ellis, um matemático da Universidade da Cidade do Cabo, na África do Sul.

Entretanto, Carlo Rovelli, um físico da Universidade de Marselha, na França, é de opinião contrária: "Nós não devemos forçar as teorias à nossa intuição: nós mudamos a intuição para entender as teorias."

Além da filosofia

Smolin tem consciência de que suas teorias devem ser mais do que filosoficamente agradáveis para que possam ser consideradas científicas.

Ele observa que os astrônomos já estão usando telescópios de raios gama e observatórios de raios cósmicos para investigar se as leis da relatividade especial ainda se mantêm sob energias extremas. Esses experimentos produziram resultados que restringem algumas teorias quânticas da gravidade.

"Embora eles não resolvam a questão de saber se o tempo é real," diz Smolin, "esses experimentos limitam as opções para teorizações sobre a natureza do tempo."

Leis da Física podem variar ao longo do Universo

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=tempo-realidade-ou-ilusao&id=010130110509&ebol=sim

Bomba de calor pode durar 10.000 anos

Redação do Site Inovação Tecnológica - 09/05/2011

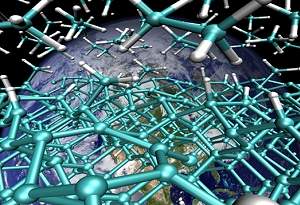

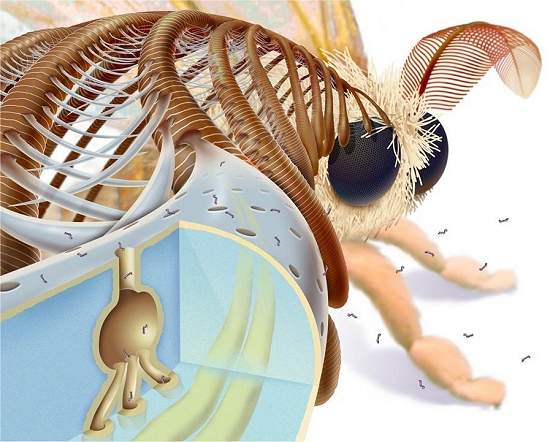

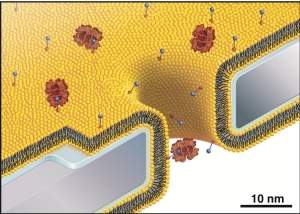

As minúsculas bombas de calor (em cima) podem ser montadas em dispositivos de virtualmente qualquer formato e tamanho, como o que o pesquisador segura nas mãos. [Imagem: Elisabeth Tønnessen]

Bombas de calor, ou bombas térmicas, são mecanismos que transferem temperatura por meio de um ciclo termodinâmico, sendo utilizadas principalmente para aquecimento.

Uma bomba de calor tradicional, como todos os equipamentos, tem uma vida útil - entre cinco e dez anos, eventualmente um pouco mais.

Agora, pesquisadores noruegueses desenvolveram uma bomba de calor que, segundo eles, pode durar virtualmente "para sempre" - eles calculam uma vida útil de 10.000 anos.

Microbomba eterna

O segredo dessa "imortalidade" está na miniaturização e na eliminação de partes móveis.

A nova bomba de calor consiste de inúmeras bombas de calor em miniatura, cada uma medindo não mais do que um milímetro cúbico.

Para aquecer uma casa será necessário usar vários milhares delas. Mas isto não é problema, porque sua estrutura permite que elas sejam fabricadas exatamente assim, aos milhares.

E, mais do que isso, a estrutura inteira pode ter qualquer formato, ajustando-se à aplicação.

"As principais vantagens da nova bomba de calor é que você pode regular o seu tamanho e sua forma, ela é mais durável do que as bombas de calor são hoje e também é mais ambientalmente amigável," afirmam Jan Bording e Vidar Hansen, da Universidade de Stavanger.

Ligas termoelétricas

Para eliminar as partes móveis, Bording e Hansen usaram ligas termoelétricas, eliminando compressores, tubulações e, sobretudo, gases de refrigeração, geralmente não muito amigáveis ambientalmente.

Em seu lugar, a eletricidade é convertida diretamente em diferencial de temperatura, podendo ser utilizado, por exemplo, para aquecer residências.

"Nós não queremos mais um grande aquecedor queimando madeira no meio da casa, como nos velhos tempos. Será muito melhor usar fontes de calor menores e limpas," diz Hansen.

Ele exemplifica afirmando que as microbombas de calor podem ser montadas em planos e colocadas sob o piso - assim o calor fluirá do piso ao teto, aquecendo a casa por inteiro e de forma mais homogênea.

"Quando a bomba de calor tem uma superfície maior, ela produz mais calor," afirma o engenheiro.

E, à parte algum acidente que destrua o material, a bomba de calor poderá ser encontrada pelos arqueólogos do futuro.

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=bomba-calor-durar-10-000-anos&id=010170110509&ebol=sim

As minúsculas bombas de calor (em cima) podem ser montadas em dispositivos de virtualmente qualquer formato e tamanho, como o que o pesquisador segura nas mãos. [Imagem: Elisabeth Tønnessen]

Bombas de calor, ou bombas térmicas, são mecanismos que transferem temperatura por meio de um ciclo termodinâmico, sendo utilizadas principalmente para aquecimento.

Uma bomba de calor tradicional, como todos os equipamentos, tem uma vida útil - entre cinco e dez anos, eventualmente um pouco mais.

Agora, pesquisadores noruegueses desenvolveram uma bomba de calor que, segundo eles, pode durar virtualmente "para sempre" - eles calculam uma vida útil de 10.000 anos.

Microbomba eterna

O segredo dessa "imortalidade" está na miniaturização e na eliminação de partes móveis.

A nova bomba de calor consiste de inúmeras bombas de calor em miniatura, cada uma medindo não mais do que um milímetro cúbico.

Para aquecer uma casa será necessário usar vários milhares delas. Mas isto não é problema, porque sua estrutura permite que elas sejam fabricadas exatamente assim, aos milhares.

E, mais do que isso, a estrutura inteira pode ter qualquer formato, ajustando-se à aplicação.

"As principais vantagens da nova bomba de calor é que você pode regular o seu tamanho e sua forma, ela é mais durável do que as bombas de calor são hoje e também é mais ambientalmente amigável," afirmam Jan Bording e Vidar Hansen, da Universidade de Stavanger.

Ligas termoelétricas

Para eliminar as partes móveis, Bording e Hansen usaram ligas termoelétricas, eliminando compressores, tubulações e, sobretudo, gases de refrigeração, geralmente não muito amigáveis ambientalmente.

Em seu lugar, a eletricidade é convertida diretamente em diferencial de temperatura, podendo ser utilizado, por exemplo, para aquecer residências.

"Nós não queremos mais um grande aquecedor queimando madeira no meio da casa, como nos velhos tempos. Será muito melhor usar fontes de calor menores e limpas," diz Hansen.

Ele exemplifica afirmando que as microbombas de calor podem ser montadas em planos e colocadas sob o piso - assim o calor fluirá do piso ao teto, aquecendo a casa por inteiro e de forma mais homogênea.

"Quando a bomba de calor tem uma superfície maior, ela produz mais calor," afirma o engenheiro.

E, à parte algum acidente que destrua o material, a bomba de calor poderá ser encontrada pelos arqueólogos do futuro.

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=bomba-calor-durar-10-000-anos&id=010170110509&ebol=sim

Simulação reforça teoria abiogênica do petróleo

Redação do Site Inovação Tecnológica - 10/05/2011

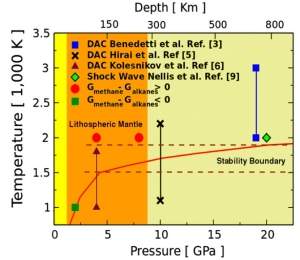

Determinar as propriedades termoquímicas das moléculas de hidrocarbonos é importante para entender a formação dos reservatórios de petróleo e gás natural e o fluxo de carbono na Terra.[Imagem: Eric Schwegler/LLNL]

Petróleo abiogênico

A teoria que tenta explicar a gênese do petróleo, do carvão e do gás natural é tão aceita que esses derivados do carbono se tornaram sinônimos de "combustíveis fósseis."

Os combustíveis são reais, e estão na base da economia do mundo moderno. Mas o termo "fóssil" vem da teoria.

Uma teoria que propõe que organismos vivos morreram, foram soterrados, comprimidos e aquecidos sob pesadas camadas de sedimentos na crosta terrestre, onde sofreram transformações químicas, até originar o petróleo e seus primos.

Há tempo, geólogos vêm contestando essa teoria e propondo uma origem abiótica para o petróleo, ou seja, uma teoria que propõe que o petróleo não é fóssil.

Petróleo e gás natural podem não ser fósseis

Agora, esses defensores da teoria abiótica ganharam mais um argumento.

Hidrocarbonos de origem geológica

Giulia Galli e seus colegas da Universidade da Califórnia, nos Estados Unidos, demonstraram que as longas cadeias de hidrocarbonos podem se formar no interior da Terra a partir do hidrocarbono mais simples possível - a molécula de metano.

As moléculas de hidrocarbono são o bloco fundamental que forma o petróleo e o gás natural.

Giulia defende que os hidrocarbonos abiogênicos, de origem puramente geológica, podem se formar nas condições adequadas de temperatura e pressão encontradas no manto superior da Terra.

"Nossas simulações mostram que as moléculas de metano podem se combinar para formar moléculas de grandes hidrocarbonos quando expostas às pressões e temperaturas muito altas do manto superior da Terra," diz ela.

Diversos estudos práticos, usando bigornas de diamante e explosivos, têm proposto condições de temperatura e pressão nas quais o petróleo pode se formar sem a participação de fósseis. [Imagem: Spanu et al./Pnas]

Onde nascem os hidrocarbonos complexos

Os pesquisadores usaram técnicas sofisticadas, baseadas em primeiros princípios - as propriedades fundamentais dos átomos de carbono e hidrogênio - para simular o comportamento desses átomos sob as pressões e temperaturas encontradas entre 65 e 150 quilômetros de profundidade.

O estudo mostrou que hidrocarbonos com múltiplos átomos de carbono podem se formar a partir do metano, uma molécula com apenas um átomo de carbono e quatro átomos de hidrogênio.

Isso pode ocorrer em temperaturas maiores do que 1.500 K e pressões a partir de 50.000 vezes a pressão atmosférica - essas condições são encontradas a partir de 110 quilômetros de profundidade.

"Na simulação, interações com superfícies de carbono e metal permitiram que o processo ocorra com maior velocidade; elas funcionam como catalisadores," afirma Leonardo Spanu, coautor do estudo.

Teorias

O estudo não conclui que o petróleo e o gás natural se formam nesse ponto, uma vez que as condições reais dessas regiões não estão acessíveis à observação direta e, portanto, não são totalmente conhecidas.

O estudo demonstra que as condições do manto superior são adequadas para que as moléculas de metano formem hidrocarbonos longos.

Outro detalhe a ser analisado pelos defensores da teoria do petróleo abiótico seria explicar o mecanismo que faz com que esses hidrocarbonos migrem para mais perto da superfície, onde são encontrados os depósitos de petróleo e gás natural.

Por outro lado, dados coletados em poços de petróleo exauridos na Arábia Saudita são condizentes com uma hipótese de que esses poços estão novamente se enchendo de baixo para cima.

A pesquisa foi financiada pela Shell.

Bibliografia:

Stability of hydrocarbons at deep Earth pressures and temperatures

Leonardo Spanu, Davide Donadio, Detlef Hohl, Eric Schwegler, Giulia Galli

Proceedings of the National Academy of Sciences

April 26, 2011

Vol.: 108 (17) 6843-6846

DOI: 10.1073/pnas.1014804108

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=teoria-abiogenica-petroleo&id=010125110510&ebol=sim

Determinar as propriedades termoquímicas das moléculas de hidrocarbonos é importante para entender a formação dos reservatórios de petróleo e gás natural e o fluxo de carbono na Terra.[Imagem: Eric Schwegler/LLNL]

Petróleo abiogênico

A teoria que tenta explicar a gênese do petróleo, do carvão e do gás natural é tão aceita que esses derivados do carbono se tornaram sinônimos de "combustíveis fósseis."

Os combustíveis são reais, e estão na base da economia do mundo moderno. Mas o termo "fóssil" vem da teoria.

Uma teoria que propõe que organismos vivos morreram, foram soterrados, comprimidos e aquecidos sob pesadas camadas de sedimentos na crosta terrestre, onde sofreram transformações químicas, até originar o petróleo e seus primos.

Há tempo, geólogos vêm contestando essa teoria e propondo uma origem abiótica para o petróleo, ou seja, uma teoria que propõe que o petróleo não é fóssil.

Petróleo e gás natural podem não ser fósseis

Agora, esses defensores da teoria abiótica ganharam mais um argumento.

Hidrocarbonos de origem geológica

Giulia Galli e seus colegas da Universidade da Califórnia, nos Estados Unidos, demonstraram que as longas cadeias de hidrocarbonos podem se formar no interior da Terra a partir do hidrocarbono mais simples possível - a molécula de metano.

As moléculas de hidrocarbono são o bloco fundamental que forma o petróleo e o gás natural.

Giulia defende que os hidrocarbonos abiogênicos, de origem puramente geológica, podem se formar nas condições adequadas de temperatura e pressão encontradas no manto superior da Terra.

"Nossas simulações mostram que as moléculas de metano podem se combinar para formar moléculas de grandes hidrocarbonos quando expostas às pressões e temperaturas muito altas do manto superior da Terra," diz ela.

Diversos estudos práticos, usando bigornas de diamante e explosivos, têm proposto condições de temperatura e pressão nas quais o petróleo pode se formar sem a participação de fósseis. [Imagem: Spanu et al./Pnas]

Onde nascem os hidrocarbonos complexos

Os pesquisadores usaram técnicas sofisticadas, baseadas em primeiros princípios - as propriedades fundamentais dos átomos de carbono e hidrogênio - para simular o comportamento desses átomos sob as pressões e temperaturas encontradas entre 65 e 150 quilômetros de profundidade.

O estudo mostrou que hidrocarbonos com múltiplos átomos de carbono podem se formar a partir do metano, uma molécula com apenas um átomo de carbono e quatro átomos de hidrogênio.

Isso pode ocorrer em temperaturas maiores do que 1.500 K e pressões a partir de 50.000 vezes a pressão atmosférica - essas condições são encontradas a partir de 110 quilômetros de profundidade.

"Na simulação, interações com superfícies de carbono e metal permitiram que o processo ocorra com maior velocidade; elas funcionam como catalisadores," afirma Leonardo Spanu, coautor do estudo.

Teorias

O estudo não conclui que o petróleo e o gás natural se formam nesse ponto, uma vez que as condições reais dessas regiões não estão acessíveis à observação direta e, portanto, não são totalmente conhecidas.

O estudo demonstra que as condições do manto superior são adequadas para que as moléculas de metano formem hidrocarbonos longos.

Outro detalhe a ser analisado pelos defensores da teoria do petróleo abiótico seria explicar o mecanismo que faz com que esses hidrocarbonos migrem para mais perto da superfície, onde são encontrados os depósitos de petróleo e gás natural.

Por outro lado, dados coletados em poços de petróleo exauridos na Arábia Saudita são condizentes com uma hipótese de que esses poços estão novamente se enchendo de baixo para cima.

A pesquisa foi financiada pela Shell.

Bibliografia:

Stability of hydrocarbons at deep Earth pressures and temperatures

Leonardo Spanu, Davide Donadio, Detlef Hohl, Eric Schwegler, Giulia Galli

Proceedings of the National Academy of Sciences

April 26, 2011

Vol.: 108 (17) 6843-6846

DOI: 10.1073/pnas.1014804108

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=teoria-abiogenica-petroleo&id=010125110510&ebol=sim

MIT cria nova tecnologia 3-D sem óculos

Larry Hardesty, MIT - 10/05/2011

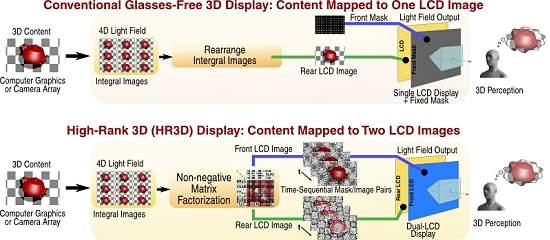

Em vez de exibir faixas verticais, como o 3DS faz, a tela de cima do HR3D exibe um padrão personalizado da imagem abaixo dela. [Imagem: MIT Media Lab]

O videogame Nintendo 3DS portátil, o primeiro aparelho comercial com uma tela 3-D que dispensa óculos, está disponível nos Estados Unidos há pouco mais de um mês, e já vendeu mais de um milhão de unidades.

A vida útil da sua bateria, porém, de três horas, é menos da metade daquela do seu antecessor, o DS 2-D.

De olho nesse gargalo, pesquisadores do MIT, nos Estados Unidos, desenvolveram uma abordagem fundamentalmente nova de telas 3-D sem óculos, chamada HR3D, que afirmam poder dobrar a vida útil da bateria de um aparelho como o 3DS, sem comprometer o brilho da tela ou a resolução.

Entre outras vantagens, a técnica também amplia o ângulo de visão de uma tela 3-D, tornando-a prática para dispositivos maiores, com vários usuários, e mantém o efeito 3-D mesmo quando a tela é girada - algo que acontece rotineiramente com os aparelhos portáteis.

3D do Nintendo 3DS

De acordo com Doug Lanman, um dos responsáveis pela criação do HR3D, o 3DS usa uma tecnologia centenária, conhecida como uma barreira de paralaxe.

Como a maioria das tecnologias 3-D, esta requer duas versões da mesma imagem, uma para o olho esquerdo e outra para o olho direito. As duas imagens são cortadas em segmentos verticais e intercaladas em uma única superfície.

Sozinha, a imagem composta parece um amontoado incoerente. Mas se você a projeta em uma tela com "fendas" verticais - a barreira de paralaxe -, exatamente à frente da imagem, e fica a uma distância adequada, a imagem 3-D "salta aos seus olhos".

As seções opacas da tela escondem do olho direito as partes da imagem destinadas ao olho esquerdo e vice-versa, mas os cortes permitem que cada olho veja os segmentos destinados a ele.

A tela do 3DS é composta por duas telas de cristal líquido (LCD), ligeiramente separadas. Quando o videogame está operando em modo 3-D, a tela frontal serve como barreira de paralaxe, projetando uma série de listras verticais opacas.

Como as listras bloqueiam metade da luz vinda da tela, o backlight do aparelho tem de ser duas vezes mais brilhante - o que drena a bateria duas vezes mais rapidamente.

Além disso, como o espaçamento das listras é calibrado para a separação horizontal dos olhos humanos, se a tela for inclinada, a ilusão 3-D desaparece.

Paralaxe total

Os pesquisadores do MIT decidiram repensar a tecnologia 3-D sem óculos a partir do zero.

No mundo real, conforme um observador se move em torno de um objeto, sua perspectiva desse objeto muda constantemente.

Uma experiência visual 3-D convincente pode exigir que uma tela ofereça uma dúzia de diferentes perspectivas, conforme o espectador se mexe para a direita ou para a esquerda.

Mas com o 3-D da barreira de paralaxe, cada nova perspectiva restringe ainda mais a emissão de luz.

A adição de múltiplas perspectivas na direção vertical, bem como na horizontal, exigiria uma barreira com paralaxe horizontal, assim como faixas verticais.

Para uma exposição com pontos de vista suficientes, a barreira paralaxe acabaria parecendo uma folha opaca com minúsculos furos.

Se um aparelho como o 3DS utilizasse a tecnologia HR3D, a carga da bateria poderia durar muito mais porque a barreira paralaxe bloqueia menos luz. [Imagem: MIT Media Lab]

3D de todos os ângulos

Como no 3DS, o novo sistema HR3D utiliza duas camadas de telas de cristal líquido.

Mas, em vez de exibir faixas verticais, como o 3DS faz, ou orifícios, como em um sistema de barreira paralaxe de múltiplas perspectivas, a tela de cima do HR3D exibe um padrão personalizado da imagem abaixo dela.

Em vez de poucas fendas verticais grandes, a barreira paralaxe é formada por milhares de pequenas fendas, cujas orientações seguem os contornos dos objetos na imagem. Assim, o padrão ideal acaba se parecendo um pouco como a imagem original

Como as fendas são orientadas em inúmeras direções diferentes, a ilusão de 3-D é consistente não importando se a imagem está sendo mostrada de pé ou rotacionada em 90 graus.

A adição de mais perspectivas altera o padrão das fendas, mas permite que a mesma quantidade de luz passe.

Se um aparelho como o 3DS utilizasse a tecnologia HR3D, a carga da bateria poderia durar muito mais porque a barreira paralaxe bloqueia menos luz.

"Mas a verdadeira vitória," diz Lanman, "vem com o movimento de paralaxe total" - isto é, uma tela que mostra múltiplas perspectivas em ambas as direções, horizontal e vertical.

Poder de processamento

Mas ainda há empecilhos para que a HR3D chegue ao mercado, mesmo em dispositivos não-portáteis: ela é altamente intensiva em computação.

Por isso, os pesquisadores planejam agora debruçar-se sobre o algoritmo que efetua os cálculos da barreira de paralaxe para torná-lo menos computacionalmente intensivo.

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=mit-tecnologia-3-d-sem-oculos&id=010110110510&ebol=sim

Em vez de exibir faixas verticais, como o 3DS faz, a tela de cima do HR3D exibe um padrão personalizado da imagem abaixo dela. [Imagem: MIT Media Lab]

O videogame Nintendo 3DS portátil, o primeiro aparelho comercial com uma tela 3-D que dispensa óculos, está disponível nos Estados Unidos há pouco mais de um mês, e já vendeu mais de um milhão de unidades.

A vida útil da sua bateria, porém, de três horas, é menos da metade daquela do seu antecessor, o DS 2-D.

De olho nesse gargalo, pesquisadores do MIT, nos Estados Unidos, desenvolveram uma abordagem fundamentalmente nova de telas 3-D sem óculos, chamada HR3D, que afirmam poder dobrar a vida útil da bateria de um aparelho como o 3DS, sem comprometer o brilho da tela ou a resolução.

Entre outras vantagens, a técnica também amplia o ângulo de visão de uma tela 3-D, tornando-a prática para dispositivos maiores, com vários usuários, e mantém o efeito 3-D mesmo quando a tela é girada - algo que acontece rotineiramente com os aparelhos portáteis.

3D do Nintendo 3DS

De acordo com Doug Lanman, um dos responsáveis pela criação do HR3D, o 3DS usa uma tecnologia centenária, conhecida como uma barreira de paralaxe.

Como a maioria das tecnologias 3-D, esta requer duas versões da mesma imagem, uma para o olho esquerdo e outra para o olho direito. As duas imagens são cortadas em segmentos verticais e intercaladas em uma única superfície.

Sozinha, a imagem composta parece um amontoado incoerente. Mas se você a projeta em uma tela com "fendas" verticais - a barreira de paralaxe -, exatamente à frente da imagem, e fica a uma distância adequada, a imagem 3-D "salta aos seus olhos".

As seções opacas da tela escondem do olho direito as partes da imagem destinadas ao olho esquerdo e vice-versa, mas os cortes permitem que cada olho veja os segmentos destinados a ele.

A tela do 3DS é composta por duas telas de cristal líquido (LCD), ligeiramente separadas. Quando o videogame está operando em modo 3-D, a tela frontal serve como barreira de paralaxe, projetando uma série de listras verticais opacas.

Como as listras bloqueiam metade da luz vinda da tela, o backlight do aparelho tem de ser duas vezes mais brilhante - o que drena a bateria duas vezes mais rapidamente.

Além disso, como o espaçamento das listras é calibrado para a separação horizontal dos olhos humanos, se a tela for inclinada, a ilusão 3-D desaparece.

Paralaxe total

Os pesquisadores do MIT decidiram repensar a tecnologia 3-D sem óculos a partir do zero.

No mundo real, conforme um observador se move em torno de um objeto, sua perspectiva desse objeto muda constantemente.

Uma experiência visual 3-D convincente pode exigir que uma tela ofereça uma dúzia de diferentes perspectivas, conforme o espectador se mexe para a direita ou para a esquerda.

Mas com o 3-D da barreira de paralaxe, cada nova perspectiva restringe ainda mais a emissão de luz.

A adição de múltiplas perspectivas na direção vertical, bem como na horizontal, exigiria uma barreira com paralaxe horizontal, assim como faixas verticais.

Para uma exposição com pontos de vista suficientes, a barreira paralaxe acabaria parecendo uma folha opaca com minúsculos furos.

Se um aparelho como o 3DS utilizasse a tecnologia HR3D, a carga da bateria poderia durar muito mais porque a barreira paralaxe bloqueia menos luz. [Imagem: MIT Media Lab]

3D de todos os ângulos

Como no 3DS, o novo sistema HR3D utiliza duas camadas de telas de cristal líquido.

Mas, em vez de exibir faixas verticais, como o 3DS faz, ou orifícios, como em um sistema de barreira paralaxe de múltiplas perspectivas, a tela de cima do HR3D exibe um padrão personalizado da imagem abaixo dela.

Em vez de poucas fendas verticais grandes, a barreira paralaxe é formada por milhares de pequenas fendas, cujas orientações seguem os contornos dos objetos na imagem. Assim, o padrão ideal acaba se parecendo um pouco como a imagem original

Como as fendas são orientadas em inúmeras direções diferentes, a ilusão de 3-D é consistente não importando se a imagem está sendo mostrada de pé ou rotacionada em 90 graus.

A adição de mais perspectivas altera o padrão das fendas, mas permite que a mesma quantidade de luz passe.

Se um aparelho como o 3DS utilizasse a tecnologia HR3D, a carga da bateria poderia durar muito mais porque a barreira paralaxe bloqueia menos luz.

"Mas a verdadeira vitória," diz Lanman, "vem com o movimento de paralaxe total" - isto é, uma tela que mostra múltiplas perspectivas em ambas as direções, horizontal e vertical.

Poder de processamento

Mas ainda há empecilhos para que a HR3D chegue ao mercado, mesmo em dispositivos não-portáteis: ela é altamente intensiva em computação.

Por isso, os pesquisadores planejam agora debruçar-se sobre o algoritmo que efetua os cálculos da barreira de paralaxe para torná-lo menos computacionalmente intensivo.

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=mit-tecnologia-3-d-sem-oculos&id=010110110510&ebol=sim

China apresenta planos de sua estação espacial

Redação do Site Inovação Tecnológica - 10/05/2011

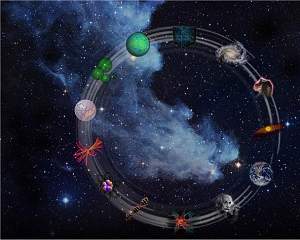

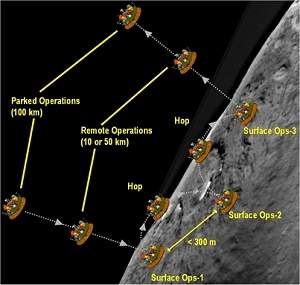

O projeto prevê que a estação espacial chinesa esteja pronta em 2020. [Imagem: Adaptado de Nature]

Ainda faltam dois voos dos ônibus espaciais para garantir o término da construção da Estação Espacial Internacional.

Mas já surgem no horizonte os primeiros sinais de uma estação espacial "Made in China".

Estação Espacial Chinesa

Depois de muitos acenos e especulações, oficiais ligados ao programa espacial chinês deram as primeiras informações sobre aquele que é considerado o próximo passo necessário dos voos tripulados do país - o estabelecimento de uma base permanente em órbita da Terra.

A estação espacial chinesa será muito menor do que a ISS, e menor mesmo do que a antiga estação russa MIR.

A estação terá um módulo principal de 18,1 metros de comprimento, capaz de abrigar três astronautas (ou taikonautas) e dois módulos com laboratórios medindo 14,4 metros cada um.

Haverá ainda pontos de atracação para uma nave tripulada e para uma nave de carga, que poderão ficar ligadas à estação ao mesmo tempo.

Os oficiais anunciaram também o lançamento de um concurso nacional para batizar a estação espacial chinesa.

Passo a passo

Seguindo os passos dos Estados Unidos e da antiga União Soviética, a China empreenderá uma série de missões preparatórias para o estabelecimento de uma ocupação permanente no espaço.

Até o final de 2011, será tentada a primeira atracação automática de duas naves chinesas não-tripuladas, a Tiangong 1 e a Shenzhou 8 - a Shenzhou 5 levou o primeiro astronauta chinês ao espaço. Essa capacidade é essencial para a construção e a operação de uma estação espacial.

Se tudo correr bem, duas naves Shenzhou tripuladas se unirão à Tiangong 1 em 2012.

As naves não-tripuladas Tiangong 2 e Tiangong 3 serão as próximas, fazendo os primeiros testes de laboratórios no espaço - a primeira terá uma missão de 20 dias e a segunda ficará no espaço por 40 dias.

O passo final será lançar os módulos definitivos da estação.

Compatibilidade espacial

Já fazem 20 anos desde que a China anunciou pela primeira vez a intenção de construir sua própria estação espacial. Mas lá, como no ocidente, o projeto enfrentou grandes controvérsias dentro da própria comunidade espacial, sempre às voltas com o dilema entre voos tripulados e uma exploração espacial robotizada.

A segunda opção é tida como mais barata e mais simples, enquanto a segunda é mais flexível e tem maior apelo junto ao público.

O projeto prevê que a estação espacial chinesa esteja pronta em 2020, uma época interessante, quando a Estação Espacial Internacional estará se aproximando do final de sua vida útil e com os primeiros problemas de obsolescência.

De olho em um mercado potencial, as autoridades chinesas afirmam que as docas de atracação da estação serão totalmente compatíveis com as da Estação Espacial Internacional, o que permitirá a recepção de naves dos Estados Unidos (NASA), Rússia (Roscosmos), Europa (ESA) e Japão (JAXA).

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=estacao-espacial-china&id=020130110510&ebol=sim

O projeto prevê que a estação espacial chinesa esteja pronta em 2020. [Imagem: Adaptado de Nature]

Ainda faltam dois voos dos ônibus espaciais para garantir o término da construção da Estação Espacial Internacional.

Mas já surgem no horizonte os primeiros sinais de uma estação espacial "Made in China".

Estação Espacial Chinesa

Depois de muitos acenos e especulações, oficiais ligados ao programa espacial chinês deram as primeiras informações sobre aquele que é considerado o próximo passo necessário dos voos tripulados do país - o estabelecimento de uma base permanente em órbita da Terra.

A estação espacial chinesa será muito menor do que a ISS, e menor mesmo do que a antiga estação russa MIR.

A estação terá um módulo principal de 18,1 metros de comprimento, capaz de abrigar três astronautas (ou taikonautas) e dois módulos com laboratórios medindo 14,4 metros cada um.

Haverá ainda pontos de atracação para uma nave tripulada e para uma nave de carga, que poderão ficar ligadas à estação ao mesmo tempo.

Os oficiais anunciaram também o lançamento de um concurso nacional para batizar a estação espacial chinesa.

Passo a passo

Seguindo os passos dos Estados Unidos e da antiga União Soviética, a China empreenderá uma série de missões preparatórias para o estabelecimento de uma ocupação permanente no espaço.

Até o final de 2011, será tentada a primeira atracação automática de duas naves chinesas não-tripuladas, a Tiangong 1 e a Shenzhou 8 - a Shenzhou 5 levou o primeiro astronauta chinês ao espaço. Essa capacidade é essencial para a construção e a operação de uma estação espacial.

Se tudo correr bem, duas naves Shenzhou tripuladas se unirão à Tiangong 1 em 2012.

As naves não-tripuladas Tiangong 2 e Tiangong 3 serão as próximas, fazendo os primeiros testes de laboratórios no espaço - a primeira terá uma missão de 20 dias e a segunda ficará no espaço por 40 dias.

O passo final será lançar os módulos definitivos da estação.

Compatibilidade espacial

Já fazem 20 anos desde que a China anunciou pela primeira vez a intenção de construir sua própria estação espacial. Mas lá, como no ocidente, o projeto enfrentou grandes controvérsias dentro da própria comunidade espacial, sempre às voltas com o dilema entre voos tripulados e uma exploração espacial robotizada.

A segunda opção é tida como mais barata e mais simples, enquanto a segunda é mais flexível e tem maior apelo junto ao público.

O projeto prevê que a estação espacial chinesa esteja pronta em 2020, uma época interessante, quando a Estação Espacial Internacional estará se aproximando do final de sua vida útil e com os primeiros problemas de obsolescência.

De olho em um mercado potencial, as autoridades chinesas afirmam que as docas de atracação da estação serão totalmente compatíveis com as da Estação Espacial Internacional, o que permitirá a recepção de naves dos Estados Unidos (NASA), Rússia (Roscosmos), Europa (ESA) e Japão (JAXA).

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=estacao-espacial-china&id=020130110510&ebol=sim

Descoberto um dos primeiros minerais do Sistema Solar

Redação do Site Inovação Tecnológica - 09/05/2011

O Ovo Trincado, no qual a crotita foi descoberta, é uma formação inteiramente mineral.[Imagem: Chi Ma]

Inclusões minerais

Geólogos anunciaram a descoberta de um autêntico fóssil mineral, um dos primeiros minerais formados em nosso Sistema Solar.

O mineral, chamado crotita, é o principal componente de uma inclusão incomum, incorporada no interior de um meteorito (NWA 1934) que foi encontrado no noroeste da África.

Acredita-se que essas formações, conhecidas como inclusões refratárias, sejam os primeiros materiais planetários que se formaram naquilo que veio a se tornar o nosso Sistema Solar - antes da formação da Terra e dos outros planetas.

Fóssil mineral

O grão mineral em particular agora estudado é conhecido carinhosamente como "Ovo Trincado", pelo seu aspecto característico - mas a formação é inteiramente mineral, não havendo nenhum fóssil biológico envolvido.

Os pesquisadores descobriram que o grânulo é de um tipo muito especial, conhecido como inclusão refratária, rica em cálcio e alumínio.

O termo refratário refere-se ao fato de que estes grãos contêm minerais que são estáveis a temperatura muito altas, o que comprova sua provável formação muito primitiva, condensando-se nas altas temperatura da nebulosa solar.

O principal componente do grão é um óxido de alumínio e cálcio de baixa pressão (CaAl2O4), nunca antes encontrado na natureza.

A determinação do arranjo atômico no mineral mostrou que a sua estrutura é a mesma de um componente sintético de alguns tipos de concretos refratários, usados em fornos, lareiras e churrasqueiras.

Nebulosa solar

E que informação podemos ter ao descobrir que um componente comum de um tipo de concreto feito pelo homem é encontrado na natureza apenas como um componente muito raro, em um grão formado mais de 4,5 bilhões de anos atrás?

Estes estudos são essenciais para decifrar as origens do nosso Sistema Solar - a criação do composto sintético equivalente requer temperaturas de pelo menos 1.500 ° C.

Isto, aliado ao fato de que o composto se forma sob baixas pressões, é consistente com a formação da crotita como uma fase refratária da nebulosa solar.

Daí a grande probabilidade de que a crotita seja um dos primeiros minerais a se formarem em nosso Sistema Solar.

Ovo Trincado

Estudos sobre essas inclusões inéditas encontradas no Ovo Trincado vão continuar, em um esforço para aprender mais sobre as condições em que elas se formaram e, posteriormente, evoluíram.

Além da crotita, o Ovo Trincado contém pelo menos oito outros minerais, incluindo um outro mineral inédito para a ciência e que ainda está sendo catalogado.

Bibliografia:

Krotite, CaAl2O4, a new refractory mineral from the NWA 1934 meteorite.

Chi Ma, Anthony R. Kampf, Harold C. Connolly Jr., John R. Beckett, George R. Rossman, Stuart A. Sweeney Smith, Devin L. Schrader

American Mineralogist

May 2011

Vol.: 96, pages 709-715, 2011

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=fossil-mineral-primeiro-mineral-sistema-solar&id=020130110509&ebol=sim

O Ovo Trincado, no qual a crotita foi descoberta, é uma formação inteiramente mineral.[Imagem: Chi Ma]

Inclusões minerais

Geólogos anunciaram a descoberta de um autêntico fóssil mineral, um dos primeiros minerais formados em nosso Sistema Solar.

O mineral, chamado crotita, é o principal componente de uma inclusão incomum, incorporada no interior de um meteorito (NWA 1934) que foi encontrado no noroeste da África.

Acredita-se que essas formações, conhecidas como inclusões refratárias, sejam os primeiros materiais planetários que se formaram naquilo que veio a se tornar o nosso Sistema Solar - antes da formação da Terra e dos outros planetas.

Fóssil mineral

O grão mineral em particular agora estudado é conhecido carinhosamente como "Ovo Trincado", pelo seu aspecto característico - mas a formação é inteiramente mineral, não havendo nenhum fóssil biológico envolvido.

Os pesquisadores descobriram que o grânulo é de um tipo muito especial, conhecido como inclusão refratária, rica em cálcio e alumínio.

O termo refratário refere-se ao fato de que estes grãos contêm minerais que são estáveis a temperatura muito altas, o que comprova sua provável formação muito primitiva, condensando-se nas altas temperatura da nebulosa solar.

O principal componente do grão é um óxido de alumínio e cálcio de baixa pressão (CaAl2O4), nunca antes encontrado na natureza.

A determinação do arranjo atômico no mineral mostrou que a sua estrutura é a mesma de um componente sintético de alguns tipos de concretos refratários, usados em fornos, lareiras e churrasqueiras.

Nebulosa solar

E que informação podemos ter ao descobrir que um componente comum de um tipo de concreto feito pelo homem é encontrado na natureza apenas como um componente muito raro, em um grão formado mais de 4,5 bilhões de anos atrás?

Estes estudos são essenciais para decifrar as origens do nosso Sistema Solar - a criação do composto sintético equivalente requer temperaturas de pelo menos 1.500 ° C.

Isto, aliado ao fato de que o composto se forma sob baixas pressões, é consistente com a formação da crotita como uma fase refratária da nebulosa solar.

Daí a grande probabilidade de que a crotita seja um dos primeiros minerais a se formarem em nosso Sistema Solar.

Ovo Trincado

Estudos sobre essas inclusões inéditas encontradas no Ovo Trincado vão continuar, em um esforço para aprender mais sobre as condições em que elas se formaram e, posteriormente, evoluíram.

Além da crotita, o Ovo Trincado contém pelo menos oito outros minerais, incluindo um outro mineral inédito para a ciência e que ainda está sendo catalogado.

Bibliografia:

Krotite, CaAl2O4, a new refractory mineral from the NWA 1934 meteorite.

Chi Ma, Anthony R. Kampf, Harold C. Connolly Jr., John R. Beckett, George R. Rossman, Stuart A. Sweeney Smith, Devin L. Schrader

American Mineralogist

May 2011

Vol.: 96, pages 709-715, 2011

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=fossil-mineral-primeiro-mineral-sistema-solar&id=020130110509&ebol=sim

Cientista propõe construção de um laser nuclear

David Harris - Physical Review Focus - 09/05/2011

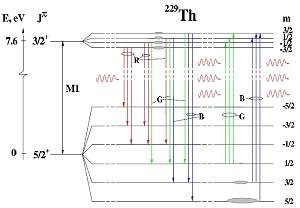

Um laser baseado na excitação do núcleo dos átomos, em vez dos elétrons, pode ser possível usando uma liga de tório. O laser nuclear emitiria luz visível e seria um passo rumo ao laser de raios gama.[Imagem: Getty Images/APS]

Laser nuclear

Há anos os físicos tentam construir um laser nuclear - um laser que dependa da excitação dos núcleos dos átomos, e não dos elétrons.

Finalmente, um pesquisador russo está propondo um caminho viável para a criação desse tipo inovador de laser, fundamentando-se em algumas peculiaridades da estrutura nuclear do tório.

Embora seja chamado de "laser nuclear", por se basear no núcleo atômico, ele emite luz visível, e não os raios gama normalmente associados com a radiação nuclear.

Um laser nuclear poderia fornecer uma nova base para medir o tempo - imagine um relógio nuclear, em vez de um relógio atômico - e testar muitas propriedades fundamentais da natureza, como a possível variação das constantes fundamentais da física ao longo do tempo.

Rumo ao laser de raios gama

"O laser de raios-gama real é um sonho da ciência," afirma Eugene Tkalya, da Universidade Estadual de Moscou, na Rússia, afirmando que o interesse dos físicos nesse laser volta-se para estudo da física mais fundamental - mentes mais destrutivas certamente imaginam outros usos para ele.

Contudo, não são muitas as transições eletrônicas nos átomos que emitem raios gama. Assim, os pesquisadores se voltaram para as transições no núcleo atômico.

No entanto, o laser de raios gama, ou graser, tem enfrentado um pesado ceticismo, como ilustrado pelo comentário do físico Hans Frauenfelder, do Laboratório Nacional Los Alamos, depois de uma conversa com Vitali Goldanskii, do Instituto de Química e Física em Moscou: "Querido Vitali, eu sempre achei que um laser de gama é impossível. Depois de sua palestra, ele parece muitas ordens de magnitude menos impossível. Mas eu ainda o considero impossível. "

Os dois grandes desafios têm sido encontrar uma transição nuclear adequada, que possa ser efetivamente excitada em laboratório, e criar a chamada inversão de população, onde há mais núcleos excitados do que não excitados, algo que é necessário para a geração do laser.

Laser nuclear visível

Para resolver estes problemas, Tkalya propõe um laser nuclear na faixa de comprimentos de onda visíveis, e não na faixa dos raios gama. Mas ele seria o primeiro laser nuclear e a melhor aproximação de um laser de raios gama verdadeiro.

O esquema consiste na substituição de alguns átomos de cálcio por tório em um composto de cálcio, lítio, alumínio e flúor (LiCaAlF6).

Por obra da natureza, o núcleo de tório neste material tem uma transição de 10 elétron-volts partindo do seu estado fundamental para um estado excitado, e a transição é diferente em energia das transições dos elétrons no átomo.

Isso significa que fótons visíveis na frequência correta podem evitar os elétrons e interagirem diretamente com o núcleo, de acordo com cálculos do Tkalya.

Para criar uma inversão de população, Tkalya propõe tomar emprestado um truque usado nos lasers atômicos convencionais - usar um terceiro nível de energia, além dos estados fundamental e excitado do núcleo.

O estado fundamental do tório pode ser dividido em vários níveis de energia (subníveis de Zeeman), muito próximos uns dos outros. [Imagem: E. V. Tkalya]

Aplicando um forte campo magnético, de cerca de 100 tesla, ou um forte gradiente de campo elétrico, de 10 a 18 volts por centímetro quadrado, os experimentalistas poderiam dividir o estado fundamental em vários níveis de energia muito próximos uns dos outros.

Os níveis mais elevados são geralmente vazios - núcleos nestes estados decaem rapidamente a um estado fundamental verdadeiro. Assim, um deles poderia servir como o estado mais baixo para o processo de geração do laser.

No esquema de Tkalya, o núcleo de tório seria bombeado para um estado excitado específico, de longa duração, com fótons de um laser ultravioleta, dando a este estado uma população mais alta do que o estado não-exatamente-fundamental. Esta inversão de população induziria o processo de geração do laser.

Energia de transição

Outra questão para um laser nuclear é que os núcleos devem emitir radiação sem recuo, uma vez que um recuo significativo significaria que um fóton seria emitido com uma frequência deslocada, e não poderia estimular a emissão em outros núcleos.

Como em outros esquemas de laser nuclear, Tkalya mostra que este problema é resolvido pelo efeito Mössbauer, pelo qual os núcleos em um sólido não recuam individualmente, mas fazem com que a rede atômica inteira recue em uma medida minúscula. Esta participação da rede mantém o fóton emitido na frequência correta para estimular outros núcleos.

"Tkalya parece ter sucesso onde outros falharam, em grande parte porque a transição nuclear que ele escolheu tem uma energia de transição muito menor,", comenta Eric Hudson, da Universidade da Califórnia, em Los Angeles. "Um trabalho como esse nos leva mais perto de sermos capazes de interagir de forma coerente com os estados dos núcleos dos átomos e controlá-los."

Hudson afirma que o laser nuclear poderia viabilizar tecnologias como melhores medições do tempo, processamento de informações quânticas e novos tipos de fontes de radiação.

Bibliografia:

Proposal for a Nuclear Gamma-Ray Laser of Optical Range

E. V. Tkalya

Physical Review Letters

Vol.: 106, 162501 (2011)

DOI: 10.1103/PhysRevLett.106.162501

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=laser-nuclear&id=010115110509&ebol=sim

Um laser baseado na excitação do núcleo dos átomos, em vez dos elétrons, pode ser possível usando uma liga de tório. O laser nuclear emitiria luz visível e seria um passo rumo ao laser de raios gama.[Imagem: Getty Images/APS]

Laser nuclear

Há anos os físicos tentam construir um laser nuclear - um laser que dependa da excitação dos núcleos dos átomos, e não dos elétrons.

Finalmente, um pesquisador russo está propondo um caminho viável para a criação desse tipo inovador de laser, fundamentando-se em algumas peculiaridades da estrutura nuclear do tório.

Embora seja chamado de "laser nuclear", por se basear no núcleo atômico, ele emite luz visível, e não os raios gama normalmente associados com a radiação nuclear.