Uma empresa ainda na incubadora da Coppe-UFRJ desenvolveu uma tecnologia de prospecção de petróleo no mar que pode revolucionar o setor.

Uma empresa ainda em gestação na incubadora da Coordenação dos Programas de Pós Graduação em Engenharia da Universidade Federal do Rio de Janeiro (Coppe-UFRJ), tocada por um geólogo e um oceanógrafo cariocas, desenvolveu uma nova tecnologia de prospecção de petróleo no mar que pode revolucionar o setor, barateando muito os custos da busca por novos reservatórios.

Chamada modelagem inversa, a técnica permite descobrir, com elevado grau de certeza, o local de origem de manchas de óleo na superfície decorrentes de vazamentos espontâneos dos reservatórios por fendas geológicas, reduzindo em até 75 vezes o tamanho da área a ser investigada.

O oceanólogo Manlio Mano, de 36 anos, graduado na Universidade Estadual do Rio de Janeiro (Uerj) e doutorado em modelagem computacional na Coppe, explica que o modelo desenvolvido por ele e pelo geólogo Carlos Beisl, de 41 anos, seu sócio na empresa OilFinder, permite percorrer exatamente o caminho inverso ao da mancha, detectada por satélite, até a fenda pela qual o óleo escapou do reservatório, geralmente em decorrência de um dos muitos pequenos abalos sísmicos que ocorrem o tempo todo no solo marinho.

O cientista explica que a técnica teve origem na sua tese de doutorado e levou três anos em processo de validação (testes). Em parceria com a Coppe, a Petrobras testou com sucesso a tecnologia, inclusive no campo de Lula (ex-Tupi), quando este já estava descoberto.

De acordo com o técnico carioca, de 80% a 90% das áreas identificadas nos testes feitos pela Petrobras e pela Coppe estavam sobre estruturas compatíveis com o óleo encontrado na superfície. O índice de acerto esperado, segundo ele, era de 30% a 40%.

Como os resultados dos testes feitos pela Petrobras são segredos comerciais dela, a OilFinder decidiu fazer ela mesma um teste em uma área ainda não licitada pela Agência Nacional do Petróleo (ANP). A área em questão, de 43 Km², fica a sudeste de Cabo Frio (RJ), na vizinhança dos blocos exploratórios BM-C-44 e BM-C-46 e dos campos de produção de Maromba e Papa Terra. A localização exata do seu centro é longitude 41°12'15" Oeste e latitude 26°37'07" Sul.

A modelagem inversa mostrou que três manchas, uma delas localizada a mais de 60 quilômetros do ponto de origem, convergiam para o mesmo ponto. Os resultados ainda são inéditos e serão divulgados hoje por Mano em um evento do qual participará em Curitiba.

Segundo o cientista, a convergência mínima de três manchas para a mesma origem é o critério de confiabilidade que permite a divulgação do resultado, embora haja outras variáveis envolvidas na análise. Foi estabelecida uma escala decrescente de 1 a 6 para definir o nível de confiabilidade de um teste realizado, na qual 1 corresponde à confiabilidade máxima e 6, à mínima. O teste feito pela OilFinder recebeu confiabilidade nível 4.

Como não há limite para a idade das imagens de satélite utilizadas para detectar a origem das manchas, Mano explica que fica fácil saber se determinada mancha veio de uma fenda ou de alguma poluição ambiental provocada pelo homem. Basta usar uma imagem mais antiga do que as instalações de origem humanas existentes na região que possam ter liberado uma mancha de óleo (plataformas, portos e outros).

Mano disse que a tecnologia é com certeza inédita no Brasil e quase com certeza, no mundo. Segundo ele, dois fornecedores de imagens de satélite (todos são estrangeiros) já procuraram a OilFinder para negociar a venda do pacote completo, o que seria uma prova do ineditismo da técnica também fora do Brasil.

Agora, os dois sócios vão preparar pacotes com estudos das áreas que serão licitadas na 11ª Rodada de licitações da ANP, marcada para setembro. Mano disse que o planejamento da OilFinder, fundada com investimentos de R$ 20 mil (ela usa, em regime de aluguel, o supercomputador da Coppe para fazer seus trabalhos), a empresa planejava faturar US$ 2 milhões em 2010/2011, mas está revendo esse plano após a divulgação pela ANP da realização dos leilões.

O técnico esclarece que a tecnologia que ele e Beisl desenvolveram não elimina nenhuma das etapas convencionais de um trabalho de prospecção de óleo. "Ela vem para orientar o planejamento e aumentar a taxa de sucesso", pondera o cientista.

Segundo o técnico e empresário, a tecnologia da OilFinder permite, por exemplo, que uma empresa que precisa furar dois poços para avaliar uma determinada área, mas que só tem recursos para um, decidir com segurança qual o melhor ponto para fazer essa única perfuração.

(Valor Econômico)

Fonte:http://www.jornaldaciencia.org.br/Detalhe.jsp?id=77409

Translate

sexta-feira, 6 de maio de 2011

Intel apresenta transistores 3-D de 22 nanômetros

Redação do Site Inovação Tecnológica - 06/05/2011

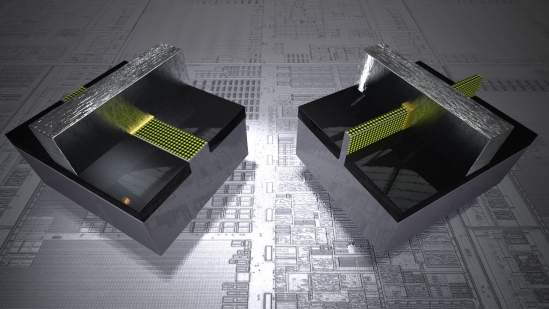

Ilustração comparando um transístor planar de 32 nanômetros com o novo transístor 3-D de 22 nanômetros. À esquerda está o transístor planar, no qual a corrente, representada pelos pontos amarelos, flui em um plano sob a porta. À direita está o transístor 3-D, no qual a corrente flui nos três lados de uma saliência que se eleva verticalmente da pastilha de silício.[Imagem: Intel]

Tri-Gate

A Intel anunciou o início da fabricação em escala industrial de transistores 3-D com estruturas de 22 nanômetros.

Ainda não são os tão esperados processadores 3-D, mas representam um inegável avanço em direção à economia de energia e um novo fôlego para a Lei de Moore.

Os transistores 3-D, chamados Tri-Gate, serão usados na fabricação de uma família de microprocessadores de 22 nanômetros que atende pelo codinome de Ivy Bridge.

Transístor 3-D

Desde a invenção de transístor, há mais de 60 anos, esta é a primeira vez que um transístor 3-D entra em linha industrial de produção.

Um transístor possui três portas, ou eletrodos, chamadas emissor, coletor e base. Nos transistores planos atuais, esses eletrodos são construídos como três fios salientes sobre uma superfície de silício.

No Tri-Gate, cada porta fica em um dos planos de uma única saliência - uma de cada um dos lados e outra no topo - reduzindo significativamente a área ocupada pelo transístor.

A maior proximidade das portas permite um melhor controle da corrente, o que significa que mais corrente pode passar quando o transístor está na condição "ligado" - aumentando o desempenho - e quase nenhuma corrente flui quando ele está na condição "desligado" - diminuindo o consumo de energia.

Esses ganhos podem ser ampliados até um certo limite, ao menos teoricamente, aumentando a altura da estrutura Tri-Gate, o que deverá ser obtido nas futuras gerações dos transistores 3-D.

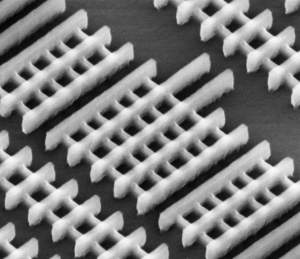

No Tri-Gate, cada porta fica em um dos planos de uma única saliência - uma de cada um dos lados e outra no topo - reduzindo significativamente a área ocupada pelo transístor. [Imagem: Intel]

Desempenho e economia de energia

Segundo a Intel, seus transistores 3-D Tri-Gate permitem que os chips funcionem com uma tensão menor e sofram menos dos famigerados "vazamentos de corrente", "oferecendo uma combinação sem precedentes de desempenho e eficiência energética."

Os transistores de 3-D Tri-Gate de 22 nanômetros apresentam um desempenho até 37 por cento maior do que os atuais transistores planos de 32 nanômetros da empresa, quando ambos operam sob baixa tensão.

Quando comparados funcionando a plena potência, os transistores 3-D consomem metade da energia dos transistores planares atuais.

Mas tudo continua apontando para a manutenção das "famílias" de processadores - umas voltadas para baixo consumo de energia, usadas em computadores portáteis, e outras voltadas para alto desempenho, com maior consumo de energia.

Nova dimensão

Os transistores tridimensionais representam uma mudança radical da estrutura do transístor planar bidimensional clássico, presente não apenas em todos os computadores, telefones celulares e equipamentos eletrônicos de consumo, mas também nos controles eletrônicos dentro de carros, satélites e sondas espaciais, eletrodomésticos, dispositivos médicos etc.

Os cientistas reconhecem há muito tempo os benefícios da estrutura 3-D não apenas para os transistores individualmente, mas também para o próprio chip como um todo. Mas essas vantagens, demonstradas há anos em laboratório, dependem de outros elementos para migrarem para as fábricas - elementos de natureza técnica e econômica.

O elevado consumo de energia dos processadores atuais, que os fez estacionar em termos de clock ao longo dos últimos anos, parece ter sido a razão técnica que faltava. Mesmo o advento dos processadores com múltiplos núcleos não parecia ser suficiente para salvar a Lei de Moore.

Só uma revolução garantirá os futuros avanços da computação

O primeiro protótipo de processador de 22 nanômetros foi apresentado pela Intel equipando um notebook. A previsão é que os primeiros processadores Ivy Bridge cheguem ao mercado até o final de 2011.

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=intel-transistores-3-d&id=010110110506&ebol=sim

Ilustração comparando um transístor planar de 32 nanômetros com o novo transístor 3-D de 22 nanômetros. À esquerda está o transístor planar, no qual a corrente, representada pelos pontos amarelos, flui em um plano sob a porta. À direita está o transístor 3-D, no qual a corrente flui nos três lados de uma saliência que se eleva verticalmente da pastilha de silício.[Imagem: Intel]

Tri-Gate

A Intel anunciou o início da fabricação em escala industrial de transistores 3-D com estruturas de 22 nanômetros.

Ainda não são os tão esperados processadores 3-D, mas representam um inegável avanço em direção à economia de energia e um novo fôlego para a Lei de Moore.

Os transistores 3-D, chamados Tri-Gate, serão usados na fabricação de uma família de microprocessadores de 22 nanômetros que atende pelo codinome de Ivy Bridge.

Transístor 3-D

Desde a invenção de transístor, há mais de 60 anos, esta é a primeira vez que um transístor 3-D entra em linha industrial de produção.

Um transístor possui três portas, ou eletrodos, chamadas emissor, coletor e base. Nos transistores planos atuais, esses eletrodos são construídos como três fios salientes sobre uma superfície de silício.

No Tri-Gate, cada porta fica em um dos planos de uma única saliência - uma de cada um dos lados e outra no topo - reduzindo significativamente a área ocupada pelo transístor.

A maior proximidade das portas permite um melhor controle da corrente, o que significa que mais corrente pode passar quando o transístor está na condição "ligado" - aumentando o desempenho - e quase nenhuma corrente flui quando ele está na condição "desligado" - diminuindo o consumo de energia.

Esses ganhos podem ser ampliados até um certo limite, ao menos teoricamente, aumentando a altura da estrutura Tri-Gate, o que deverá ser obtido nas futuras gerações dos transistores 3-D.

No Tri-Gate, cada porta fica em um dos planos de uma única saliência - uma de cada um dos lados e outra no topo - reduzindo significativamente a área ocupada pelo transístor. [Imagem: Intel]

Desempenho e economia de energia

Segundo a Intel, seus transistores 3-D Tri-Gate permitem que os chips funcionem com uma tensão menor e sofram menos dos famigerados "vazamentos de corrente", "oferecendo uma combinação sem precedentes de desempenho e eficiência energética."

Os transistores de 3-D Tri-Gate de 22 nanômetros apresentam um desempenho até 37 por cento maior do que os atuais transistores planos de 32 nanômetros da empresa, quando ambos operam sob baixa tensão.

Quando comparados funcionando a plena potência, os transistores 3-D consomem metade da energia dos transistores planares atuais.

Mas tudo continua apontando para a manutenção das "famílias" de processadores - umas voltadas para baixo consumo de energia, usadas em computadores portáteis, e outras voltadas para alto desempenho, com maior consumo de energia.

Nova dimensão

Os transistores tridimensionais representam uma mudança radical da estrutura do transístor planar bidimensional clássico, presente não apenas em todos os computadores, telefones celulares e equipamentos eletrônicos de consumo, mas também nos controles eletrônicos dentro de carros, satélites e sondas espaciais, eletrodomésticos, dispositivos médicos etc.

Os cientistas reconhecem há muito tempo os benefícios da estrutura 3-D não apenas para os transistores individualmente, mas também para o próprio chip como um todo. Mas essas vantagens, demonstradas há anos em laboratório, dependem de outros elementos para migrarem para as fábricas - elementos de natureza técnica e econômica.

O elevado consumo de energia dos processadores atuais, que os fez estacionar em termos de clock ao longo dos últimos anos, parece ter sido a razão técnica que faltava. Mesmo o advento dos processadores com múltiplos núcleos não parecia ser suficiente para salvar a Lei de Moore.

Só uma revolução garantirá os futuros avanços da computação

O primeiro protótipo de processador de 22 nanômetros foi apresentado pela Intel equipando um notebook. A previsão é que os primeiros processadores Ivy Bridge cheguem ao mercado até o final de 2011.

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=intel-transistores-3-d&id=010110110506&ebol=sim

Descoberta nova forma de geração de magnetismo

Redação do Site Inovação Tecnológica - 04/05/2011

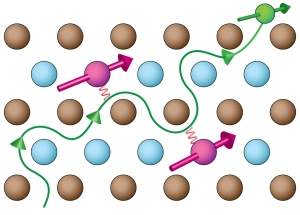

Representação esquemática do filme de Co:TiO2. O ferromagnetismo surge neste material porque os elétrons 3d do titânio (em verde) viajam ao longo do material, alinhando o spin dos átomos de cobalto (em rosa) e fazendo-os apontar na mesma direção. As esferas azuis e cinzas correspondem aos átomos de titânio e oxigênio, respectivamente.[Imagem: Takumi Ohtsuki]

Onda magnética

Se, ao ouvir falar de magnetismo, tudo o que lhe ocorre é uma barra de material ferroso com um pólo norte e um pólo sul, talvez seja melhor se atualizar.

Em menos de dois anos, a ciência se deparou com magnetismo no grafite, magnetismo artificial usando lasers, magnetismo intrínseco do silício, magnetismo da luz, magnetismo entre materiais diferentes, um magnetismo que pode ser ligado e desligado e até a possibilidade de conversão de magnetismo em eletricidade - sem precisar de um gerador.

Parece ser bastante? Não para Takumi Ohtsuki e seus colegas do Instituto Riken, no Japão.

Os pesquisadores descobriram um novo mecanismo capaz de gerar magnetismo, um mecanismo que torna um material magnético sem qualquer influência externa e a temperatura ambiente.

Óxido ferromagnético diluto

A descoberta foi feita em um material chamado óxido ferromagnético diluto, formado por dióxido de titânio dopado com cobalto - conhecido como Co:TiO2.

"Vários mecanismos têm sido sugeridos para explicar a origem do ferromagnetismo no Co:TiO2, mas nunca se chegou a uma conclusão definitiva," diz Ohtsuki.

Usando uma técnica de caracterização da estrutura atômica de materiais, conhecida como espectroscopia por fotoemissão de raios X, os pesquisadores descobriram que o magnetismo é gerado pelos elétrons da terceira camada - chamada 3d - dos íons de titânio.

Os elétrons 3d do titânio alinham os spins dos átomos de cobalto conforme viajam através do material, o que mostra uma conexão entre a eletricidade - os elétrons em movimento - e o magnetismo

Este mecanismo de magnetismo mediado pela circulação dos elétrons nunca havia sido aventado nem mesmo pelos teóricos.

Spintrônica

"Nossos resultados comprovam que o magnetismo está correlacionado com a condutividade no Co:TiO2," diz o Dr. Ohtsuki. "Isto pode tornar o material aplicável na fabricação de memórias de acesso aleatório magnéticas (MRAM) ou em transistores spintrônicos."

A spintrônica, também conhecida como magnetoeletrônica, poderá substituir a eletrônica nas memórias de computador e no processamento de dados, criando uma nova onda tecnológica, onde os computadores serão mais rápidos e consumirão uma fração da energia consumida hoje.

Bibliografia:

Role of Ti 3d Carriers in Mediating the Ferromagnetism of Co?TiO2 Anatase Thin Films

T. Ohtsuki, A. Chainani, R. Eguchi, M. Matsunami, Y. Takata, M. Taguchi, Y. Nishino, K. Tamasaku, M. Yabashi, T. Ishikawa, M. Oura, Y. Senba, H. Ohashi, S. Shin

Physical Review Letters

Vol.: 106, 047602

DOI: 10.1103/PhysRevLett.106.047602

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=nova-forma-geracao-magnetismo&id=010110110504&ebol=sim

Representação esquemática do filme de Co:TiO2. O ferromagnetismo surge neste material porque os elétrons 3d do titânio (em verde) viajam ao longo do material, alinhando o spin dos átomos de cobalto (em rosa) e fazendo-os apontar na mesma direção. As esferas azuis e cinzas correspondem aos átomos de titânio e oxigênio, respectivamente.[Imagem: Takumi Ohtsuki]

Onda magnética

Se, ao ouvir falar de magnetismo, tudo o que lhe ocorre é uma barra de material ferroso com um pólo norte e um pólo sul, talvez seja melhor se atualizar.

Em menos de dois anos, a ciência se deparou com magnetismo no grafite, magnetismo artificial usando lasers, magnetismo intrínseco do silício, magnetismo da luz, magnetismo entre materiais diferentes, um magnetismo que pode ser ligado e desligado e até a possibilidade de conversão de magnetismo em eletricidade - sem precisar de um gerador.

Parece ser bastante? Não para Takumi Ohtsuki e seus colegas do Instituto Riken, no Japão.

Os pesquisadores descobriram um novo mecanismo capaz de gerar magnetismo, um mecanismo que torna um material magnético sem qualquer influência externa e a temperatura ambiente.

Óxido ferromagnético diluto

A descoberta foi feita em um material chamado óxido ferromagnético diluto, formado por dióxido de titânio dopado com cobalto - conhecido como Co:TiO2.

"Vários mecanismos têm sido sugeridos para explicar a origem do ferromagnetismo no Co:TiO2, mas nunca se chegou a uma conclusão definitiva," diz Ohtsuki.

Usando uma técnica de caracterização da estrutura atômica de materiais, conhecida como espectroscopia por fotoemissão de raios X, os pesquisadores descobriram que o magnetismo é gerado pelos elétrons da terceira camada - chamada 3d - dos íons de titânio.

Os elétrons 3d do titânio alinham os spins dos átomos de cobalto conforme viajam através do material, o que mostra uma conexão entre a eletricidade - os elétrons em movimento - e o magnetismo

Este mecanismo de magnetismo mediado pela circulação dos elétrons nunca havia sido aventado nem mesmo pelos teóricos.

Spintrônica

"Nossos resultados comprovam que o magnetismo está correlacionado com a condutividade no Co:TiO2," diz o Dr. Ohtsuki. "Isto pode tornar o material aplicável na fabricação de memórias de acesso aleatório magnéticas (MRAM) ou em transistores spintrônicos."

A spintrônica, também conhecida como magnetoeletrônica, poderá substituir a eletrônica nas memórias de computador e no processamento de dados, criando uma nova onda tecnológica, onde os computadores serão mais rápidos e consumirão uma fração da energia consumida hoje.

Bibliografia:

Role of Ti 3d Carriers in Mediating the Ferromagnetism of Co?TiO2 Anatase Thin Films

T. Ohtsuki, A. Chainani, R. Eguchi, M. Matsunami, Y. Takata, M. Taguchi, Y. Nishino, K. Tamasaku, M. Yabashi, T. Ishikawa, M. Oura, Y. Senba, H. Ohashi, S. Shin

Physical Review Letters

Vol.: 106, 047602

DOI: 10.1103/PhysRevLett.106.047602

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=nova-forma-geracao-magnetismo&id=010110110504&ebol=sim

Einstein, o espaço-tempo e o fracasso de um épico

Redação do Site Inovação Tecnológica - 06/05/2011

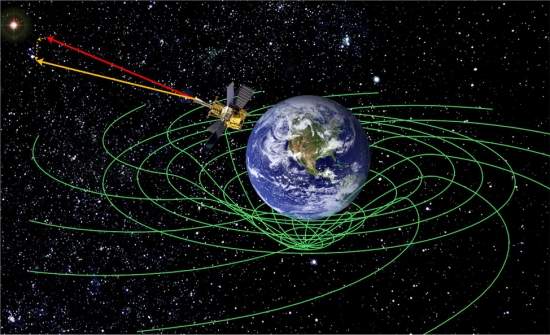

Apesar da precisão de seus giroscópios, a Gravity Probe B nem se aproximou da precisão que seus projetistas esperavam dela. [Imagem: NASA/Stanford]

Einstein estava certo... de novo. Há um vórtice no espaço-tempo ao redor da Terra, e sua forma corresponde precisamente às previsões da teoria da gravitação de Einstein.

A conclusão é de uma das mais impressionantes sondas espaciais já lançadas, a Gravity Probe B, uma verdadeira maravilha da engenharia.

Imprecisão

Assim posto, tudo parece ser motivo para comemorações.

Infelizmente, não é.

Apesar da precisão de seus giroscópios, a Gravity Probe B nem se aproximou da precisão que seus projetistas esperavam dela.

Na verdade, o anúncio feito pela NASA acrescenta pouco aos dados preliminares já divulgados pela equipe da sonda em 2007:

Sonda da Gravidade confirma teoria de Einstein

O previsto era que agora, depois de todas as análises e correções dos dados, a precisão das medições dos efeitos da gravidade alcançassem uma margem de erro de 0,01% - mas os cientistas tiveram que se contentar com imprecisões mais de mil vezes maiores.

Fracasso de um épico

Um fim lamentável para um verdadeiro épico científico, um experimento proposto há mais de 60 anos e que, para se tornar realidade, exigiu esforços de pelo menos duas gerações de cientistas.

Depois de décadas de planejamento e construção, quase US$800 milhões de dólares de gastos, e uma tenacidade e um idealismo dignos dos mais sinceros elogios aos coordenadores científicos da missão, os resultados não somam nada ao que já havia sido medido antes, com instrumentos muito mais baratos.

Foram vários os elementos que contribuíram para o que a NASA chamou de "resultado histórico", mas que a comunidade dos físicos preferiu situar entre um "sucesso relativo" e um "desperdício de recursos" - os mais aguerridos chegaram a falar em "fracasso retumbante".

E o principal desses elementos, aquele que mais contribuiu para opiniões tão díspares, foi justamente aquilo de que os projetistas da sonda mais se orgulhavam: as quatro esferas mais perfeitas já construídas pelo homem.

Esferas e giroscópios

As esferas são o elemento principal dos giroscópios da Gravity Probe B.

Tudo começou em 1960, quando o físico Leonard Schiff propôs que a curvatura do espaço-tempo prevista por Einstein poderia ser verificada com a utilização de giroscópios.

Seguindo apenas as Leis de Newton, um giroscópio em órbita da Terra deveria ficar perfeitamente fixo. Mas se, conforme diz Einstein, o espaço-tempo curva-se pela ação de uma força gravitacional, o giroscópio, devido à sua inércia natural, deveria mover-se com ele.

Os cientistas então construíram a Gravity Probe B, não com um, mas com quatro giroscópios. A sonda também possuía um telescópio precisamente apontado para uma estrela-guia, a IM Pegasi.

Se a teoria de Einstein estivesse correta, ao longo de um ano deveria haver uma pequena modificação entre o alinhamento do telescópio e o alinhamento dos giroscópios, uma vez que o eixo de rotação dos giroscópios, girando livremente, seria influenciado tão-somente pela curvatura do espaço-tempo.

Mas os giroscópios não eram tão perfeitos quanto se imaginava.

As esferas, feitas de silício e recobertas de nióbio, eram fisicamente tão perfeitas que, se fossem ampliadas até terem a dimensão da Terra, não haveria em sua superfície nenhuma saliência maior do que 3 metros de altura - cada esfera mede 3,8 centímetros de diâmetro. [Imagem: NASA/Stanford]

Imperfeições esféricas

As esferas, feitas de silício e recobertas de nióbio, eram fisicamente tão perfeitas que, se fossem ampliadas até terem a dimensão da Terra, não haveria em sua superfície nenhuma saliência maior do que 3 metros de altura - cada esfera mede 3,8 centímetros de diâmetro.

Porém, o ajuste das esferas era feito eletricamente. E, provavelmente devido a impurezas no revestimento de nióbio, elas eram esferas eletricamente não tão perfeitas - se ampliadas até o tamanho da Terra, suas variações elétricas superariam facilmente o Monte Everest.

O tempo dirá

Ao ressaltar a importância da missão e dos seus resultados, durante a conferência da NASA que anunciou as conclusões do estudo, Clifford Will, da Universidade de Washington, afirmou: "Este é um resultado épico. Um dia isto será escrito nos livros-texto como um dos experimentos clássicos na história da física."

Ele provavelmente tem razão.

Por outro lado, nos livros de história da física e da exploração espacial - a Gravity Probe B foi o projeto científico mais longo da era espacial - talvez os autores não sejam tão condescendentes.

Sonda da Nasa confirma teoria de Einstein sobre o espaço-tempo

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=einstein-espaco-tempo&id=010130110506&ebol=sim

Apesar da precisão de seus giroscópios, a Gravity Probe B nem se aproximou da precisão que seus projetistas esperavam dela. [Imagem: NASA/Stanford]

Einstein estava certo... de novo. Há um vórtice no espaço-tempo ao redor da Terra, e sua forma corresponde precisamente às previsões da teoria da gravitação de Einstein.

A conclusão é de uma das mais impressionantes sondas espaciais já lançadas, a Gravity Probe B, uma verdadeira maravilha da engenharia.

Imprecisão

Assim posto, tudo parece ser motivo para comemorações.

Infelizmente, não é.

Apesar da precisão de seus giroscópios, a Gravity Probe B nem se aproximou da precisão que seus projetistas esperavam dela.

Na verdade, o anúncio feito pela NASA acrescenta pouco aos dados preliminares já divulgados pela equipe da sonda em 2007:

Sonda da Gravidade confirma teoria de Einstein

O previsto era que agora, depois de todas as análises e correções dos dados, a precisão das medições dos efeitos da gravidade alcançassem uma margem de erro de 0,01% - mas os cientistas tiveram que se contentar com imprecisões mais de mil vezes maiores.

Fracasso de um épico

Um fim lamentável para um verdadeiro épico científico, um experimento proposto há mais de 60 anos e que, para se tornar realidade, exigiu esforços de pelo menos duas gerações de cientistas.

Depois de décadas de planejamento e construção, quase US$800 milhões de dólares de gastos, e uma tenacidade e um idealismo dignos dos mais sinceros elogios aos coordenadores científicos da missão, os resultados não somam nada ao que já havia sido medido antes, com instrumentos muito mais baratos.

Foram vários os elementos que contribuíram para o que a NASA chamou de "resultado histórico", mas que a comunidade dos físicos preferiu situar entre um "sucesso relativo" e um "desperdício de recursos" - os mais aguerridos chegaram a falar em "fracasso retumbante".

E o principal desses elementos, aquele que mais contribuiu para opiniões tão díspares, foi justamente aquilo de que os projetistas da sonda mais se orgulhavam: as quatro esferas mais perfeitas já construídas pelo homem.

Esferas e giroscópios

As esferas são o elemento principal dos giroscópios da Gravity Probe B.

Tudo começou em 1960, quando o físico Leonard Schiff propôs que a curvatura do espaço-tempo prevista por Einstein poderia ser verificada com a utilização de giroscópios.

Seguindo apenas as Leis de Newton, um giroscópio em órbita da Terra deveria ficar perfeitamente fixo. Mas se, conforme diz Einstein, o espaço-tempo curva-se pela ação de uma força gravitacional, o giroscópio, devido à sua inércia natural, deveria mover-se com ele.

Os cientistas então construíram a Gravity Probe B, não com um, mas com quatro giroscópios. A sonda também possuía um telescópio precisamente apontado para uma estrela-guia, a IM Pegasi.

Se a teoria de Einstein estivesse correta, ao longo de um ano deveria haver uma pequena modificação entre o alinhamento do telescópio e o alinhamento dos giroscópios, uma vez que o eixo de rotação dos giroscópios, girando livremente, seria influenciado tão-somente pela curvatura do espaço-tempo.

Mas os giroscópios não eram tão perfeitos quanto se imaginava.

As esferas, feitas de silício e recobertas de nióbio, eram fisicamente tão perfeitas que, se fossem ampliadas até terem a dimensão da Terra, não haveria em sua superfície nenhuma saliência maior do que 3 metros de altura - cada esfera mede 3,8 centímetros de diâmetro. [Imagem: NASA/Stanford]

Imperfeições esféricas

As esferas, feitas de silício e recobertas de nióbio, eram fisicamente tão perfeitas que, se fossem ampliadas até terem a dimensão da Terra, não haveria em sua superfície nenhuma saliência maior do que 3 metros de altura - cada esfera mede 3,8 centímetros de diâmetro.

Porém, o ajuste das esferas era feito eletricamente. E, provavelmente devido a impurezas no revestimento de nióbio, elas eram esferas eletricamente não tão perfeitas - se ampliadas até o tamanho da Terra, suas variações elétricas superariam facilmente o Monte Everest.

O tempo dirá

Ao ressaltar a importância da missão e dos seus resultados, durante a conferência da NASA que anunciou as conclusões do estudo, Clifford Will, da Universidade de Washington, afirmou: "Este é um resultado épico. Um dia isto será escrito nos livros-texto como um dos experimentos clássicos na história da física."

Ele provavelmente tem razão.

Por outro lado, nos livros de história da física e da exploração espacial - a Gravity Probe B foi o projeto científico mais longo da era espacial - talvez os autores não sejam tão condescendentes.

Sonda da Nasa confirma teoria de Einstein sobre o espaço-tempo

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=einstein-espaco-tempo&id=010130110506&ebol=sim

Cortina à prova de som absorve ruídos externos e internos

Redação do Site Inovação Tecnológica - 05/05/2011

Coube à designer de tecidos Annette Douglas a escolha das fibras mais adequadas e da técnica de tecelagem capaz de reproduzir o material simulado no computador. [Imagem: EMPA]

Barulho é irritante. Ele interrompe a comunicação, reduz a produtividade dos funcionários e deixa as pessoas cansadas - em casos extremos, o barulho pode até mesmo deixar as pessoas doentes.

Infelizmente, na maior parte das vezes, a distância entre o ruído incessante e a tranquilidade pode ter a espessura de uma parede, devidamente recoberta com superfícies absorvedoras de ondas acústicas.

Mas deixar o barulho do lado de fora de um ambiente agora pode ser tão simples quanto colocar uma cortina - uma cortina de tecido, flexível como as que já são utilizadas em residências e escritórios, e semi-transparente.

Cortina anti-ruído

Engenheiros do laboratório suíço EMPA desenvolveram um novo tecido que é leve, fino e flexível e, mais importante, um absorvedor de som excepcional.

"Os engenheiros de som ficaram atônitos quando viram as leituras que obtivemos com a nova cortina na sala de reverberação. O coeficiente de absorção sonora ficou entre 0,5 e 0,6," conta Kurt Eggenschwiler, chefe da equipe que desenvolveu a cortina à prova de som.

Em outras palavras, a cortina "absorve" cinco vezes mais som do que as barreiras convencionais. "A nova cortina genuinamente absorve som, melhorando notavelmente a acústica da sala - e seu design é de muito alta qualidade," completa Eggenschwiler.

Outra vantagem é que a cortina é translúcida, o que permite seu uso em uma grande variedade de ambientes, de escritórios e auditórios a salas de visita residenciais.

A cortina à prova de som retém os ruídos externos e diminui a reverberação interna, deixando o ambiente mais silencioso e tranquilo. [Imagem: EMPA]

Do computador ao tecido

A cortina anti-ruído veio ao mundo inicialmente em um computador, projetado na forma de um tecido ideal, com uma estrutura capaz de absorver o som.

A seguir, essa receita - um modelo matemático que descreve a estrutura microscópica do material - teve que ser "traduzida" para que o material pudesse ser fabricado na forma de um tecido.

O processo de fabricação teve que ser aprimorado, seguindo-se uma bateria de testes em cada geração de amostra fabricada.

Coube à designer de tecidos Annette Douglas, que foi quem procurou os pesquisadores com a ideia de uma cortina à prova de som, a escolha das fibras mais adequadas e da técnica de tecelagem capaz de reproduzir o material simulado no computador.

A designer também escolheu os elementos necessários para que a cortina tivesse as características anti-chama e translucência, que permitirão seu uso mais disseminado.

fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=cortina-prova-som&id=010160110505&ebol=sim

Coube à designer de tecidos Annette Douglas a escolha das fibras mais adequadas e da técnica de tecelagem capaz de reproduzir o material simulado no computador. [Imagem: EMPA]

Barulho é irritante. Ele interrompe a comunicação, reduz a produtividade dos funcionários e deixa as pessoas cansadas - em casos extremos, o barulho pode até mesmo deixar as pessoas doentes.

Infelizmente, na maior parte das vezes, a distância entre o ruído incessante e a tranquilidade pode ter a espessura de uma parede, devidamente recoberta com superfícies absorvedoras de ondas acústicas.

Mas deixar o barulho do lado de fora de um ambiente agora pode ser tão simples quanto colocar uma cortina - uma cortina de tecido, flexível como as que já são utilizadas em residências e escritórios, e semi-transparente.

Cortina anti-ruído

Engenheiros do laboratório suíço EMPA desenvolveram um novo tecido que é leve, fino e flexível e, mais importante, um absorvedor de som excepcional.

"Os engenheiros de som ficaram atônitos quando viram as leituras que obtivemos com a nova cortina na sala de reverberação. O coeficiente de absorção sonora ficou entre 0,5 e 0,6," conta Kurt Eggenschwiler, chefe da equipe que desenvolveu a cortina à prova de som.

Em outras palavras, a cortina "absorve" cinco vezes mais som do que as barreiras convencionais. "A nova cortina genuinamente absorve som, melhorando notavelmente a acústica da sala - e seu design é de muito alta qualidade," completa Eggenschwiler.

Outra vantagem é que a cortina é translúcida, o que permite seu uso em uma grande variedade de ambientes, de escritórios e auditórios a salas de visita residenciais.

A cortina à prova de som retém os ruídos externos e diminui a reverberação interna, deixando o ambiente mais silencioso e tranquilo. [Imagem: EMPA]

Do computador ao tecido

A cortina anti-ruído veio ao mundo inicialmente em um computador, projetado na forma de um tecido ideal, com uma estrutura capaz de absorver o som.

A seguir, essa receita - um modelo matemático que descreve a estrutura microscópica do material - teve que ser "traduzida" para que o material pudesse ser fabricado na forma de um tecido.

O processo de fabricação teve que ser aprimorado, seguindo-se uma bateria de testes em cada geração de amostra fabricada.

Coube à designer de tecidos Annette Douglas, que foi quem procurou os pesquisadores com a ideia de uma cortina à prova de som, a escolha das fibras mais adequadas e da técnica de tecelagem capaz de reproduzir o material simulado no computador.

A designer também escolheu os elementos necessários para que a cortina tivesse as características anti-chama e translucência, que permitirão seu uso mais disseminado.

fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=cortina-prova-som&id=010160110505&ebol=sim

Papel eletrônico: futuro dos computadores flexíveis?

Redação do Site Inovação Tecnológica - 06/05/2011

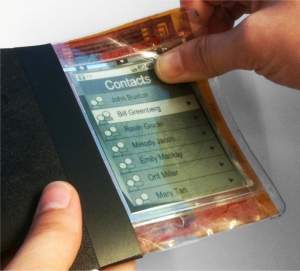

O que o pesquisador chama de um "iPhone flexível" é mais um protótipo que demonstra um conceito de interface, que poderia ser chamado de "navegação por dobradura".[Imagem: University of Queens]

"Isto representa o futuro. Tudo será como ele dentro de cinco a 10 anos," entusiasma-se Roel Vertegaal, ao falar da sua criação, que ele batizou de PaperPhone.

Computador flexível

A tecnologia é mais comumente chamada de papel eletrônico, mas Vertegall e seus colegas da Universidade Queens, na Grã-Bretanha, utilizaram-no para construir um pequeno computador, com funções semelhantes à de um smartphone.

O pesquisador, que apresentará sua invenção durante a conferência Computer Human Interaction, em Vancouver, no Canadá, no próximo dia 10 de Maio, afirma que o protótipo, o PaperPhone, é melhor descrito como um iPhone flexível.

"Este computador se parece, se comporta e é operado como uma pequena folha de papel interativo. Você interage com ele dobrando-o na forma de um telefone celular, inclinando seus cantos para virar as páginas, ou escrevendo sobre ele com uma caneta," diz o pesquisador.

Telas flexíveis

A tela, de 9,5 centímetros na diagonal - 4 polegadas -, é fruto da chamada eletrônica orgânica, feita com a tecnologia de filme fino.

As primeiras telas flexíveis e de enrolar chegaram ao mercado em 2007.

Snaplet - Você concorda que este aparelho se parece com um relógio de pulso? [Imagem: University of Queens]

Por outro lado, embora os primeiros circuitos integrados flexíveis já estejam em testes de laboratório, eles ainda não são capazes de sustentar todo o funcionamento de um computador, ou mesmo de um smartphone.

Assim, o que o pesquisador chama de um "iPhone flexível" é mais um protótipo que demonstra um conceito de interface, que poderia ser chamado de "navegação por dobradura", em lugar das muito mais confortáveis e responsivas telas sensíveis do toque - as opções são acionados dobrando-se a tela inteira para baixo ou para cima.

Um conceito interessante, que sofre das dificuldades próprias dos protótipos - o circuito ainda não é tão flexível quanto se poderia esperar. Além disso, o aparelho está mais para um computador rígido com uma tela semi-flexível anexa.

Durante a apresentação, está programada também a demonstração de um "computador semelhante a um relógio de pulso", segundo Vertegaal, chamado Snaplet.

fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=papel-eletronico-futuro-computadores-flexiveis&id=010150110506&ebol=sim

O que o pesquisador chama de um "iPhone flexível" é mais um protótipo que demonstra um conceito de interface, que poderia ser chamado de "navegação por dobradura".[Imagem: University of Queens]

"Isto representa o futuro. Tudo será como ele dentro de cinco a 10 anos," entusiasma-se Roel Vertegaal, ao falar da sua criação, que ele batizou de PaperPhone.

Computador flexível

A tecnologia é mais comumente chamada de papel eletrônico, mas Vertegall e seus colegas da Universidade Queens, na Grã-Bretanha, utilizaram-no para construir um pequeno computador, com funções semelhantes à de um smartphone.

O pesquisador, que apresentará sua invenção durante a conferência Computer Human Interaction, em Vancouver, no Canadá, no próximo dia 10 de Maio, afirma que o protótipo, o PaperPhone, é melhor descrito como um iPhone flexível.

"Este computador se parece, se comporta e é operado como uma pequena folha de papel interativo. Você interage com ele dobrando-o na forma de um telefone celular, inclinando seus cantos para virar as páginas, ou escrevendo sobre ele com uma caneta," diz o pesquisador.

Telas flexíveis

A tela, de 9,5 centímetros na diagonal - 4 polegadas -, é fruto da chamada eletrônica orgânica, feita com a tecnologia de filme fino.

As primeiras telas flexíveis e de enrolar chegaram ao mercado em 2007.

Snaplet - Você concorda que este aparelho se parece com um relógio de pulso? [Imagem: University of Queens]

Por outro lado, embora os primeiros circuitos integrados flexíveis já estejam em testes de laboratório, eles ainda não são capazes de sustentar todo o funcionamento de um computador, ou mesmo de um smartphone.

Assim, o que o pesquisador chama de um "iPhone flexível" é mais um protótipo que demonstra um conceito de interface, que poderia ser chamado de "navegação por dobradura", em lugar das muito mais confortáveis e responsivas telas sensíveis do toque - as opções são acionados dobrando-se a tela inteira para baixo ou para cima.

Um conceito interessante, que sofre das dificuldades próprias dos protótipos - o circuito ainda não é tão flexível quanto se poderia esperar. Além disso, o aparelho está mais para um computador rígido com uma tela semi-flexível anexa.

Durante a apresentação, está programada também a demonstração de um "computador semelhante a um relógio de pulso", segundo Vertegaal, chamado Snaplet.

fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=papel-eletronico-futuro-computadores-flexiveis&id=010150110506&ebol=sim

Memória atômica: fóton grava e lê dados em um único átomo

Olivia Meyer-Streng - 04/05/2011

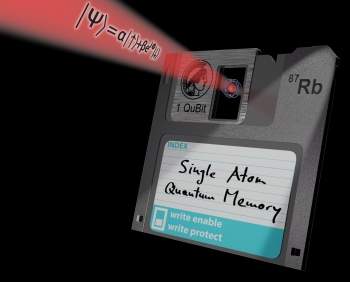

Estes dispositivos são requisitos fundamentais para o processamento de informações em um computador quântico e para a implementação de comunicações quânticas de longa distância. [Imagem: Andreas Neuzner]

Rede quântica universal

Cientistas austríacos alcançaram um feito inédito, ao transferir a informação codificada de um único fóton para um único átomo.

No átomo, a informação foi armazenada durante algum tempo e recuperada mais tarde.

"Isso nos dá um nó de uma rede quântica universal", comemora o Dr. Gerhard Rempe, do Instituto Max-Planck de Óptica Quântica, coordenador do trabalho.

O experimento abre novas perspectivas para o desenvolvimento de redes quânticas escaláveis, nas quais os fótons comunicam informação quântica entre vários nós, a longas distâncias.

Memória quântica

Em uma série de medições usando diferentes estados de polarização na entrada, a fidelidade entre os fótons originais e os fótons lidos mostrou-se superior a 90 por cento em todos os casos.

"A fidelidade com o fóton de entrada que nós conseguimos com o nosso novo método é muito melhor do que aquilo que seria possível com qualquer tipo de dispositivo de medição clássica," afirma Christian Nölleke, coautor do trabalho.

Considerando a eficiência de armazenamento e a fidelidade alcançadas, o sistema é comparável às melhores memórias quânticas já construídas, com a diferença que o seu "hardware" consiste em apenas um único átomo.

Ao mesmo tempo, a memória atômica oferece tempos de armazenamento de cerca de 200 microssegundos, o que ultrapassa todos os valores obtidos com memórias ópticas até o momento.

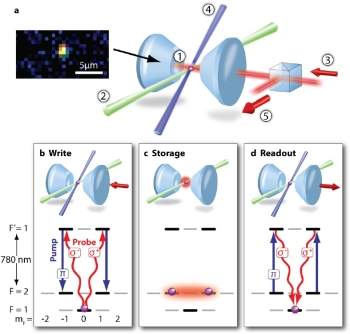

Esquema mostra o uso de um lasers para aprisionar o átomo-memória e de outro laser de controle para gravar e ler as informações. [Imagem: Specht et al./Nature]

Memória atômica

A miniaturização contínua dos componentes usados para armazenar informações no interior dos chips alcançou um limite a partir de onde as leis da física clássica não podem mais ser aplicadas.

Em vez disso, os sistemas são regidos pelas leis da mecânica quântica.

Neste limite físico, o menor dispositivo de armazenamento possível consiste de um único átomo, enquanto a menor unidade possível para a transferência de dados óptica é um único fóton.

As propriedades especiais dessas partículas quânticas podem então ser usadas para desenvolver novas aplicações, por exemplo, dispositivos de criptografia quântica ou portas lógicas para processar a informação quântica, atingindo velocidades inimagináveis.

A implementação dessas novas tecnologias requer novos conceitos de transferência e armazenamento de informações.

E o candidato mais promissor é a implementação de uma rede de memórias quânticas distribuídas comunicando-se umas com as outras através da troca de fótons.

Informação da luz para a matéria

Este desenvolvimento exige dois elementos principais.

O primeiro, a transferência da informação quântica armazenada em um nó de memória para um único fóton, já foi demonstrado pela mesma equipe, com a implementação de um emissor de fótons individuais baseado em um único átomo.

O segundo, escrever um qubit fotônico em uma outra memória quântica estacionária, e ler esse qubit novamente, sem distorção significativa, tem sido realizado até agora somente através de experiências com conjuntos formados por milhares de partículas, com a informação sendo mapeada em uma excitação atômica compartilhada pelo conjunto de átomos.

Memória óptica armazena e recupera pulsos de luz individuais

A fim de tirar vantagem integral das oportunidades oferecidas pela mecânica quântica, criando implementações práticas - por exemplo, em computadores quânticos - seria muito melhor trocar informações entre as partículas individuais de luz e de matéria - fótons e átomos - que possam ser dirigidas e manipuladas diretamente.

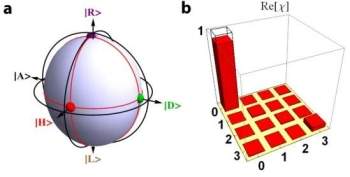

O processo de armazenamento no átomo pode ser descrito como uma deformação (esfera azulada) da esfera de Poincaré (círculos pretos). Os pontos coloridos indicam as polarizações dos estados de entrada sobre os eixos depois da gravação. [Imagem: Specht et al./Nature]

Gravação na memória atômica

No experimento agora realizado, um único átomo de rubídio foi utilizado pela primeira vez como uma memória quântica.

A fim de aumentar seu fraco acoplamento a um único fóton, o átomo é aprisionado dentro de um ressonador óptico, formado por dois espelhos altamente refletores.

Lá, o átomo é mantido no lugar com a luz de um laser, enquanto o fóton que entra é refletido entre os dois espelhos cerca de 20.000 vezes.

Agora, a informação quântica armazenada no fóton precisa ser escrita no átomo.

"Enquanto um bit clássico sempre representa inequivocamente um dentre dois valores possíveis - 0 ou 1 -, um bit quântico é a superposição coerente de dois estados quânticos," explica o Dr. Holger Specht, coautor da pesquisa. "Assim, nós codificamos a informação usando uma superposição coerente de dois estados de polarização do fóton, por exemplo, uma polarização à direita e outra à esquerda."

A transferência da informação óptica quântica é garantida por um laser de controle: quando tanto o qubit fotônico quanto o laser de controle estão presentes, o átomo faz uma transição para um estado que é - e é aí que está o truque - uma superposição coerente de dois sub-estados.

As quantidades relativas dos dois sub-estados correspondem aos respectivos valores dos dois estados de polarização do fóton de entrada.

Leitura da memória atômica

Depois de um tempo variável de armazenamento, a leitura da informação quântica é iniciada, um trabalho também executado pelo laser de controle.

Agora, todo o processo se inverte e o qubit fotônico é liberado, com uma eficiência média de cerca de 10 por cento.

"Ainda há espaço para melhorar os tempos de fidelidade e de armazenamento por meio da otimização das condições experimentais," explica o Dr. Stephan Ritter.

A seguir, os cientistas planejam usar o sistema para demonstrar uma rede quântica básica, formada por dois nós de comunicação.

Devido às suas propriedades universais, a memória quântica agora demonstrada é um marco para o desenvolvimento de portas lógicas ópticas e repetidores quânticos.

Estes dispositivos são requisitos fundamentais para o processamento de informações em um computador quântico e para a implementação de comunicações quânticas de longa distância.

Bibliografia:

A Single-Atom Quantum Memory

Holger P. Specht, Christian Nölleke, Andreas Reiserer, Manuel Uphoff, Eden Figueroa, Stephan Ritter, Gerhard Rempe

Nature

May 2011

Vol.: Advance Online Publication

DOI: 10.1038/nature09997

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=memoria-atomica&id=020110110504&ebol=sim

Estes dispositivos são requisitos fundamentais para o processamento de informações em um computador quântico e para a implementação de comunicações quânticas de longa distância. [Imagem: Andreas Neuzner]

Rede quântica universal

Cientistas austríacos alcançaram um feito inédito, ao transferir a informação codificada de um único fóton para um único átomo.

No átomo, a informação foi armazenada durante algum tempo e recuperada mais tarde.

"Isso nos dá um nó de uma rede quântica universal", comemora o Dr. Gerhard Rempe, do Instituto Max-Planck de Óptica Quântica, coordenador do trabalho.

O experimento abre novas perspectivas para o desenvolvimento de redes quânticas escaláveis, nas quais os fótons comunicam informação quântica entre vários nós, a longas distâncias.

Memória quântica

Em uma série de medições usando diferentes estados de polarização na entrada, a fidelidade entre os fótons originais e os fótons lidos mostrou-se superior a 90 por cento em todos os casos.

"A fidelidade com o fóton de entrada que nós conseguimos com o nosso novo método é muito melhor do que aquilo que seria possível com qualquer tipo de dispositivo de medição clássica," afirma Christian Nölleke, coautor do trabalho.

Considerando a eficiência de armazenamento e a fidelidade alcançadas, o sistema é comparável às melhores memórias quânticas já construídas, com a diferença que o seu "hardware" consiste em apenas um único átomo.

Ao mesmo tempo, a memória atômica oferece tempos de armazenamento de cerca de 200 microssegundos, o que ultrapassa todos os valores obtidos com memórias ópticas até o momento.

Esquema mostra o uso de um lasers para aprisionar o átomo-memória e de outro laser de controle para gravar e ler as informações. [Imagem: Specht et al./Nature]

Memória atômica

A miniaturização contínua dos componentes usados para armazenar informações no interior dos chips alcançou um limite a partir de onde as leis da física clássica não podem mais ser aplicadas.

Em vez disso, os sistemas são regidos pelas leis da mecânica quântica.

Neste limite físico, o menor dispositivo de armazenamento possível consiste de um único átomo, enquanto a menor unidade possível para a transferência de dados óptica é um único fóton.

As propriedades especiais dessas partículas quânticas podem então ser usadas para desenvolver novas aplicações, por exemplo, dispositivos de criptografia quântica ou portas lógicas para processar a informação quântica, atingindo velocidades inimagináveis.

A implementação dessas novas tecnologias requer novos conceitos de transferência e armazenamento de informações.

E o candidato mais promissor é a implementação de uma rede de memórias quânticas distribuídas comunicando-se umas com as outras através da troca de fótons.

Informação da luz para a matéria

Este desenvolvimento exige dois elementos principais.

O primeiro, a transferência da informação quântica armazenada em um nó de memória para um único fóton, já foi demonstrado pela mesma equipe, com a implementação de um emissor de fótons individuais baseado em um único átomo.

O segundo, escrever um qubit fotônico em uma outra memória quântica estacionária, e ler esse qubit novamente, sem distorção significativa, tem sido realizado até agora somente através de experiências com conjuntos formados por milhares de partículas, com a informação sendo mapeada em uma excitação atômica compartilhada pelo conjunto de átomos.

Memória óptica armazena e recupera pulsos de luz individuais

A fim de tirar vantagem integral das oportunidades oferecidas pela mecânica quântica, criando implementações práticas - por exemplo, em computadores quânticos - seria muito melhor trocar informações entre as partículas individuais de luz e de matéria - fótons e átomos - que possam ser dirigidas e manipuladas diretamente.

O processo de armazenamento no átomo pode ser descrito como uma deformação (esfera azulada) da esfera de Poincaré (círculos pretos). Os pontos coloridos indicam as polarizações dos estados de entrada sobre os eixos depois da gravação. [Imagem: Specht et al./Nature]

Gravação na memória atômica

No experimento agora realizado, um único átomo de rubídio foi utilizado pela primeira vez como uma memória quântica.

A fim de aumentar seu fraco acoplamento a um único fóton, o átomo é aprisionado dentro de um ressonador óptico, formado por dois espelhos altamente refletores.

Lá, o átomo é mantido no lugar com a luz de um laser, enquanto o fóton que entra é refletido entre os dois espelhos cerca de 20.000 vezes.

Agora, a informação quântica armazenada no fóton precisa ser escrita no átomo.

"Enquanto um bit clássico sempre representa inequivocamente um dentre dois valores possíveis - 0 ou 1 -, um bit quântico é a superposição coerente de dois estados quânticos," explica o Dr. Holger Specht, coautor da pesquisa. "Assim, nós codificamos a informação usando uma superposição coerente de dois estados de polarização do fóton, por exemplo, uma polarização à direita e outra à esquerda."

A transferência da informação óptica quântica é garantida por um laser de controle: quando tanto o qubit fotônico quanto o laser de controle estão presentes, o átomo faz uma transição para um estado que é - e é aí que está o truque - uma superposição coerente de dois sub-estados.

As quantidades relativas dos dois sub-estados correspondem aos respectivos valores dos dois estados de polarização do fóton de entrada.

Leitura da memória atômica

Depois de um tempo variável de armazenamento, a leitura da informação quântica é iniciada, um trabalho também executado pelo laser de controle.

Agora, todo o processo se inverte e o qubit fotônico é liberado, com uma eficiência média de cerca de 10 por cento.

"Ainda há espaço para melhorar os tempos de fidelidade e de armazenamento por meio da otimização das condições experimentais," explica o Dr. Stephan Ritter.

A seguir, os cientistas planejam usar o sistema para demonstrar uma rede quântica básica, formada por dois nós de comunicação.

Devido às suas propriedades universais, a memória quântica agora demonstrada é um marco para o desenvolvimento de portas lógicas ópticas e repetidores quânticos.

Estes dispositivos são requisitos fundamentais para o processamento de informações em um computador quântico e para a implementação de comunicações quânticas de longa distância.

Bibliografia:

A Single-Atom Quantum Memory

Holger P. Specht, Christian Nölleke, Andreas Reiserer, Manuel Uphoff, Eden Figueroa, Stephan Ritter, Gerhard Rempe

Nature

May 2011

Vol.: Advance Online Publication

DOI: 10.1038/nature09997

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=memoria-atomica&id=020110110504&ebol=sim

Código genético do DNA é descrito matematicamente por brasileiros

Com informações do Jornal da Unicamp - 04/05/2011

A descoberta da estrutura matemática do DNA, além de referendar os fatos descritos pela biologia, é altamente promissora para o entendimento de anomalias observadas nos sistemas celulares e mesmo para possibilitar previsões de novas descobertas ainda não observadas em laboratório.[Imagem: Yikrazuul/Wikimedia]

Descrição matemática do DNA

Cientistas brasileiros descobriram que as sequências das moléculas de DNA podem ser reproduzidas através de estruturas matemáticas.

A descrição matemática da estrutura genética deverá ampliar consideravelmente a capacidade de compreensão do funcionamento dos sistemas biológicos - e, eventualmente, as possibilidades de sua manipulação.

Na física e na química, o uso de equações matemáticas para explicar, quantificar e prever a possibilidade de ocorrência de transformações naturais ou provocadas se tornou rotineiro.

Na biologia, porém, esse recurso é bem mais recente e ainda muito restrito. Vários pesquisadores das áreas de teoria e codificação da informação, principalmente nos EUA e da Europa, vinham tentando reproduzir as sequências de DNA através de estruturas matemáticas.

A primazia do feito, contudo, coube a um grupo de pesquisadores da Universidade Estadual de Campinas (Unicamp) e da Universidade de São Paulo (USP).

Código de correção de erros

Os cientistas brasileiros estabeleceram uma relação matemática entre um código numérico e a sequência do DNA, o ácido desoxirribonucléico, portador dos genes dentro das células.

O código numérico é similar ao usado para correção de erros em programas de computador.

De forma geral, os códigos de correção de erros estão presentes na comunicação via satélite, nas comunicações internas de um computador e no armazenamento de dados - portanto, fazem parte do cotidiano de todos que usam a internet, celulares, TVs, CDs, pen-drives etc.

A utilização destes códigos tem como objetivo a correção de erros que ocorrem durante a transmissão ou o armazenamento da informação.

A associação dos códigos corretores de erros com sequências de DNA constitui objeto de pesquisa desde os anos 80.

O grupo brasileiro estabeleceu essa relação com diferentes sequências de DNA que constituem o genoma (exons, íntrons, DNA repetitivo, sequência de direcionamento, proteínas, hormônios, gene, etc) até chegarem na reprodução do genoma completo de um plasmídeo.

DNA mitocondrial

As mitocôndrias, organelas responsáveis pela respiração celular, apesar de conterem o seu próprio DNA e toda maquinaria necessária para fabricar proteínas, sintetizam somente um pequeno número dessas proteínas.

A grande maioria das proteínas mitocondriais é codificada por genes que ficam no núcleo das células, sintetizadas no citosol e posteriormente enviadas para as mitocôndrias.

Neste caso, a proteína é considerada como a informação que será enviada para a organela, existindo um código padrão para transmiti-la.

Durante o estudo, os pesquisadores brasileiros mostraram que o modelo que empregaram se ajusta a diferentes sequências de DNA.

Essa modelagem, além de referendar os fatos descritos pela biologia, mostra-se altamente promissora para o entendimento de anomalias observadas nos sistemas celulares e mesmo para possibilitar previsões de novas descobertas ainda não observadas em laboratório.

A modelagem matemática do código genético do DNA pode possibilitar a descoberta de curas de doenças de forma mais rápida do que é possível hoje. [Imagem: Bbkkk/Wikimedia]

Grupo interdisciplinar

A complexidade do assunto, e a interface com outras áreas do conhecimento, exigiu a formação de um grupo interdisciplinar para levar a pesquisa adiante.

A possibilidade de utilização de um código matemático que transcrevesse a sequência de DNA foi proposta pelo professor Reginaldo Palazzo Júnior, da Unicamp, a duas de suas alunas de doutorado: Andréa Santos Leite da Rocha e Luzinete Cristina Bonani de Faria, ambas graduadas em matemática pela PUC-Campinas.

Elas se propuseram inicialmente a estudar o transporte das proteínas mitocondriais.

O grupo interdisciplinar se consolidou com a colaboração do professor Márcio de Castro Silva Filho, geneticista especializado em transporte de proteínas, da Escola Superior de Agronomia Luiz de Queiroz (Esalq) da USP, e do engenheiro de computação João Henrique Kleinschmidt, professor da Universidade Federal do ABC, em Santo André.

Reginaldo Palazzo, ele próprio vindo da engenharia elétrica, é especialista na chamada teoria matemática da comunicação, área de estudo da transmissão de todo o tipo de informação e de seus códigos.

Código genético matemático

Iniciou-se então a abordagem para descrever uma estrutura matemática nas sequências de DNA.

A modelagem matemática que se mostrou adequada foi aplicada tanto em sequências de DNA de fungos, vírus, plantas, bactérias e humanos, quanto no gene "TRAV7" do Homo sapiens e no genoma do plasmídeo (DNA extra-cromossomais) da bactéria Lactococcus lactis, verificando que a maioria destas sequências foi geradas por um código matemático.

O feito dos pesquisadores brasileiros apresenta uma solução importante e inovadora para a biologia, permitindo que os fenômenos possam passar a ser analisados por métodos quantitativos.

Palazzo considera que essa nova fase exigirá maior diálogo entre biólogos, matemáticos e engenheiros eletrônicos e afirma estar plenamente convencido de que a teoria da informação constitui uma ferramenta adequada para o intercâmbio com a biologia molecular.

Ele reconhece que essa interdisciplinaridade ainda está distante, embora a seu ver o grupo tenha dado um grande passo inicial.

Resultados concretos

A linha de pesquisa orientada por Palazzo desenvolve programas computacionais para a geração, classificação e análise mutacional e de polimorfismos em sequências de DNA.

A pesquisa abre a possibilidade, a partir de um código e de uma solução matemática, de corrigir uma mutação ou um erro celular, de produzir proteínas desejadas e também de encontrar proteínas ainda desconhecidas existentes nas células.

Em decorrência, o método pode ser aplicado em projetos e pesquisas com a finalidade de criar novas funções para determinada sequência de DNA através de mutações segundo as necessidades comerciais e científicas, afirmam Andréa e Luzinete.

Essa modelagem matemática, afirma o professor Palazzo, que permite caracterizar um sistema biológico, pode possibilitar, através de um programa computacional, a realização de análises que levem a resultados concretos.

Hoje, a pesquisa na área da saúde é, em geral, demorada e dispendiosa. E, mesmo assim, não raro, depois de um longo tempo, não se conseguem resultados positivos.

Com a utilização de um software, a caracterização e a simulação do que se pretende pode ser realizada previamente no computador.

As previsões teóricas poderão ser testadas em laboratório de uma forma sistemática e eficaz, tornando os resultados muito mais confiáveis. A modelagem matemática pode possibilitar a cura de uma doença de forma mais rápida, segundo o pesquisador.

Biologia matemática

Para o professor, a teoria se mostrou válida para certos fatos concretos, mas admite que ainda há muito a ser feito.

Ele considera que a linha adotada está sendo delineada e lembra que alguns pesquisadores chegam a afirmar que não existe uma estrutura matemática que possa ser associada a sequências de DNA. "Nós estamos mostrando que existe", afirma o docente.

Ele insiste que o processo adotado efetivamente inova na modelagem em relação aos trabalhos propostos anteriormente e revela-se bastante coerente e consistente com o modelo biológico vigente.

Os pesquisadores consideram que, por tratar-se de uma proposta nova, que se insere numa área estratégica de pesquisa e de inovação tecnológica e, mais, que a detenção do conhecimento necessário se resume a poucos pesquisadores, é imprescindível que esforços sejam despendidos na formação de recursos humanos para o estabelecimento de uma massa crítica de especialistas na área.

Para isso, consideram fundamental o respaldo institucional quanto ao reconhecimento da relevância em prover uma infraestrutura de pesquisa bem como no estabelecimento de um programa de pós-graduação na área.

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=codigo-genetico-dna-descrito-matematicamente&id=010150110504&ebol=sim

A descoberta da estrutura matemática do DNA, além de referendar os fatos descritos pela biologia, é altamente promissora para o entendimento de anomalias observadas nos sistemas celulares e mesmo para possibilitar previsões de novas descobertas ainda não observadas em laboratório.[Imagem: Yikrazuul/Wikimedia]

Descrição matemática do DNA

Cientistas brasileiros descobriram que as sequências das moléculas de DNA podem ser reproduzidas através de estruturas matemáticas.

A descrição matemática da estrutura genética deverá ampliar consideravelmente a capacidade de compreensão do funcionamento dos sistemas biológicos - e, eventualmente, as possibilidades de sua manipulação.

Na física e na química, o uso de equações matemáticas para explicar, quantificar e prever a possibilidade de ocorrência de transformações naturais ou provocadas se tornou rotineiro.

Na biologia, porém, esse recurso é bem mais recente e ainda muito restrito. Vários pesquisadores das áreas de teoria e codificação da informação, principalmente nos EUA e da Europa, vinham tentando reproduzir as sequências de DNA através de estruturas matemáticas.

A primazia do feito, contudo, coube a um grupo de pesquisadores da Universidade Estadual de Campinas (Unicamp) e da Universidade de São Paulo (USP).

Código de correção de erros

Os cientistas brasileiros estabeleceram uma relação matemática entre um código numérico e a sequência do DNA, o ácido desoxirribonucléico, portador dos genes dentro das células.

O código numérico é similar ao usado para correção de erros em programas de computador.

De forma geral, os códigos de correção de erros estão presentes na comunicação via satélite, nas comunicações internas de um computador e no armazenamento de dados - portanto, fazem parte do cotidiano de todos que usam a internet, celulares, TVs, CDs, pen-drives etc.

A utilização destes códigos tem como objetivo a correção de erros que ocorrem durante a transmissão ou o armazenamento da informação.

A associação dos códigos corretores de erros com sequências de DNA constitui objeto de pesquisa desde os anos 80.

O grupo brasileiro estabeleceu essa relação com diferentes sequências de DNA que constituem o genoma (exons, íntrons, DNA repetitivo, sequência de direcionamento, proteínas, hormônios, gene, etc) até chegarem na reprodução do genoma completo de um plasmídeo.

DNA mitocondrial

As mitocôndrias, organelas responsáveis pela respiração celular, apesar de conterem o seu próprio DNA e toda maquinaria necessária para fabricar proteínas, sintetizam somente um pequeno número dessas proteínas.

A grande maioria das proteínas mitocondriais é codificada por genes que ficam no núcleo das células, sintetizadas no citosol e posteriormente enviadas para as mitocôndrias.

Neste caso, a proteína é considerada como a informação que será enviada para a organela, existindo um código padrão para transmiti-la.

Durante o estudo, os pesquisadores brasileiros mostraram que o modelo que empregaram se ajusta a diferentes sequências de DNA.

Essa modelagem, além de referendar os fatos descritos pela biologia, mostra-se altamente promissora para o entendimento de anomalias observadas nos sistemas celulares e mesmo para possibilitar previsões de novas descobertas ainda não observadas em laboratório.

A modelagem matemática do código genético do DNA pode possibilitar a descoberta de curas de doenças de forma mais rápida do que é possível hoje. [Imagem: Bbkkk/Wikimedia]

Grupo interdisciplinar

A complexidade do assunto, e a interface com outras áreas do conhecimento, exigiu a formação de um grupo interdisciplinar para levar a pesquisa adiante.

A possibilidade de utilização de um código matemático que transcrevesse a sequência de DNA foi proposta pelo professor Reginaldo Palazzo Júnior, da Unicamp, a duas de suas alunas de doutorado: Andréa Santos Leite da Rocha e Luzinete Cristina Bonani de Faria, ambas graduadas em matemática pela PUC-Campinas.

Elas se propuseram inicialmente a estudar o transporte das proteínas mitocondriais.

O grupo interdisciplinar se consolidou com a colaboração do professor Márcio de Castro Silva Filho, geneticista especializado em transporte de proteínas, da Escola Superior de Agronomia Luiz de Queiroz (Esalq) da USP, e do engenheiro de computação João Henrique Kleinschmidt, professor da Universidade Federal do ABC, em Santo André.

Reginaldo Palazzo, ele próprio vindo da engenharia elétrica, é especialista na chamada teoria matemática da comunicação, área de estudo da transmissão de todo o tipo de informação e de seus códigos.

Código genético matemático

Iniciou-se então a abordagem para descrever uma estrutura matemática nas sequências de DNA.

A modelagem matemática que se mostrou adequada foi aplicada tanto em sequências de DNA de fungos, vírus, plantas, bactérias e humanos, quanto no gene "TRAV7" do Homo sapiens e no genoma do plasmídeo (DNA extra-cromossomais) da bactéria Lactococcus lactis, verificando que a maioria destas sequências foi geradas por um código matemático.

O feito dos pesquisadores brasileiros apresenta uma solução importante e inovadora para a biologia, permitindo que os fenômenos possam passar a ser analisados por métodos quantitativos.

Palazzo considera que essa nova fase exigirá maior diálogo entre biólogos, matemáticos e engenheiros eletrônicos e afirma estar plenamente convencido de que a teoria da informação constitui uma ferramenta adequada para o intercâmbio com a biologia molecular.

Ele reconhece que essa interdisciplinaridade ainda está distante, embora a seu ver o grupo tenha dado um grande passo inicial.

Resultados concretos

A linha de pesquisa orientada por Palazzo desenvolve programas computacionais para a geração, classificação e análise mutacional e de polimorfismos em sequências de DNA.

A pesquisa abre a possibilidade, a partir de um código e de uma solução matemática, de corrigir uma mutação ou um erro celular, de produzir proteínas desejadas e também de encontrar proteínas ainda desconhecidas existentes nas células.

Em decorrência, o método pode ser aplicado em projetos e pesquisas com a finalidade de criar novas funções para determinada sequência de DNA através de mutações segundo as necessidades comerciais e científicas, afirmam Andréa e Luzinete.

Essa modelagem matemática, afirma o professor Palazzo, que permite caracterizar um sistema biológico, pode possibilitar, através de um programa computacional, a realização de análises que levem a resultados concretos.

Hoje, a pesquisa na área da saúde é, em geral, demorada e dispendiosa. E, mesmo assim, não raro, depois de um longo tempo, não se conseguem resultados positivos.

Com a utilização de um software, a caracterização e a simulação do que se pretende pode ser realizada previamente no computador.

As previsões teóricas poderão ser testadas em laboratório de uma forma sistemática e eficaz, tornando os resultados muito mais confiáveis. A modelagem matemática pode possibilitar a cura de uma doença de forma mais rápida, segundo o pesquisador.

Biologia matemática

Para o professor, a teoria se mostrou válida para certos fatos concretos, mas admite que ainda há muito a ser feito.

Ele considera que a linha adotada está sendo delineada e lembra que alguns pesquisadores chegam a afirmar que não existe uma estrutura matemática que possa ser associada a sequências de DNA. "Nós estamos mostrando que existe", afirma o docente.

Ele insiste que o processo adotado efetivamente inova na modelagem em relação aos trabalhos propostos anteriormente e revela-se bastante coerente e consistente com o modelo biológico vigente.

Os pesquisadores consideram que, por tratar-se de uma proposta nova, que se insere numa área estratégica de pesquisa e de inovação tecnológica e, mais, que a detenção do conhecimento necessário se resume a poucos pesquisadores, é imprescindível que esforços sejam despendidos na formação de recursos humanos para o estabelecimento de uma massa crítica de especialistas na área.

Para isso, consideram fundamental o respaldo institucional quanto ao reconhecimento da relevância em prover uma infraestrutura de pesquisa bem como no estabelecimento de um programa de pós-graduação na área.

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=codigo-genetico-dna-descrito-matematicamente&id=010150110504&ebol=sim

quinta-feira, 5 de maio de 2011

Aprenda a criar senhas fortes e proteja suas contas dos cibercriminosos

Por PC World/US

Publicada em 05 de maio de 2011 às 09h00

Maioria dos usuários usa o mesmo código para diversos serviços e não é criativa na hora de criá-lo. Aprenda truques para não cair nesse erro.

A senha de sua conta de e-mail é a última linha de defesa que você tem em se tratando de privacidade; se um usuário inescrupuloso desvendá-la, ele poderá alterar seus códigos para redes sociais, portais de comércio eletrônico ou até do internet banking, a partir da opção “esqueci minha senha”.

É tentador utilizar o mesmo segredo para todas suas contas, mas, dessa forma, a vulnerabilidade online aumenta consideravelmente. Quando ela é descoberta, tudo o que você tem na Web fica aberto ao invasor. Dado os recentes acontecimentos, como a invasão da rede PSN, esta talvez seja a hora de aprimorar sua segurança, garantindo que cada uma de suas senhas sejam únicas e eficazes.

Existem alguns bons programas para organizar o possível caos, como o KeePass, que criptografa todos os seus códigos e os armazena em uma base de dados a qual só você tem acesso – a partir de uma chave-mestra. Outra opção é o LastPass, que funciona como uma extensão para o browser – roda nos mais populares – e ainda sincroniza seus códigos entre os vários computadores em que estiver instalado. O problema, lógico, é que a nuvem pode não ser tão confiável quanto um pen drive – devidamente protegido – que sempre está contigo.

Usar um gerenciador de senhas é uma ótima forma de melhorar sua segurança online, mas não é um modelo perfeito. A muralha praticamente intransponível é um código que você nunca guarda em um papel, em um HD ou na nuvem, uma sequência de letras, números e símbolos que mesmo você não sabe ao certo até ter de escrevê-la. Isso, a princípio, pode parecer confuso, fora de alcance, mas, com alguns truques mnemônicos, tudo fica mais fácil.

Uma senha acima de todas

Na verdade, é muito fácil criar uma senha forte; basta seguir certas regras. Antes de mais nada, precisamos de uma base: uma mistura de letras maiúsculas e minúsculas, números e até sinais gráficos para complicar um poucos as coisas. Escolha uma frase fácil de lembrar e sinta-se livre para ser tão criativo quanto consiga. Pelo bem da simplicidade – e da didática – irei com um dos meus pratos favoritos: chicken adobo (frango adobo).

Certifique-se de que sua “palavra código” (passphrase) tenha ao menos oito caracteres e evite tópicos obviamente memoráveis como nomes próprios, datas de aniversários e cidades natal. Também é interessante evitar o uso de uma única palavra e a troca de alguns dos caracteres por símbolos – as ferramentas dos hackers são sofisticadas o suficiente para superar esse truque. Prefira uma frase secreta – várias palavras colocadas juntas – em vez de uma senha; isso torna mais difícil o trabalho dos hackers para descobrir seu código ao tentar todas as palavras do dicionário.

Agora que escolheu uma palavra código, você precisa colocar essa frase em uma única corrente (como chickenadobo), e então coloque algumas letras maiúsculas fáceis de lembrar (ChickenAdobo). Depois, apimente mais a base do seu código com alguns caracteres aleatórios para manter as coisas interessantes (Ch!cken@dob0).

Depois de definir seu código base, é preciso memorizá-lo e usá-lo como uma chave mestra que vai destravar sua conta em qualquer site desde que você se mantenha firme a algumas regras simples. Para criar a senha mais forte possível, vamos inventar um padrão de nomeação fácil de guardar para gerar uma senha única para todos os seus cadastros.

Por exemplo, vamos dizer que decidi usar sempre a primeira e quarta letra do nome de domínio no meio da minha passphrase, deixando a primeira maiúscula e a última minúscula. Isso significa que minha senha única no Facebbok seria “Ch!ckenFe@dob0”, enquanto minha conta no Hotmail exigiria a senha “Ch!ckenHo@dob0”.

Vê o padrão? Invente algo parecido e terá uma senha única alfanumérica para todo site. Uma que é fácil de lembrar, mas quase impossível para os hackers descobrirem. Nenhuma senha é perfeita, mas ter sua própria frase única e alguns truques mnemônicos já é um grande passo para manter sua privacidade online intacta.

(Alex Wawro)

Fonte:http://idgnow.uol.com.br/seguranca/2011/05/04/aprenda-a-criar-senhas-fortes-e-proteja-suas-contas-dos-cibercriminosos/

Publicada em 05 de maio de 2011 às 09h00

Maioria dos usuários usa o mesmo código para diversos serviços e não é criativa na hora de criá-lo. Aprenda truques para não cair nesse erro.

A senha de sua conta de e-mail é a última linha de defesa que você tem em se tratando de privacidade; se um usuário inescrupuloso desvendá-la, ele poderá alterar seus códigos para redes sociais, portais de comércio eletrônico ou até do internet banking, a partir da opção “esqueci minha senha”.

É tentador utilizar o mesmo segredo para todas suas contas, mas, dessa forma, a vulnerabilidade online aumenta consideravelmente. Quando ela é descoberta, tudo o que você tem na Web fica aberto ao invasor. Dado os recentes acontecimentos, como a invasão da rede PSN, esta talvez seja a hora de aprimorar sua segurança, garantindo que cada uma de suas senhas sejam únicas e eficazes.

Existem alguns bons programas para organizar o possível caos, como o KeePass, que criptografa todos os seus códigos e os armazena em uma base de dados a qual só você tem acesso – a partir de uma chave-mestra. Outra opção é o LastPass, que funciona como uma extensão para o browser – roda nos mais populares – e ainda sincroniza seus códigos entre os vários computadores em que estiver instalado. O problema, lógico, é que a nuvem pode não ser tão confiável quanto um pen drive – devidamente protegido – que sempre está contigo.

Usar um gerenciador de senhas é uma ótima forma de melhorar sua segurança online, mas não é um modelo perfeito. A muralha praticamente intransponível é um código que você nunca guarda em um papel, em um HD ou na nuvem, uma sequência de letras, números e símbolos que mesmo você não sabe ao certo até ter de escrevê-la. Isso, a princípio, pode parecer confuso, fora de alcance, mas, com alguns truques mnemônicos, tudo fica mais fácil.

Uma senha acima de todas

Na verdade, é muito fácil criar uma senha forte; basta seguir certas regras. Antes de mais nada, precisamos de uma base: uma mistura de letras maiúsculas e minúsculas, números e até sinais gráficos para complicar um poucos as coisas. Escolha uma frase fácil de lembrar e sinta-se livre para ser tão criativo quanto consiga. Pelo bem da simplicidade – e da didática – irei com um dos meus pratos favoritos: chicken adobo (frango adobo).

Certifique-se de que sua “palavra código” (passphrase) tenha ao menos oito caracteres e evite tópicos obviamente memoráveis como nomes próprios, datas de aniversários e cidades natal. Também é interessante evitar o uso de uma única palavra e a troca de alguns dos caracteres por símbolos – as ferramentas dos hackers são sofisticadas o suficiente para superar esse truque. Prefira uma frase secreta – várias palavras colocadas juntas – em vez de uma senha; isso torna mais difícil o trabalho dos hackers para descobrir seu código ao tentar todas as palavras do dicionário.