Autor: Reis, Fábio Wanderley

Fonte: O Globo, 22/05/2011, O País, p. 4

Caso Palocci abre discussão sobre influência de empresas, afirma cientista político

ENTREVISTA Para o cientista político Fábio Wanderley Reis, professor emé-rito da Universidade Federal de Minas Gerais e autor do livro ¿Política e racionalidade¿, a justificativa do ministro Antonio Palocci para suas atividades de consultoria após a saída do Ministério da Fazenda ¿a de que a passagem por instituições como o ministério, o Banco Central ou o BNDES ¿proporciona experiência única, que dá enorme valora esses profissionais¿ ¿ mostra a influência e o peso dos interesses privados na administração pública. Isso evidencia uma convivência que, se não chega a ser ilegal, não é do interesse do país, diz ele.

Reis defende ampla discussão sobre otema ea montagem de uma legislação que evite ou minimize a influência de poderosos grupos privados na administração pública, no jogo eleitoral e no processo legislativo. A atual legislação, que permite que servidores públicos eleitos mantenham cargos na iniciativa privada desde que não usem sua posição para conceder benefícios, é considerada insuficiente. Reis não acredita que os legisladores tenham preocupação com uma prática da qual se beneficiam: ¿Pouco se debate sobre mecanismos que grupos com poder financeiro do setor privado possuem para influenciar a administração do que é público.

Gilberto Scofield SÃO PAULO

O GLOBO: O que o episódio envolvendo o ministro Palocci ensina sobre limites entre interesses privados e setor público?

FÁBIOWANDERLEY REIS: A legislação atual que permite que servidores públicos eleitos trabalhem no setor privado é contraditória e precisa de uma regulamentação mais minuciosa. O trânsito entre osetor público e o setor privado pode ser fonte de recursos para uma pessoa, mas esta fonte de recursos pode não ser do interesse público. O caso de consultorias que prestam informações sobre as melhores formas de acesso ao governo é claramente isso. Tratase de uma mensagem implícita na nota divulgada pela assessoria do próprio ministro.

Como assim?

REIS: Quando o ministro admite que a passagem de uma pessoa por cargos públicos de importância, como Ministério da Fazenda, Banco Central ou BNDES ¿proporciona experiência única, que dá enorme valor a esses profissionais¿, admite que o fato de estar na condição de ex-ministro lhe dá facilidades de ganhos na iniciativa privada. Ele candidamente se qualifica ao dominar determinados assuntos de interesse público. Só quem se beneficia disso é ele e os empresários, a peso de ouro.O público brasileiro não se beneficia. Não há interesse público nisso. Se ele pegasse a informação amealhada em anos como ministro e a tornasse pública, ela perderia o valor estratégico e ele não ganharia dinheiro. É claramente um problema ético envolvendo o interesse público.

A quarentena resolve?

REIS: É uma maneira de minimizar um problema que precisa demais debate. Isso precisa ser objeto de uma enorme discussão e muito trabalho para os legisladores, que não me parecem nem um pouco interessados em mudar esta situação, que também os beneficia. Discutimos muito a regulamentação dos recursos políticos que o Estado possui para influenciar ou controlar a iniciativa privada, tendo em vista que a exacerbação no uso destes recursos pode levar a repressões, autoritarismos ou ditaduras. É justo. Mas pouco se debate sobre os mecanismos que grupos com poder financeiro do setor privado possuem para influenciar a administração do que é público. E isso é um ponto igualmente importante a ser regulamentado, como os lobbies no Congresso Nacional ou no Poder Executivo.

Regulamentar lobbies, como nos EUA, seria interessante?

REIS: Não acho que o exemplo americano deva ser seguido. A regulamentação está longe de ser o ideal porque há uma influência excessiva dos lobbies na dinâmica do processo eleitoral e no processo legislativo americano. O crescimento de proporções avassaladoras do Partido Republicano nos últimos anos tem a ver com a influência dos recursos privados no processo eleitoral americano. Imagine no Brasil, onde não há regras sobre o tema. Oque se busca é diminuir ou neutralizar a influência do interesse privado no jogo eleitoral e no legislativo.

Financia mento público de campanhas é uma saída?

REIS: O direito de votar é universal, mas o direito de ser votado não está assegurado e é garantido pelo poder advindo do dinheiro privado. Um Henrique Meirelles (ex-presidente do Banco Central) terá muito menos dificuldade de ser deputado, se quiser, do que outra pessoa. É preciso regular as possibilidades de acesso ao poder, das indicações às eleições. E proteger o interesse público dos interesses privados.

Fonte:http://www2.senado.gov.br/bdsf/bitstream/id/200259/1/noticia.htm

Translate

sábado, 4 de junho de 2011

Título: Educação em marcha à ré

Fonte: O Estado de São Paulo, 22/05/2011, Notas e informações, p. A3

Além do atraso com que foi enviado ao Congresso, o Plano Nacional de Educação (PNE) para 2011-2020 não deverá ser aprovado tão cedo. Ele está em fase de audiências públicas e, em seguida, será examinado por uma comissão de especialistas escolhidos no mês passado.

As mais importantes das 20 metas do PNE propõem para os próximos dez anos a criação de 4,3 milhões de vagas em creches e pré-escolas, a erradicação do analfabetismo, a redução em 50% do analfabetismo funcional, a adoção do ensino em tempo integral em 50% das escolas públicas, o aumento em 33% do número de vagas no ensino superior e a equiparação do salário médio dos professores das escolas públicas com formação superior ao rendimento de profissionais de outros setores com escolaridade equivalente - o que implicará um aumento de 60% a 1,9 milhão de professores.

As metas são ambiciosas e os especialistas em educação e finanças discutem se a União, os Estados e os municípios terão recursos suficientes para atingi-las. Pelos cálculos do Ministério da Educação, a implantação do PNE deverá custar cerca de R$ 61 bilhões aos cofres públicos. Já os especialistas em investimentos educacionais falam em R$ 80 bilhões. O projeto determina que os governos federal, estaduais e municipais ampliem progressivamente o investimento público em educação até atingir 7% do Produto Interno Bruto (PIB), em 2020. Esse porcentual estava previsto no PNE válido para o período 2001-2010, mas, segundo as entidades do setor educacional, a meta não foi cumprida. Atualmente, o País investe 5% do PIB em educação.

Os especialistas afirmam que, a exemplo do que ocorreu com o último Plano, o novo PNE não define com clareza a responsabilidade financeira de cada ente da Federação. Também não fecha as brechas que permitem aos Estados e municípios contabilizar na conta da educação itens que nada têm a ver com atividade de ensino.

Havendo poucos pontos objetivos a debater, as discussões em torno do PNE acabam sendo extravagantes. Entidades ligadas à educação, por exemplo, estão propondo que o investimento público no setor atinja no mínimo 10% do PIB no final da década - o que é irrealista. Em nome da "valorização do magistério público", sindicatos e associações corporativas pleiteiam que os salários dos professores do ensino básico sejam equiparados aos vencimentos dos professores do ensino superior. E, a título de subsidiar os debates, o Ministério da Educação acaba de enviar para a Câmara dos Deputados dois documentos - nenhum dos quais esclarece quais serão as fontes de recursos para o setor educacional nos próximos dez anos.

Em entrevista ao jornal Valor, o ministro Fernando Haddad acrescentou pouco ao óbvio, dizendo que o dinheiro dependerá do crescimento da economia e do aumento da arrecadação da União, dos Estados e dos municípios. Já os especialistas em educação e orçamento alegam que os dois documentos do MEC tornaram o debate ainda mais confuso, uma vez que trazem dados que não constam da versão original do PNE. Além disso, consultores da União Nacional dos Secretários Municipais da Educação questionam o valor escolhido pelo MEC para calcular a ampliação da oferta de vagas no ensino básico nos próximos dez anos. Segundo eles, as autoridades educacionais subestimaram o gasto efetivo por aluno na educação infantil e na educação de jovens e adultos, o que afetou a estimativa dos recursos que serão necessários com a inclusão de novos alunos.

A tramitação do PNE é mais uma evidência da incapacidade das autoridades educacionais de promover a melhora no ensino. Há um ano, o Conselho Nacional de Educação aprovou parecer detalhando o que considera ser indispensável para melhorar a qualidade do ensino. O documento define número médio de alunos por turma, piso salarial do magistério e quantidade de livros, dicionários, equipamentos eletrônicos e cadeiras por escola. Até hoje, porém, o MEC não decidiu se homologa ou rejeita a proposta. Simplesmente, não sabe o que fazer.

Fonte:http://www2.senado.gov.br/bdsf/bitstream/id/200242/1/noticia.htm

Além do atraso com que foi enviado ao Congresso, o Plano Nacional de Educação (PNE) para 2011-2020 não deverá ser aprovado tão cedo. Ele está em fase de audiências públicas e, em seguida, será examinado por uma comissão de especialistas escolhidos no mês passado.

As mais importantes das 20 metas do PNE propõem para os próximos dez anos a criação de 4,3 milhões de vagas em creches e pré-escolas, a erradicação do analfabetismo, a redução em 50% do analfabetismo funcional, a adoção do ensino em tempo integral em 50% das escolas públicas, o aumento em 33% do número de vagas no ensino superior e a equiparação do salário médio dos professores das escolas públicas com formação superior ao rendimento de profissionais de outros setores com escolaridade equivalente - o que implicará um aumento de 60% a 1,9 milhão de professores.

As metas são ambiciosas e os especialistas em educação e finanças discutem se a União, os Estados e os municípios terão recursos suficientes para atingi-las. Pelos cálculos do Ministério da Educação, a implantação do PNE deverá custar cerca de R$ 61 bilhões aos cofres públicos. Já os especialistas em investimentos educacionais falam em R$ 80 bilhões. O projeto determina que os governos federal, estaduais e municipais ampliem progressivamente o investimento público em educação até atingir 7% do Produto Interno Bruto (PIB), em 2020. Esse porcentual estava previsto no PNE válido para o período 2001-2010, mas, segundo as entidades do setor educacional, a meta não foi cumprida. Atualmente, o País investe 5% do PIB em educação.

Os especialistas afirmam que, a exemplo do que ocorreu com o último Plano, o novo PNE não define com clareza a responsabilidade financeira de cada ente da Federação. Também não fecha as brechas que permitem aos Estados e municípios contabilizar na conta da educação itens que nada têm a ver com atividade de ensino.

Havendo poucos pontos objetivos a debater, as discussões em torno do PNE acabam sendo extravagantes. Entidades ligadas à educação, por exemplo, estão propondo que o investimento público no setor atinja no mínimo 10% do PIB no final da década - o que é irrealista. Em nome da "valorização do magistério público", sindicatos e associações corporativas pleiteiam que os salários dos professores do ensino básico sejam equiparados aos vencimentos dos professores do ensino superior. E, a título de subsidiar os debates, o Ministério da Educação acaba de enviar para a Câmara dos Deputados dois documentos - nenhum dos quais esclarece quais serão as fontes de recursos para o setor educacional nos próximos dez anos.

Em entrevista ao jornal Valor, o ministro Fernando Haddad acrescentou pouco ao óbvio, dizendo que o dinheiro dependerá do crescimento da economia e do aumento da arrecadação da União, dos Estados e dos municípios. Já os especialistas em educação e orçamento alegam que os dois documentos do MEC tornaram o debate ainda mais confuso, uma vez que trazem dados que não constam da versão original do PNE. Além disso, consultores da União Nacional dos Secretários Municipais da Educação questionam o valor escolhido pelo MEC para calcular a ampliação da oferta de vagas no ensino básico nos próximos dez anos. Segundo eles, as autoridades educacionais subestimaram o gasto efetivo por aluno na educação infantil e na educação de jovens e adultos, o que afetou a estimativa dos recursos que serão necessários com a inclusão de novos alunos.

A tramitação do PNE é mais uma evidência da incapacidade das autoridades educacionais de promover a melhora no ensino. Há um ano, o Conselho Nacional de Educação aprovou parecer detalhando o que considera ser indispensável para melhorar a qualidade do ensino. O documento define número médio de alunos por turma, piso salarial do magistério e quantidade de livros, dicionários, equipamentos eletrônicos e cadeiras por escola. Até hoje, porém, o MEC não decidiu se homologa ou rejeita a proposta. Simplesmente, não sabe o que fazer.

Fonte:http://www2.senado.gov.br/bdsf/bitstream/id/200242/1/noticia.htm

Título: A espertocracia educacional

Autor: Torquato, Gaudêncio

Fonte: O Estado de São Paulo, 22/05/2011, Espaço aberto, p. A2

Machado de Assis, mulato, gago e epilético, um dos mais ilustrados e respeitados cultores do idioma pátrio, conseguiu de modo exemplar unir o erudito ao popular. Em seus irretocáveis escritos, ensinava que a democracia deixa de ser uma coisa sagrada quando se transforma em "espertocracia" - "o governo de todos os feitios e de todas as formas". Já de Rui Barbosa, pequena estatura, advogado, diplomata, político e jornalista, cujo nome está inscrito nos anais da história do Direito internacional, pode-se extrair uma singela lição de seu celebrado patrimônio intelectual: "A musa da gramática não conhece entranhas". Pois bem, esses dois curtos arremates dos renomados mestres de nossa língua escrita e falada vêm a calhar neste momento em que a perplexidade assoma ante a barbaridade, patrocinada pelo Ministério da Educação (MEC), de uma "nova gramática", cuja autora assim ensina: "Os livro ilustrado mais interessante estão emprestado", como frase adequada à linguagem oral, está correta ao ser usada em certos contextos.

Para o grande Rui, a letra da gramática não entra em curvas e evita estratagemas. E o aforista Machado puxa a orelha dos "espertocratas", aqueles que bagunçam ao escrever tal como falam, usando todos os feitios e formas. E arremata de maneira cortante: "A primeira condição de quem escreve é não aborrecer". Aborrecimento é o que não falta quando vemos "sábios pareceristas", contratados pelo MEC, exibindo o argumento: seja na forma "nós pega o peixe" ou "nós pegamos o peixe", o pescado estará na rede. Se assim é, ambas estão corretas. Para dar mais voltas no quarteirão da polêmica, a pasta da Educação alega que não é o Ministério da Verdade. Donde se conclui que um doidivanas qualquer, desses que se encontram no feirão das ofertas gramaticais estapafúrdias, pode vir a propor um texto sobre a História do Brasil sem nexo, com figurantes trocados e português estropiado. Basta receber o imprimatur de outra figura extravagante que seja docente de Português para ser adotado nas escolas. Com esse arranjo, o pacote educacional tem condições de receber o endosso da instância mais alta da educação no País para circular nas salas de aula. Esse é o caminho percorrido pelo acervo didático que faz a cabeça da estudantada.

Analisemos as questões suscitadas pela obra Por uma Vida Melhor, a começar pela indagação filosófica que se pinça do título da série. Terá uma vida melhor o estudante que se obriga a aprender numa gramática alternativa, onde a "norma popular" se imbrica à norma culta? Ou, para usar a expressão da professora Heloisa Ramos, autora do livro, sofrem os alunos que escrevem errado "preconceito linguístico"? Primeiro, é oportuno lembrar que, mesmo concordando que a língua é um organismo vivo, evolutivo, não se pode confundir uma coisa com a outra, a forma oral e a norma escrita. Cada compartimento deve ser posto em seu devido lugar. Quem troca uma pela outra ou as junta na mesma gaveta gramatical o faz por alguma intenção, algo que ultrapassa as fronteiras linguísticas. E é nesse campo que surgem os atores, aqui cognominados de doidivanas. Mais parece um grupo que considera a língua instrumento para administrar preconceitos, elevar a cidadania e o estado de espírito dos menos instruídos. Como se pode aduzir, embute-se na questão um viés ideológico, coisa que se vem desenvolvendo no País na esteira de um populismo embalado com o celofane da demagogia.

Ora, os desprotegidos, os semianalfabetos, os analfabetos funcionais, enfim, as massas ignaras não serão elevadas aos andares mais altos da pirâmide se lhes for dada apenas a escada do pseudonivelamento das regras do idioma. Esta é, seguramente, um meio de ascensão social. Mas seus usuários precisam entender que a chave do elevador está guardada nos cofres normativos. Igualmente, as vestimentas, os modos e costumes, a teia de amigos, as referências profissionais são motores dessa escalada. Por que, então, os doidivanas da cultura e da educação investem com tanta força para elevar a linguagem popular ao patamar da norma culta? Não entendem que são objetos diferentes? Por que tanto esforço para defender uma feição que valida erros grosseiros? Não há outra resposta: ideologização. Imaginam o uso da língua como arma revolucionária. O sentimento que inspira os cultores da ignorância só pode ser o de que para melhorar a autoestima e ter uma vida melhor a população menos alfabetizada pode escrever como fala. Como se a gramática normativa devesse ser arquivada para dar lugar à gramática descritiva. Sob essa abordagem, sorver a sopa fazendo barulho, à moda dos nossos bisavós, também poderia ser recomendável...

As concessões demagógicas que se fazem em nome de uma "educação democrática" apenas reforçam a estrutura do atraso que abriga o ensino público básico do País, responsável pelo analfabetismo funcional que atinge um terço da população. Avolumam-se os contingentes de jovens de 9 a 14 anos que, além de não saberem interpretar um texto, se restringem ao exercício de copiar palavras sem entender o seu significado. Os copistas constituem os batalhões avançados da "revolução" empreendida pela educação brasileira. Pior é constatar que os "revolucionários" creem firmemente que a escalada social deve continuar a ser puxada pela carroça do século 17, fechando os olhos à "mobralização" da universidade. E assim, passada a primeira década do século 21, no auge das mudanças tecnológicas que cercam a Era da Informação, emerge um processo de embrutecimento do tecido social. Alicerçado pela argamassa de escândalos, desprezo às leis, violência desmesurada, promessas não cumpridas.

O grande Rui bem que profetizara: "A degeneração de um povo, de uma nação ou raça começa pelo desvirtuamento da própria língua".

JORNALISTA, PROFESSOR TITULAR DA USP E CONSULTOR POLÍTICO E DE COMUNICAÇÃO

fonte:http://www2.senado.gov.br/bdsf/bitstream/id/200240/1/noticia.htm

Fonte: O Estado de São Paulo, 22/05/2011, Espaço aberto, p. A2

Machado de Assis, mulato, gago e epilético, um dos mais ilustrados e respeitados cultores do idioma pátrio, conseguiu de modo exemplar unir o erudito ao popular. Em seus irretocáveis escritos, ensinava que a democracia deixa de ser uma coisa sagrada quando se transforma em "espertocracia" - "o governo de todos os feitios e de todas as formas". Já de Rui Barbosa, pequena estatura, advogado, diplomata, político e jornalista, cujo nome está inscrito nos anais da história do Direito internacional, pode-se extrair uma singela lição de seu celebrado patrimônio intelectual: "A musa da gramática não conhece entranhas". Pois bem, esses dois curtos arremates dos renomados mestres de nossa língua escrita e falada vêm a calhar neste momento em que a perplexidade assoma ante a barbaridade, patrocinada pelo Ministério da Educação (MEC), de uma "nova gramática", cuja autora assim ensina: "Os livro ilustrado mais interessante estão emprestado", como frase adequada à linguagem oral, está correta ao ser usada em certos contextos.

Para o grande Rui, a letra da gramática não entra em curvas e evita estratagemas. E o aforista Machado puxa a orelha dos "espertocratas", aqueles que bagunçam ao escrever tal como falam, usando todos os feitios e formas. E arremata de maneira cortante: "A primeira condição de quem escreve é não aborrecer". Aborrecimento é o que não falta quando vemos "sábios pareceristas", contratados pelo MEC, exibindo o argumento: seja na forma "nós pega o peixe" ou "nós pegamos o peixe", o pescado estará na rede. Se assim é, ambas estão corretas. Para dar mais voltas no quarteirão da polêmica, a pasta da Educação alega que não é o Ministério da Verdade. Donde se conclui que um doidivanas qualquer, desses que se encontram no feirão das ofertas gramaticais estapafúrdias, pode vir a propor um texto sobre a História do Brasil sem nexo, com figurantes trocados e português estropiado. Basta receber o imprimatur de outra figura extravagante que seja docente de Português para ser adotado nas escolas. Com esse arranjo, o pacote educacional tem condições de receber o endosso da instância mais alta da educação no País para circular nas salas de aula. Esse é o caminho percorrido pelo acervo didático que faz a cabeça da estudantada.

Analisemos as questões suscitadas pela obra Por uma Vida Melhor, a começar pela indagação filosófica que se pinça do título da série. Terá uma vida melhor o estudante que se obriga a aprender numa gramática alternativa, onde a "norma popular" se imbrica à norma culta? Ou, para usar a expressão da professora Heloisa Ramos, autora do livro, sofrem os alunos que escrevem errado "preconceito linguístico"? Primeiro, é oportuno lembrar que, mesmo concordando que a língua é um organismo vivo, evolutivo, não se pode confundir uma coisa com a outra, a forma oral e a norma escrita. Cada compartimento deve ser posto em seu devido lugar. Quem troca uma pela outra ou as junta na mesma gaveta gramatical o faz por alguma intenção, algo que ultrapassa as fronteiras linguísticas. E é nesse campo que surgem os atores, aqui cognominados de doidivanas. Mais parece um grupo que considera a língua instrumento para administrar preconceitos, elevar a cidadania e o estado de espírito dos menos instruídos. Como se pode aduzir, embute-se na questão um viés ideológico, coisa que se vem desenvolvendo no País na esteira de um populismo embalado com o celofane da demagogia.

Ora, os desprotegidos, os semianalfabetos, os analfabetos funcionais, enfim, as massas ignaras não serão elevadas aos andares mais altos da pirâmide se lhes for dada apenas a escada do pseudonivelamento das regras do idioma. Esta é, seguramente, um meio de ascensão social. Mas seus usuários precisam entender que a chave do elevador está guardada nos cofres normativos. Igualmente, as vestimentas, os modos e costumes, a teia de amigos, as referências profissionais são motores dessa escalada. Por que, então, os doidivanas da cultura e da educação investem com tanta força para elevar a linguagem popular ao patamar da norma culta? Não entendem que são objetos diferentes? Por que tanto esforço para defender uma feição que valida erros grosseiros? Não há outra resposta: ideologização. Imaginam o uso da língua como arma revolucionária. O sentimento que inspira os cultores da ignorância só pode ser o de que para melhorar a autoestima e ter uma vida melhor a população menos alfabetizada pode escrever como fala. Como se a gramática normativa devesse ser arquivada para dar lugar à gramática descritiva. Sob essa abordagem, sorver a sopa fazendo barulho, à moda dos nossos bisavós, também poderia ser recomendável...

As concessões demagógicas que se fazem em nome de uma "educação democrática" apenas reforçam a estrutura do atraso que abriga o ensino público básico do País, responsável pelo analfabetismo funcional que atinge um terço da população. Avolumam-se os contingentes de jovens de 9 a 14 anos que, além de não saberem interpretar um texto, se restringem ao exercício de copiar palavras sem entender o seu significado. Os copistas constituem os batalhões avançados da "revolução" empreendida pela educação brasileira. Pior é constatar que os "revolucionários" creem firmemente que a escalada social deve continuar a ser puxada pela carroça do século 17, fechando os olhos à "mobralização" da universidade. E assim, passada a primeira década do século 21, no auge das mudanças tecnológicas que cercam a Era da Informação, emerge um processo de embrutecimento do tecido social. Alicerçado pela argamassa de escândalos, desprezo às leis, violência desmesurada, promessas não cumpridas.

O grande Rui bem que profetizara: "A degeneração de um povo, de uma nação ou raça começa pelo desvirtuamento da própria língua".

JORNALISTA, PROFESSOR TITULAR DA USP E CONSULTOR POLÍTICO E DE COMUNICAÇÃO

fonte:http://www2.senado.gov.br/bdsf/bitstream/id/200240/1/noticia.htm

REFORMULAÇÃO DOS INSTRUMENTOS DE AVALIAÇÃO DOS CURSOS DE GRADUAÇÃO DA EDUCAÇÃO SUPERIOR PARA OPERACIONALIZAÇÃO DO SISTEMA NACIONAL DE AVALIAÇÃO DA EDUCAÇÃO SUPERIOR - Sinaes

1. Introdução

O Instituto Nacional de Estudos e Pesquisas Educacionais Anísio Teixeira (Inep), por meio da Diretoria de Avaliação da Educação Superior (DAES), coordenou no ano de 2010 e 2011 a revisão dos instrumentos de avaliação utilizados no Sistema Nacional de Avaliação da Educação Superior (Sinaes).

Esse trabalho surgiu em observância ao disposto na Lei n° 10.861, de 14 de abril de 2004, no Decreto n° 5.773, de 09 de maio de 2006, que define como uma das competências do Inep elaborar os instrumentos de avaliação e na Portaria Normativa n° 40, de 12 de dezembro de 2007, consolidada e publicada em 29 de dezembro de 2010, que atribui à Diretoria de Avaliação da Educação Superior - DAES/Inep as decisões sobre os procedimentos de avaliação.

A reformulação dos instrumentos foi realizada pela Comissão de Revisão dos Instrumentos de Avaliação, coordenada pela DAES, mediante solicitação da Comissão Nacional de Avaliação da Educação Superior (Conaes), em reunião ordinária. Por meio da Portaria Inep nº 386, de 27 de setembro de 2010, publicada no DOU em 28/09/2010, Seção 2, página 18, a comissão foi oficializada.

Esta Nota Técnica tem como objetivo informar sobre a reformulação dos Instrumentos de Avaliação de Cursos de Graduação e apresentar a proposta elaborada pela Comissão de Revisão dos Instrumentos, aprovada pela Conaes em reuniões realizadas nos meses de abril e maio de 2011.

Cabe esclarecer que o presente documento refere-se, exclusivamente, aos instrumentos de avaliação dos cursos de graduação. O instrumento de avaliação institucional está em elaboração.

2. Dos Instrumentos

2.1. O Sinaes tem como uma de suas finalidades aferir a qualidade para a melhoria da educação superior. A avaliação entendida como um processo exige uma medida operacionalizada por instrumento que possibilita o registro de análises quantitativas e qualitativas em relação a uma qualidade padrão.

Considerando que o processo de avaliação da educação superior é contínuo e necessário, a DAES exerce sua competência legal de reformular os instrumentos de avaliação de cursos de graduação, de acordo com o artigo 7º, IV e V, Decreto nº 5.773, de 09 de maio de 2006:

"Art.7º No que diz respeito à matéria objeto deste Decreto, compete ao INEP:

(...)

IV- elaborar os instrumentos de avaliação conforme as diretrizes da CONAES;

V- elaborar os instrumentos de avaliação para credenciamento de instituições e autorização de cursos, conforme as diretrizes do CNE e das Secretarias, conforme o caso"...

2.2. A reformulação dos instrumentos partiu de uma padronização inicial dos 12 instrumentos de avaliação dos cursos de graduação, uma vez que eles apresentavam diferentes critérios de análise.

Os instrumentos analisados foram:

Instrumento de Avaliação de Autorização de Curso de Graduação em Medicina;

Instrumento de Avaliação de Autorização de Curso de Graduação em Direito;

Instrumento de Avaliação de Autorização de Curso de Graduação Licenciatura e Bacharelado;

Instrumento de Avaliação de Autorização de Curso de Graduação Tecnológico;

Instrumento de Avaliação de Reconhecimento de Curso de Graduação em Medicina;

Instrumento de Avaliação de Reconhecimento de Curso de Graduação em Direito;

Instrumento de Avaliação de Reconhecimento de Curso de Graduação em Pedagogia;

Instrumento de Avaliação de Reconhecimento de Curso de Graduação Licenciatura e Bacharelado;

Instrumento de Avaliação de Reconhecimento de Curso de Graduação Tecnológico;

Instrumento de Renovação de Reconhecimento de Cursos de Graduação;

Instrumento de Avaliação de Reconhecimento de Curso a Distância;

Instrumento de Avaliação de Autorização de Curso a Distância.

2.3. Na padronização dos instrumentos de avaliação de cursos de graduação utilizaram-se como referência os indicadores de avaliação e seus descritores das respectivas dimensões, conforme o artigo 4º da Lei n° 10.861, de 14 de abril de 2004, em escala crescente de excelência de 1 a 5.

A padronização dos instrumentos considerou a abrangência e a flexibilização de modo a garantir, no processo avaliativo, um resultado fidedigno dos cursos de graduação e a melhoria da qualidade como referencial básico dos processos de regulação e supervisão da educação superior (Parágrafo único, Art. 2º da Lei n° 10.861, de 14 de abril de 2004).

Os instrumentos de avaliação dos cursos de graduação foram reformulados, respeitando as Diretrizes Curriculares Nacionais dos Cursos, os princípios e diretrizes do Sinaes e os padrões de qualidade da educação superior, resultando em:

Instrumento de Avaliação de Curso de Graduação Bacharelado, Licenciatura e Tecnológico - Presencial e EAD (Autorização, Reconhecimento e Renovação de Reconhecimento); NOVO

Instrumento de Avaliação de Curso de Graduação em Direito – Presencial e EAD (Autorização, Reconhecimento e Renovação de Reconhecimento); NOVO

Instrumento de Avaliação de Curso de Graduação em Medicina –(Autorização, Reconhecimento e Renovação de Reconhecimento). NOVO

2.4 Os critérios de análise que subsidiam o conceito atribuído ao indicador de todos os instrumentos estão colocados em escala crescente de excelência de 1 a 5. Consequentemente, com base na média entre os conceitos de cada indicador obtém-se o conceito da dimensão. As dimensões Organização Didático-Pedagógica, Corpo Docente e Infraestrutura permanecem, alterando-se os indicadores de modo a padronizar os procedimentos provendo sustentação aos conceitos atribuídos.

Todos os instrumentos possuem a mesma escala de análise, a saber:

Conceito Descrição

1 Quando os indicadores da dimensão avaliada configuram um conceito NÃO EXISTENTE.

2 Quando os indicadores da dimensão avaliada configuram um conceito INSUFICIENTE.

3 Quando os indicadores da dimensão avaliada configuram um conceito SUFICIENTE.

4 Quando os indicadores da dimensão avaliada configuram um conceito MUITO BOM/MUITO BEM.

5 Quando os indicadores da dimensão avaliada configuram um conceito EXCELENTE.

Os instrumentos deixam de se dividir por ato autorizativo com diferentes critérios de análise e mantêm-se um único conjunto de critérios de análise que passa a contemplar todos os atos a serem avaliados: Autorização, Reconhecimento e Renovação de Reconhecimento de curso.

A diferença na avaliação de distintos atos regulatórios se reflete na presença de nomenclaturas no texto dos critérios de análise. Estes critérios dispõem das expressões previsto/implantado e regulamentado/institucionalizado. As expressões previsto e regulamentado são consideradas para a avaliação do primeiro ato (Autorização de curso) e as expressões implantado e institucionalizado para os atos subseqüentes (Reconhecimento, Renovação de Reconhecimento de cursos e para os indicadores da dimensão infraestrutura no ato de autorização).

Cada indicador apresenta predominantemente um objeto de análise e a inclusão do critério Não Se Aplica (NSA) para as especificidades.

O resultado atribuído ao relatório (Conceito de Curso - CC) é a média ponderada dos conceitos gerados em cada dimensão, considerando seus pesos, conforme publicação nos respectivos extratos.

Os pesos por ato e dimensão são: Autorização de Curso (Organização Didático-Pedagógica - 30, Corpo Docente - 30 e Infraestrutura - 40); Reconhecimento e Renovação de Reconhecimento de Curso (Organização Didático-Pedagógica - 40, Corpo Docente - 30 e Infraestrutura - 30).

3. Do Período de Transição

Durante o período de transição dos instrumentos vigentes para os instrumentos reformulados serão observadas as seguintes regras:

a) todos os processos que estiverem na fase INEP/AVALIAÇÃO aguardando preenchimento de formulário eletrônico de avaliação (FE) terão seus formulários disponibilizados conforme os novos instrumentos.

b) os processos que possuem formulários de avaliação preenchidos nos instrumentos anteriores serão avaliados segundo os padrões estabelecidos nos instrumentos em que foram preenchidos. Portanto, não se adequarão aos instrumentos reformulados.

4. Das Considerações Finais

Em cumprimento a Portaria Normativa n°. 40, de 12 de dezembro de 2007, consolidada em 29 de dezembro de 2010, que atribui à Diretoria de Avaliação da Educação Superior – DAES/Inep as decisões sobre os procedimentos de avaliação e a responsabilidade de rever periodicamente os seus instrumentos e procedimentos de avaliação, esta diretoria torna pública a reformulação dos instrumentos, visando maior ajuste às diferentes realidades da Educação Superior no país.

Nessa perspectiva, os indicadores dos instrumentos e as alterações que se fizerem necessárias ao longo do processo avaliativo se darão de modo a atualizar tais indicadores com o intuito de democratizar esse processo, que deve contar com a participação da comunidade acadêmica. Em atividade conjunta - Inep e Conaes - realizarão Audiências Públicas para a apresentação dos instrumentos.

Diante de novas especificidades, os avaliadores que compõem o Banco de Avaliadores do Sinaes – BASis serão habilitados de acordo com os novos procedimentos.

Os instrumentos de avaliação estarão disponíveis na página do Inep para consulta pelas IES e demais interessados nos processos avaliativos do Sinaes.

Brasília, 01 de junho de 2011.

SUZANA SCHWERZ FUNGHETTO

Coordenadora-Geral de Avaliação dos Cursos de Graduação e Instituições do Ensino Superior

CGACGIES/DAES/Inep/MEC

CLÁUDIA MAFFINI GRIBOSKI

Diretora de Avaliação da Educação Superior

DAES/Inep/MEC

Fonte:http://portal.inep.gov.br/web/guest/nota-tecnica1

O Instituto Nacional de Estudos e Pesquisas Educacionais Anísio Teixeira (Inep), por meio da Diretoria de Avaliação da Educação Superior (DAES), coordenou no ano de 2010 e 2011 a revisão dos instrumentos de avaliação utilizados no Sistema Nacional de Avaliação da Educação Superior (Sinaes).

Esse trabalho surgiu em observância ao disposto na Lei n° 10.861, de 14 de abril de 2004, no Decreto n° 5.773, de 09 de maio de 2006, que define como uma das competências do Inep elaborar os instrumentos de avaliação e na Portaria Normativa n° 40, de 12 de dezembro de 2007, consolidada e publicada em 29 de dezembro de 2010, que atribui à Diretoria de Avaliação da Educação Superior - DAES/Inep as decisões sobre os procedimentos de avaliação.

A reformulação dos instrumentos foi realizada pela Comissão de Revisão dos Instrumentos de Avaliação, coordenada pela DAES, mediante solicitação da Comissão Nacional de Avaliação da Educação Superior (Conaes), em reunião ordinária. Por meio da Portaria Inep nº 386, de 27 de setembro de 2010, publicada no DOU em 28/09/2010, Seção 2, página 18, a comissão foi oficializada.

Esta Nota Técnica tem como objetivo informar sobre a reformulação dos Instrumentos de Avaliação de Cursos de Graduação e apresentar a proposta elaborada pela Comissão de Revisão dos Instrumentos, aprovada pela Conaes em reuniões realizadas nos meses de abril e maio de 2011.

Cabe esclarecer que o presente documento refere-se, exclusivamente, aos instrumentos de avaliação dos cursos de graduação. O instrumento de avaliação institucional está em elaboração.

2. Dos Instrumentos

2.1. O Sinaes tem como uma de suas finalidades aferir a qualidade para a melhoria da educação superior. A avaliação entendida como um processo exige uma medida operacionalizada por instrumento que possibilita o registro de análises quantitativas e qualitativas em relação a uma qualidade padrão.

Considerando que o processo de avaliação da educação superior é contínuo e necessário, a DAES exerce sua competência legal de reformular os instrumentos de avaliação de cursos de graduação, de acordo com o artigo 7º, IV e V, Decreto nº 5.773, de 09 de maio de 2006:

"Art.7º No que diz respeito à matéria objeto deste Decreto, compete ao INEP:

(...)

IV- elaborar os instrumentos de avaliação conforme as diretrizes da CONAES;

V- elaborar os instrumentos de avaliação para credenciamento de instituições e autorização de cursos, conforme as diretrizes do CNE e das Secretarias, conforme o caso"...

2.2. A reformulação dos instrumentos partiu de uma padronização inicial dos 12 instrumentos de avaliação dos cursos de graduação, uma vez que eles apresentavam diferentes critérios de análise.

Os instrumentos analisados foram:

Instrumento de Avaliação de Autorização de Curso de Graduação em Medicina;

Instrumento de Avaliação de Autorização de Curso de Graduação em Direito;

Instrumento de Avaliação de Autorização de Curso de Graduação Licenciatura e Bacharelado;

Instrumento de Avaliação de Autorização de Curso de Graduação Tecnológico;

Instrumento de Avaliação de Reconhecimento de Curso de Graduação em Medicina;

Instrumento de Avaliação de Reconhecimento de Curso de Graduação em Direito;

Instrumento de Avaliação de Reconhecimento de Curso de Graduação em Pedagogia;

Instrumento de Avaliação de Reconhecimento de Curso de Graduação Licenciatura e Bacharelado;

Instrumento de Avaliação de Reconhecimento de Curso de Graduação Tecnológico;

Instrumento de Renovação de Reconhecimento de Cursos de Graduação;

Instrumento de Avaliação de Reconhecimento de Curso a Distância;

Instrumento de Avaliação de Autorização de Curso a Distância.

2.3. Na padronização dos instrumentos de avaliação de cursos de graduação utilizaram-se como referência os indicadores de avaliação e seus descritores das respectivas dimensões, conforme o artigo 4º da Lei n° 10.861, de 14 de abril de 2004, em escala crescente de excelência de 1 a 5.

A padronização dos instrumentos considerou a abrangência e a flexibilização de modo a garantir, no processo avaliativo, um resultado fidedigno dos cursos de graduação e a melhoria da qualidade como referencial básico dos processos de regulação e supervisão da educação superior (Parágrafo único, Art. 2º da Lei n° 10.861, de 14 de abril de 2004).

Os instrumentos de avaliação dos cursos de graduação foram reformulados, respeitando as Diretrizes Curriculares Nacionais dos Cursos, os princípios e diretrizes do Sinaes e os padrões de qualidade da educação superior, resultando em:

Instrumento de Avaliação de Curso de Graduação Bacharelado, Licenciatura e Tecnológico - Presencial e EAD (Autorização, Reconhecimento e Renovação de Reconhecimento); NOVO

Instrumento de Avaliação de Curso de Graduação em Direito – Presencial e EAD (Autorização, Reconhecimento e Renovação de Reconhecimento); NOVO

Instrumento de Avaliação de Curso de Graduação em Medicina –(Autorização, Reconhecimento e Renovação de Reconhecimento). NOVO

2.4 Os critérios de análise que subsidiam o conceito atribuído ao indicador de todos os instrumentos estão colocados em escala crescente de excelência de 1 a 5. Consequentemente, com base na média entre os conceitos de cada indicador obtém-se o conceito da dimensão. As dimensões Organização Didático-Pedagógica, Corpo Docente e Infraestrutura permanecem, alterando-se os indicadores de modo a padronizar os procedimentos provendo sustentação aos conceitos atribuídos.

Todos os instrumentos possuem a mesma escala de análise, a saber:

Conceito Descrição

1 Quando os indicadores da dimensão avaliada configuram um conceito NÃO EXISTENTE.

2 Quando os indicadores da dimensão avaliada configuram um conceito INSUFICIENTE.

3 Quando os indicadores da dimensão avaliada configuram um conceito SUFICIENTE.

4 Quando os indicadores da dimensão avaliada configuram um conceito MUITO BOM/MUITO BEM.

5 Quando os indicadores da dimensão avaliada configuram um conceito EXCELENTE.

Os instrumentos deixam de se dividir por ato autorizativo com diferentes critérios de análise e mantêm-se um único conjunto de critérios de análise que passa a contemplar todos os atos a serem avaliados: Autorização, Reconhecimento e Renovação de Reconhecimento de curso.

A diferença na avaliação de distintos atos regulatórios se reflete na presença de nomenclaturas no texto dos critérios de análise. Estes critérios dispõem das expressões previsto/implantado e regulamentado/institucionalizado. As expressões previsto e regulamentado são consideradas para a avaliação do primeiro ato (Autorização de curso) e as expressões implantado e institucionalizado para os atos subseqüentes (Reconhecimento, Renovação de Reconhecimento de cursos e para os indicadores da dimensão infraestrutura no ato de autorização).

Cada indicador apresenta predominantemente um objeto de análise e a inclusão do critério Não Se Aplica (NSA) para as especificidades.

O resultado atribuído ao relatório (Conceito de Curso - CC) é a média ponderada dos conceitos gerados em cada dimensão, considerando seus pesos, conforme publicação nos respectivos extratos.

Os pesos por ato e dimensão são: Autorização de Curso (Organização Didático-Pedagógica - 30, Corpo Docente - 30 e Infraestrutura - 40); Reconhecimento e Renovação de Reconhecimento de Curso (Organização Didático-Pedagógica - 40, Corpo Docente - 30 e Infraestrutura - 30).

3. Do Período de Transição

Durante o período de transição dos instrumentos vigentes para os instrumentos reformulados serão observadas as seguintes regras:

a) todos os processos que estiverem na fase INEP/AVALIAÇÃO aguardando preenchimento de formulário eletrônico de avaliação (FE) terão seus formulários disponibilizados conforme os novos instrumentos.

b) os processos que possuem formulários de avaliação preenchidos nos instrumentos anteriores serão avaliados segundo os padrões estabelecidos nos instrumentos em que foram preenchidos. Portanto, não se adequarão aos instrumentos reformulados.

4. Das Considerações Finais

Em cumprimento a Portaria Normativa n°. 40, de 12 de dezembro de 2007, consolidada em 29 de dezembro de 2010, que atribui à Diretoria de Avaliação da Educação Superior – DAES/Inep as decisões sobre os procedimentos de avaliação e a responsabilidade de rever periodicamente os seus instrumentos e procedimentos de avaliação, esta diretoria torna pública a reformulação dos instrumentos, visando maior ajuste às diferentes realidades da Educação Superior no país.

Nessa perspectiva, os indicadores dos instrumentos e as alterações que se fizerem necessárias ao longo do processo avaliativo se darão de modo a atualizar tais indicadores com o intuito de democratizar esse processo, que deve contar com a participação da comunidade acadêmica. Em atividade conjunta - Inep e Conaes - realizarão Audiências Públicas para a apresentação dos instrumentos.

Diante de novas especificidades, os avaliadores que compõem o Banco de Avaliadores do Sinaes – BASis serão habilitados de acordo com os novos procedimentos.

Os instrumentos de avaliação estarão disponíveis na página do Inep para consulta pelas IES e demais interessados nos processos avaliativos do Sinaes.

Brasília, 01 de junho de 2011.

SUZANA SCHWERZ FUNGHETTO

Coordenadora-Geral de Avaliação dos Cursos de Graduação e Instituições do Ensino Superior

CGACGIES/DAES/Inep/MEC

CLÁUDIA MAFFINI GRIBOSKI

Diretora de Avaliação da Educação Superior

DAES/Inep/MEC

Fonte:http://portal.inep.gov.br/web/guest/nota-tecnica1

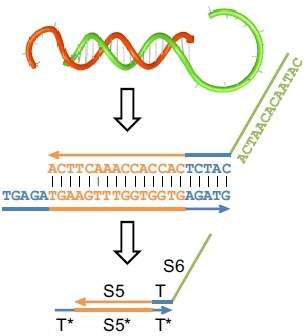

Criado circuito de computador com 74 moléculas de ADN

É o maior circuito de computador biomecânico alguma vez criado: tem 74 moléculas de ADN, calcula a raiz quadrada de números até 15 e faz arredondamentos para o número inteiro mais próximo.

Criado circuito de computador com 74 moléculas de ADN

O feito foi alcançado por investigadores do Instituto de Tecnologia da Califórnia, que substituíram os transístores eletrónicos por sequências de ADN que se ligam ou desligam sempre que entram em contacto com outras sequências de ADN.

Com esta solução, os investigadores norte-americanos encontraram um processo alternativo para o fabrico de um circuito computacional, que pode funcionar como calculadora - mas não se espere que o novo sistema comece já a substituir as máquinas calculadoras convencionais que já se encontram nas lojas.

Além de funcionar num tubo de ensaio, o circuito das 74 moléculas demora cerca de 10 horas a concluir um cálculo, muito por força das interferências pelo contacto gerado com moléculas diferentes, refere a Discovery.

Os autores desta investigação acreditam que o novo circuito biomecânico possa revelar-se útil no desenvolvimento de novos medicamentos.

Fonte:http://aeiou.exameinformatica.pt/criado-circuito-de-computador-com-74-moleculas-de-adn=f1009709

Guia dos curiosos da internet: Google traduz livro digital para português

Obra traz funcionalidades inusitadas, como um marcador de páginas virtual, que permite ao usuário retomar a leitura de onde parou

Como são criadas as páginas da internet ou de que forma é possível garantir a privacidade durante a navegação? Estas e outras perguntas são respondidas no livro digital 20 Lições que Aprendi Sobre Navegadores e Web, criado pelo Google e que acaba de ser traduzido para o português.

O livro, preparado em HTML5, foi lançado no final de 2010, na versão em inglês, com o título 20 Things I Learned about Browsers and the Web e, segundo o Google, virou um sucesso entre professores, desenvolvedores e usuários interessados em entender como a internet funciona.

“Para desenvolver essa experiência da web, nós nos inspiramos nas coisas que adoramos em livros e as ampliamos para o mundo dos bits e bytes, com os recursos das tecnologias modernas da web”, destaca o Google, em seu blog oficial. “Prestamos especial atenção em encontrar o equilíbrio ideal e em acomodar a página e as viradas de página, além de disponibilizar o livro off-line”, acrescenta a empresa.

Entre as funcionalidades do livro virtual, o Google criou marcadores de página virtuais, para que o leitor retome a leitura de onde parou. Além disso, ele conta com um modelo ‘sem luzes’, simulando que o usuário está utilizando uma lanterna sob o cobertor para visualizar as páginas.

Quer acessar o 20 Lições que Aprendi Sobre Navegadores e Web? Entre no endereço http://www.20thingsilearned.com/pt-BR e boa leitura!

Fonte:http://olhardigitalweb1.clientes.ananke.com.br/negocios/digital_news/noticias/guia_dos_curiosos_da_internet_google_traduz_livro_digital_para_portugues?utm_source=Tecla%20Email%20Marketing&utm_medium=emailmarketing&utm_campaign=Guia+dos+Curiosos+da+Internet+%7C+Ataques+no+Hotmail+e+Yahoo&utm_content=S%E9rgio+Reis+sergiocdreis%40yahoo.com

sexta-feira, 3 de junho de 2011

Google, Microsoft e Yahoo juntam forças para melhorar as buscas na web

Por IDG News Service/Miami

As três rivais bancam a Schema.org, uma iniciativa para ajudar os webmasters a utilizar tags HTML melhores para identificar dados estruturados.

Em uma rara demonstração de colaboração, a Google juntou forças com as rivais Microsoft e Yahoo em um projeto concebido para melhorar o recolhimento e a indexação de dados estruturados na web, que são geralmente provenientes de bancos de dados mas perdem sua formatação quando convertidos para HTML.

As três empresas lançaram um site chamado Schema.org, que contém um conjunto comum de tags HTML para ajudar os webmasters a identificar dados estruturados publicados em seus sites.

"O Schema.org pretende ser uma fonte única de recursos para webmasters que buscam marcar suas páginas de forma a ajudar os motores de busca a entender melhor seus sites", afirmou a Google, em seu blog.

Ao promover o uso dessas tags comuns por toda a web, as três empresas esperam que seus motores de busca possam melhorar suas capacidades de identificar, recolher e indexar dados estruturados.

"Muitas aplicações, especialmente motores de busca, podem se beneficiar bastante com o acesso direto a esses dados estruturados. A marcação na página ajuda os motores de busca a entender a informação na página web - o que, por sua vez, colabora na exibição de resultados de busca mais ricos", defende o site Schema.org, em sua página inicial.

O Schema.org contém mais de 100 tags HTML para categorias de dados estruturados como eventos, organizações, pessoas, lugares, produtos, análises, pontuações, filmes e livros.

(Juan Carlos Perez)

Fonte:http://idgnow.uol.com.br/internet/2011/06/02/google-microsoft-e-yahoo-juntam-forcas-para-melhorar-as-buscas-na-web/

As três rivais bancam a Schema.org, uma iniciativa para ajudar os webmasters a utilizar tags HTML melhores para identificar dados estruturados.

Em uma rara demonstração de colaboração, a Google juntou forças com as rivais Microsoft e Yahoo em um projeto concebido para melhorar o recolhimento e a indexação de dados estruturados na web, que são geralmente provenientes de bancos de dados mas perdem sua formatação quando convertidos para HTML.

As três empresas lançaram um site chamado Schema.org, que contém um conjunto comum de tags HTML para ajudar os webmasters a identificar dados estruturados publicados em seus sites.

"O Schema.org pretende ser uma fonte única de recursos para webmasters que buscam marcar suas páginas de forma a ajudar os motores de busca a entender melhor seus sites", afirmou a Google, em seu blog.

Ao promover o uso dessas tags comuns por toda a web, as três empresas esperam que seus motores de busca possam melhorar suas capacidades de identificar, recolher e indexar dados estruturados.

"Muitas aplicações, especialmente motores de busca, podem se beneficiar bastante com o acesso direto a esses dados estruturados. A marcação na página ajuda os motores de busca a entender a informação na página web - o que, por sua vez, colabora na exibição de resultados de busca mais ricos", defende o site Schema.org, em sua página inicial.

O Schema.org contém mais de 100 tags HTML para categorias de dados estruturados como eventos, organizações, pessoas, lugares, produtos, análises, pontuações, filmes e livros.

(Juan Carlos Perez)

Fonte:http://idgnow.uol.com.br/internet/2011/06/02/google-microsoft-e-yahoo-juntam-forcas-para-melhorar-as-buscas-na-web/

Processador molecular faz cálculos usando DNA

Redação do Site Inovação Tecnológica - 03/06/2011

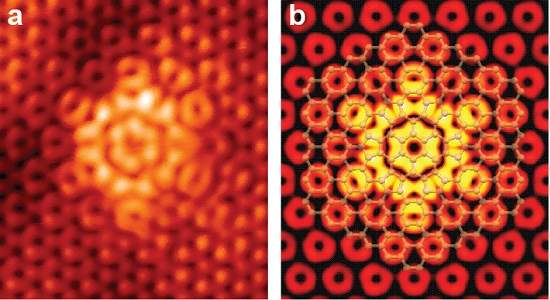

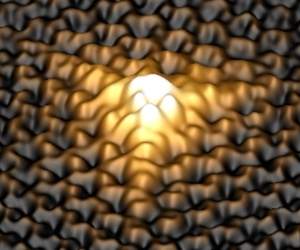

A expectativa dos cientistas é que as pesquisas se encaminhem para a integração dos processadores moleculares em sistemas biológicos, como uma célula viva, para diagnosticar e tratar doenças. [Imagem: Science/AAAS]

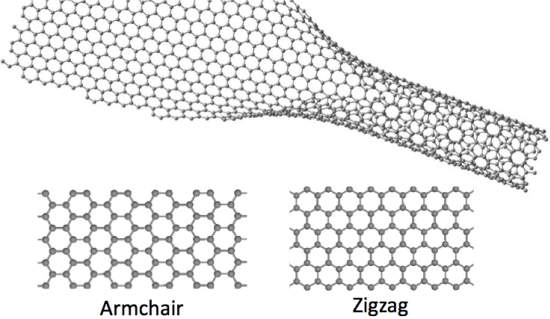

Pesquisadores construíram um computador molecular, no qual os transistores eletrônicos foram substituídos por moléculas de DNA.

Processador de DNA

Lulu Qian e Erik Winfree, do Instituto de Tecnologia da Califórnia, nos Estados Unidos, usaram mais de 100 fitas de DNA para construir seu circuito bioquímico.

As fitas de DNA foram dispostas em múltiplas camadas, formando "circuitos" digitais que podem executar as operações AND, OR, NOR e outras operações lógicas semelhantes.

O projeto representa mais um passo da chamada computação molecular, que demonstra como circuitos bioquímicos mais sofisticados podem ser construídos em escalas cada vez maiores.

Computador utiliza DNA em lugar de transistores

A grande vantagem do uso de DNA, em relação a outras abordagens de computadores químicos, é que essas moléculas são muito estáveis e bem-conhecidas pelos cientistas, havendo muitos recursos técnicos para manipulá-las.

Integração com a biologia

A expectativa dos cientistas é que as pesquisas se encaminhem para a integração desses circuitos em sistemas biológicos, como uma célula viva, por exemplo, para diagnosticar e tratar doenças.

O processador de DNA executa operações lógicas por meio da ligação e replicação das sequências de DNA. [Imagem: Science/AAAS]

O processador de DNA agora construído executa operações lógicas por meio da ligação e replicação das sequências de DNA.

Embora pesquisadores japoneses já tenham demonstrado o princípio de um processador molecular capaz de superar os supercomputadores atuais, o circuito de DNA é bastante lento: ao longo de 10 horas, o processador molecular é capaz de calcular uma raiz quadrada de um número não maior do que 15.

O futuro da computação molecular

Quian e Winfree também construíram um "compilador" para o seu processador de DNA, que permite que seus circuitos bioquímicos sejam programados de forma similar à usada nos circuitos lógicos tradicionais.

Computadores moleculares ganham compilador e ficam mais amigáveis

Isto parece ser uma vantagem, embora ainda não esteja claro se o futuro da computação molecular será imitar os computadores eletrônicos, ou se eles tomarão seu próprio caminho - um processador molecular que imita o cérebro humano, por exemplo, opera naturalmente de forma paralela, fazendo cálculos muito mais rapidamente.

Biocomputadores terão velocidade determinada pelo alimento disponível

Bibliografia:

Scaling Up Digital Circuit Computation with DNA Strand Displacement Cascades

Lulu Qian, Erik Winfree

Science

3 June 2011

Vol.: 332 - pp 1196-1201

DOI: 10.1126/science.1200520

Scaling Up DNA Computation

John H. Reif

Science

3 June 2011

Vol.: 332 - pp 1156-1157

DOI: 10.1126/science.1208068

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=processador-molecular-dna&id=010150110603&ebol=sim

A expectativa dos cientistas é que as pesquisas se encaminhem para a integração dos processadores moleculares em sistemas biológicos, como uma célula viva, para diagnosticar e tratar doenças. [Imagem: Science/AAAS]

Pesquisadores construíram um computador molecular, no qual os transistores eletrônicos foram substituídos por moléculas de DNA.

Processador de DNA

Lulu Qian e Erik Winfree, do Instituto de Tecnologia da Califórnia, nos Estados Unidos, usaram mais de 100 fitas de DNA para construir seu circuito bioquímico.

As fitas de DNA foram dispostas em múltiplas camadas, formando "circuitos" digitais que podem executar as operações AND, OR, NOR e outras operações lógicas semelhantes.

O projeto representa mais um passo da chamada computação molecular, que demonstra como circuitos bioquímicos mais sofisticados podem ser construídos em escalas cada vez maiores.

Computador utiliza DNA em lugar de transistores

A grande vantagem do uso de DNA, em relação a outras abordagens de computadores químicos, é que essas moléculas são muito estáveis e bem-conhecidas pelos cientistas, havendo muitos recursos técnicos para manipulá-las.

Integração com a biologia

A expectativa dos cientistas é que as pesquisas se encaminhem para a integração desses circuitos em sistemas biológicos, como uma célula viva, por exemplo, para diagnosticar e tratar doenças.

O processador de DNA executa operações lógicas por meio da ligação e replicação das sequências de DNA. [Imagem: Science/AAAS]

O processador de DNA agora construído executa operações lógicas por meio da ligação e replicação das sequências de DNA.

Embora pesquisadores japoneses já tenham demonstrado o princípio de um processador molecular capaz de superar os supercomputadores atuais, o circuito de DNA é bastante lento: ao longo de 10 horas, o processador molecular é capaz de calcular uma raiz quadrada de um número não maior do que 15.

O futuro da computação molecular

Quian e Winfree também construíram um "compilador" para o seu processador de DNA, que permite que seus circuitos bioquímicos sejam programados de forma similar à usada nos circuitos lógicos tradicionais.

Computadores moleculares ganham compilador e ficam mais amigáveis

Isto parece ser uma vantagem, embora ainda não esteja claro se o futuro da computação molecular será imitar os computadores eletrônicos, ou se eles tomarão seu próprio caminho - um processador molecular que imita o cérebro humano, por exemplo, opera naturalmente de forma paralela, fazendo cálculos muito mais rapidamente.

Biocomputadores terão velocidade determinada pelo alimento disponível

Bibliografia:

Scaling Up Digital Circuit Computation with DNA Strand Displacement Cascades

Lulu Qian, Erik Winfree

Science

3 June 2011

Vol.: 332 - pp 1196-1201

DOI: 10.1126/science.1200520

Scaling Up DNA Computation

John H. Reif

Science

3 June 2011

Vol.: 332 - pp 1156-1157

DOI: 10.1126/science.1208068

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=processador-molecular-dna&id=010150110603&ebol=sim

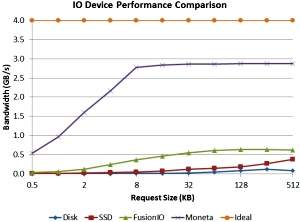

Nova geração de memória revela limitações dos softwares

Redação do Site Inovação Tecnológica - 03/06/2011

Protótipo de sistema de armazenamento de dados, onde se pode ver os módulos Moneta, feitos com memórias de alteração de fase.[Imagem: UC San Diego/Steve Swanson]

SSDs

Pesquisadores da Universidade da Califórnia apresentaram o protótipo de um novo tipo de memória que poderá se tornar a próxima geração dos SSDs.

SSDs (Solid-State Drives) são discos de estado sólido, ou seja, não possuem partes móveis, como os discos rígidos tradicionais.

A nova memória, batizada de Moneta, usa células de memória de alteração de fase, que são milhares de vezes mais rápidas do que os discos rígidos e até sete vezes mais rápidas do que os SSDs atuais.

As memórias de alteração de fase, ou PCM (Phase-Change Memory), armazenam dados na estrutura cristalina de uma liga metálica chamada calcogeneto.

Memória de alteração de fase

Como seu próprio nome indica, um material de alteração de fase alterna entre as fases cristalina e amorfa. Essa alternância é induzida por calor, por sua vez gerado através da aplicação de um pulso elétrico.

Para gravar na memória, é enviado um pulso SET, que coloca o material na sua forma cristalina. Um pulso RESET leva-o de volta para a fase amorfa, apagando o dado.

A leitura é feita fazendo com que uma pequena corrente elétrica atravesse o material, o que permite determinar se ele está em sua fase cristalina ou amorfa.

As memórias PCM são mais rápidas e mais simples de usar do que as memórias flash, a tecnologia que domina o mercado de SSD hoje e equipa os iPads e vários notebooks.

A nova memória de alteração de fase supera largamente todas as memórias atuais, mas parece ser demais para os softwares atuais. [Imagem: Moneta Group]

Moneta

A memória Moneta usa os chips PCM de primeira geração da empresa Micron Technology e pode ler grandes conjuntos de dados a uma taxa de 1,1 gigabyte por segundo e gravar dados a até 371 megabytes por segundo.

Para acessar agrupamentos menores (por exemplo, 512 Bytes), a Moneta pode ser lida a 327 megabytes por segundo e escrita a 91 megabytes por segundo.

Isto fica entre duas e sete vezes mais rápido do que um SSD estado-da-arte, baseado em memória flash.

A nova memória também oferece uma menor latência para cada operação, o que deverá reduzir as exigências de energia para aplicações mais intensivas.

Os pesquisadores anunciaram que deverão construir a segunda geração da memória Moneta nos próximos seis a nove meses, e esperam que a tecnologia esteja pronta para o mercado em poucos anos - o que irá depender de avanços na tecnologia de fabricação das memórias de mudança de fase.

Repensar o armazenamento de dados do futuro

Ao testar esta primeira geração, contudo, já foi possível detectar um outro problema: não basta construir dispositivos de memória mais rápidos; será necessário também atualizar os softwares.

"Os sistemas de armazenamento evoluíram ao longo dos últimos 40 anos para atender aos discos, e os discos são muito, muito lentos," explicou Steven Swanson, coordenador de desenvolvimento da memória Moneta.

"Projetar sistemas de armazenamento que possam tirar proveito total de tecnologias como as memórias de alteração de fase vai exigir que se repense quase todos os aspectos de como o software gerencia e acessa o sistema de armazenamento de dados," prossegue.

"[A nova memória] nos abre uma janela para o futuro dos sistemas de armazenamento, e nos dá a oportunidade de repensar agora a forma como iremos projetar esses sistemas no futuro," conclui Swanson.

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=memoria-alteracao-fase&id=010110110603&ebol=sim

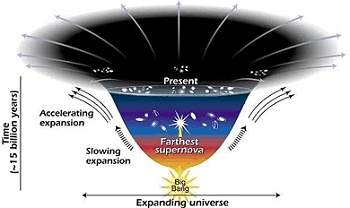

Universo pode não estar em ritmo acelerado de expansão

Com informações da Agência USP - 03/06/2011

Segundo os dois cientistas brasileiros, a hipótese de expansão acelerada do Universo é muito influenciada por modelos, deixando de lado a observação direta. [Imagem: LBL]

Ritmo da expansão

O Universo pode não estar em expansão acelerada.

Na verdade, a observação das estrelas supernovas indica várias possibilidades para a aceleração cósmica, e não se pode prever de forma precisa o ritmo ou a continuidade da expansão.

Esta interpretação está sendo oferecida por Antonio Guimarães e José Ademir Sales de Lima, do Instituto de Astronomia, Geofísica e Ciências Atmosféricas da Universidade de São Paulo (USP).

A partir da análise dos dados das supernovas, os pesquisadores demonstraram que o estado atual do Universo abre um grande número de possíveis variáveis sobre sua expansão ou retração.

Incerteza dos modelos

Segundo Antonio, há cerca de dez anos a observação das supernovas fez com que surgisse um consenso na comunidade científica de que o Universo está em expansão acelerada.

"No entanto, essa hipótese é muito influenciada pelos modelos usados para analisar os dados, diminuindo a importância da observação direta," ressalta.

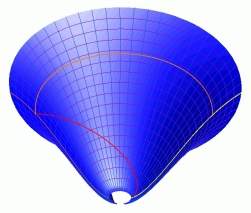

O modelo mais utilizado é o Lambda-CDM (Cold Dark Matter). "Ele é baseado na chamada 'energia escura', de constituição desconhecida, que corresponderia a cerca de 70% de toda a energia do Universo, e seria responsável pela aceleração," explica.

O modelo mais utilizado hoje é o Lambda-CDM, baseado na hipótese da energia escura. [Imagem: Wikimedia]

Descartando a energia escura

A pesquisa dos dois brasileiros se baseou apenas nos dados das supernovas, numa abordagem cosmográfica, sem considerar qualquer modelo de energia escura.

"Por meio das medidas de brilho e desvio para o vermelho (redshift), é possível estimar a distância e a velocidade de afastamento das explosões supernovas," conta Guimarães. "A análise descreve de modo matemático o fator de escala do Universo, isto é, seu tamanho conforme o tempo".

As análises mostraram que houve um período de aceleração recente (acontecido há alguns bilhões de anos). Porém, o estado atual de aceleração é mais incerto do que indicado pelos modelos de energia escura.

A situação seria indeterminada, a expansão pode ser acelerada, mas estar em diminuição, já que o estado atual do Universo é melhor representado por uma distribuição de probabilidades.

Teoria modificada da gravidade é confirmada por galáxias gasosas

Desaceleração

Durante a análise, as supernovas foram divididas em conjuntos diferentes, separadas entre antigas, recentes e muito recentes. "Conforme se adicionava supernovas mais recentes, a curva de probabilidades tendia para valores mais negativos de aceleração, o que pode indicar que o Universo esteja se expandindo de forma menos acelerada", diz Guimarães.

Com a utilização de dados cosmográficos mais recentes, baseados na observação de 557 eventos de supernovas, verificou-se que, quando se excluem as mais antigas, a curva de probabilidades da aceleração apresenta valores menores. "Ou seja, quanto mais recente e próxima, mais ela parece indicar que a expansão seria menos acelerada", acrescenta o pesquisador.

No modelo Lambda-CDM, o Universo se expandiria indefinidamente e a tendência seria a galáxia onde se encontra a Terra ficar cada vez mais distanciada das demais.

"Outros modelos baseados na energia escura falam, por exemplo, em desaceleração e colapso, o chamado 'Big Crunch', mas como a natureza desse tipo de constituinte é pouco conhecida, há muitas possibilidades em aberto", aponta Guimarães. "No caso da análise das supernovas, é possível formular hipóteses sobre o estado atual do Universo, onde as curvas de valor de aceleração podem abarcar tanto valores positivos quanto negativos, o que multiplica as possibilidades sobre a expansão futura".

A Terra é redonda. Mas o Universo é plano?

Bibliografia:

Could the cosmic acceleration be transient? A cosmographic evaluation.

Antonio Guimarães, José Ademir Sales de Lima

Classical and Quantum Gravity

27 Maio 2011

Vol.: 28, Number 12, p. 125026

DOI: 10.1088/0264-9381/28/12/125026

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=universo-nao-estar-ritmo-acelerado-expansao&id=010830110603&ebol=sim

Segundo os dois cientistas brasileiros, a hipótese de expansão acelerada do Universo é muito influenciada por modelos, deixando de lado a observação direta. [Imagem: LBL]

Ritmo da expansão

O Universo pode não estar em expansão acelerada.

Na verdade, a observação das estrelas supernovas indica várias possibilidades para a aceleração cósmica, e não se pode prever de forma precisa o ritmo ou a continuidade da expansão.

Esta interpretação está sendo oferecida por Antonio Guimarães e José Ademir Sales de Lima, do Instituto de Astronomia, Geofísica e Ciências Atmosféricas da Universidade de São Paulo (USP).

A partir da análise dos dados das supernovas, os pesquisadores demonstraram que o estado atual do Universo abre um grande número de possíveis variáveis sobre sua expansão ou retração.

Incerteza dos modelos

Segundo Antonio, há cerca de dez anos a observação das supernovas fez com que surgisse um consenso na comunidade científica de que o Universo está em expansão acelerada.

"No entanto, essa hipótese é muito influenciada pelos modelos usados para analisar os dados, diminuindo a importância da observação direta," ressalta.

O modelo mais utilizado é o Lambda-CDM (Cold Dark Matter). "Ele é baseado na chamada 'energia escura', de constituição desconhecida, que corresponderia a cerca de 70% de toda a energia do Universo, e seria responsável pela aceleração," explica.

O modelo mais utilizado hoje é o Lambda-CDM, baseado na hipótese da energia escura. [Imagem: Wikimedia]

Descartando a energia escura

A pesquisa dos dois brasileiros se baseou apenas nos dados das supernovas, numa abordagem cosmográfica, sem considerar qualquer modelo de energia escura.

"Por meio das medidas de brilho e desvio para o vermelho (redshift), é possível estimar a distância e a velocidade de afastamento das explosões supernovas," conta Guimarães. "A análise descreve de modo matemático o fator de escala do Universo, isto é, seu tamanho conforme o tempo".

As análises mostraram que houve um período de aceleração recente (acontecido há alguns bilhões de anos). Porém, o estado atual de aceleração é mais incerto do que indicado pelos modelos de energia escura.

A situação seria indeterminada, a expansão pode ser acelerada, mas estar em diminuição, já que o estado atual do Universo é melhor representado por uma distribuição de probabilidades.

Teoria modificada da gravidade é confirmada por galáxias gasosas

Desaceleração

Durante a análise, as supernovas foram divididas em conjuntos diferentes, separadas entre antigas, recentes e muito recentes. "Conforme se adicionava supernovas mais recentes, a curva de probabilidades tendia para valores mais negativos de aceleração, o que pode indicar que o Universo esteja se expandindo de forma menos acelerada", diz Guimarães.

Com a utilização de dados cosmográficos mais recentes, baseados na observação de 557 eventos de supernovas, verificou-se que, quando se excluem as mais antigas, a curva de probabilidades da aceleração apresenta valores menores. "Ou seja, quanto mais recente e próxima, mais ela parece indicar que a expansão seria menos acelerada", acrescenta o pesquisador.

No modelo Lambda-CDM, o Universo se expandiria indefinidamente e a tendência seria a galáxia onde se encontra a Terra ficar cada vez mais distanciada das demais.

"Outros modelos baseados na energia escura falam, por exemplo, em desaceleração e colapso, o chamado 'Big Crunch', mas como a natureza desse tipo de constituinte é pouco conhecida, há muitas possibilidades em aberto", aponta Guimarães. "No caso da análise das supernovas, é possível formular hipóteses sobre o estado atual do Universo, onde as curvas de valor de aceleração podem abarcar tanto valores positivos quanto negativos, o que multiplica as possibilidades sobre a expansão futura".

A Terra é redonda. Mas o Universo é plano?

Bibliografia:

Could the cosmic acceleration be transient? A cosmographic evaluation.

Antonio Guimarães, José Ademir Sales de Lima

Classical and Quantum Gravity

27 Maio 2011

Vol.: 28, Number 12, p. 125026

DOI: 10.1088/0264-9381/28/12/125026

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=universo-nao-estar-ritmo-acelerado-expansao&id=010830110603&ebol=sim

Deletar dados pode resfriar computadores

Simone Ulmer - 02/06/2011

Os cientistas acreditam já haver condições para testar o resfriamento quântico, principalmente agora que já existem supercomputadores quânticos no mercado, como o D-Wave One.[Imagem: D-Wave]

Conhecimento e falta de conhecimento

Seja o seu notebook esquentando os seus joelhos, ou um supercomputador esquentando uma sala inteira, a ideia de que os computadores geram calor é familiar a todos.

Mas um grupo de físicos teóricos acaba de descobrir algo surpreendente: os processos computacionais não são capazes apenas de gerar calor; sob certas condições, eles podem ter um efeito contrário, de resfriamento.

Por trás dessa constatação estão considerações fundamentais relativas ao conhecimento e à falta de conhecimento - clássico e quântico.

Quando os computadores computam, a energia que consomem eventualmente acaba por se transformar em calor. Isto não se deve unicamente à engenharia do computador - a física tem algo a dizer sobre os fundamentos do custo energético do processamento da informação.

A nova pesquisa revela uma surpresa justamente neste nível fundamental.

Deletar dados para esfriar o computador

O grupo demonstrou que deletar dados, sob determinadas condições, pode criar um efeito de resfriamento no computador, ao invés de gerar calor.

O efeito de resfriamento aparece quando se leva em conta o estranho fenômeno quântico do entrelaçamento (ou emaranhamento).

Em última análise, pode ser possível aproveitar esse efeito para resfriar os supercomputadores, que estão com seu aumento de desempenho travado pela geração excessiva de calor.

"Alcançar o controle no nível quântico, que será necessário para implementar isso em supercomputadores, é um enorme desafio tecnológico, mas pode não ser impossível. Nós temos visto um enorme progresso nas tecnologias quânticas nos últimos 20 anos," afirma Vlatko Vedral, da Universidade Nacional de Cingapura.

Com a tecnologia disponível nos laboratórios atuais de física quântica, já deve ser possível fazer um experimento para prova de conceito usando alguns poucos bits de dados, sugere Vedral.

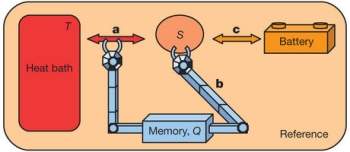

O observador é representado por uma máquina com uma memória quântica (Q), que irá deletar um qubit S, usando uma condição de temperatura T. O observador pode capturar e coletar o calor (a), guardando-o em uma bateria (c). [Imagem: Rio et al./Nature]

Princípio de Landauer

O físico Rolf Landauer calculou, em 1961, que, durante a deleção de dados, é inevitável alguma perda de energia na forma de calor.

Esse chamado Princípio de Landauer implica que, quando um determinado número de operações aritméticas por segundo for excedido, o computador vai produzir tanto calor que será impossível dissipá-lo.

Nos supercomputadores de hoje, outras fontes de calor são mais significativas do que as previstas por Landauer, mas Vedral e seus colegas acreditam que o limiar crítico no qual o calor de Landauer, gerado pelo apagamento de dados, se tornará importante, poderá ser alcançado dentro dos próximos 10 a 20 anos.

A emissão de calor pelo apagamento de dez terabytes de dados de um disco rígido será, em princípio, menor do que um milionésimo de joule.

No entanto, se esse processo for repetido muitas vezes por segundo, então o calor irá se acumular de forma correspondente.

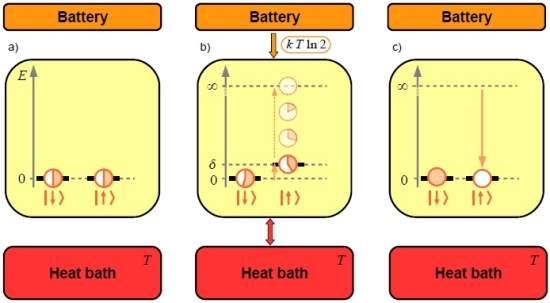

No novo estudo agora publicado, os pesquisadores vão um passo além. Eles demonstram que, quando os bits a serem apagados estão quantum-mecanicamente entrelaçados com o estado de um observador, o observador pode capturar o calor do sistema ao excluir os bits.

O entrelaçamento conecta o estado do observador ao do computador de tal forma que é possível saber mais sobre a memória do que é possível na física clássica.

Dois conceitos de entropia

Para chegar a esse resultado, os cientistas combinaram ideias da teoria da informação e da termodinâmica sobre um conceito conhecido como entropia.

A entropia aparece de maneiras diferentes nessas duas disciplinas, que são, em grande medida, independentes uma da outra.

Na teoria da informação, a entropia é uma medida da densidade de informação. Ela descreve, por exemplo, quanta capacidade de memória um determinado conjunto de dados irá ocupar quando for comprimido de maneira ótima.

Na termodinâmica, por outro lado, a entropia se refere à desordem nos sistemas, por exemplo, ao arranjo das moléculas em um gás. Na termodinâmica, acrescentar entropia a um sistema geralmente equivale a adicionar energia na forma de calor.

"Nós demonstramos agora que, em ambos os casos, o termo entropia está de fato descrevendo a mesma coisa, mesmo no regime da mecânica quântica," explica Renato Renner, do Instituto de Tecnologia de Zurique, na Suíça.

Como as fórmulas para as duas entropias têm mesma aparência, já vinha sendo assumido que havia uma conexão entre elas. "Nosso estudo mostra que, em ambos os casos, a entropia é considerada um tipo de falta de conhecimento," continua Renner.

Entropia negativa

Na medição da entropia, deve-se ter em mente que um objeto não tem uma certa quantidade de entropia por si só - a entropia de um objeto é sempre dependente do observador.

Aplicada ao exemplo de deletar dados, isso significa que, se dois indivíduos excluem dados de uma memória, e um deles tem mais conhecimento desses dados, ele percebe a memória como tendo menos entropia e pode, então, apagar a memória usando menos energia.

A entropia na física quântica tem a propriedade incomum de, algumas vezes, ser negativa, quando calculada a partir do ponto de vista da teoria da informação.

O perfeito conhecimento clássico de um sistema significa que o observador o percebe como tendo entropia zero. Isso significa que a memória do observador e o sistema estarão perfeitamente correlacionados, tanto quanto permitido pela física clássica.

Contudo, o entrelaçamento quântico dá ao observador um "conhecimento mais completo" porque as correlações quânticas são mais fortes do que as correlações clássicas. Isto leva a uma entropia menor do que zero.

Até agora, os físicos teóricos vinham usando essa entropia negativa em seus cálculos sem entender exatamente o que ela poderia significar em termos termodinâmicos ou experimentalmente.

Resfriamento computacional

O apagamento de 10 terabytes de dados gerará menos do que 1 J, mas o calor irá se acumular se esse processo for repetido muitas vezes por segundo. [Imagem: Rio et al./Nature]

No caso do conhecimento clássico perfeito de uma memória de computador (entropia zero), deletar dados teoricamente não exige nenhuma energia.

Os pesquisadores agora comprovaram que "o conhecimento mais do que completo" do entrelaçamento quântico com a memória (entropia negativa) faz com que a operação de deletar dados seja acompanhada pela remoção de calor do computador e sua liberação como energia utilizável.

Esse é o significado físico da entropia negativa.

Renner salienta, contudo, que "isto não significa que nós possamos desenvolver uma máquina de movimento perpétuo", o chamado moto-contínuo.

Isto porque os dados só podem ser excluídos uma vez e, portanto, não há possibilidade de continuar gerando energia continuamente.

O processo também destrói o entrelaçamento quântico, e seria necessário suprir energia para repor o sistema em seu estado inicial.

Inovações na termodinâmica

As equações são consistentes com o que é conhecido como a Segunda Lei da Termodinâmica: a ideia de que a entropia do Universo nunca pode diminuir.

"Estamos trabalhando no limite da Segunda Lei. Se formos só um pouquinho mais longe, iremos quebrá-la," diz Renner.

Estas novas descobertas relativas à entropia na termodinâmica e na teoria da informação podem ter utilidade além de calcular a geração de calor pelos computadores.

Por exemplo, os métodos desenvolvidos no âmbito da teoria da informação para lidar com a entropia poderão levar a inovações na termodinâmica.

De fato, a ligação feita entre os dois conceitos de entropia toca nos fundamentos da física.

Bibliografia:

The thermodynamic meaning of negative entropy

Lídia del Rio, Johan Åberg, Renato Renner, Oscar Dahlsten, Vlatko Vedral

Nature

02 June 2011

Vol.: 474, Pages: 61-63

DOI: 10.1038/nature10123

Fonte:http://www.inovacaotecnologica.com.br/noticias/noticia.php?artigo=conhecimento-quantico-resfriar-computadores&id=010150110602&ebol=sim

Os cientistas acreditam já haver condições para testar o resfriamento quântico, principalmente agora que já existem supercomputadores quânticos no mercado, como o D-Wave One.[Imagem: D-Wave]

Conhecimento e falta de conhecimento